近年来,本地运行大语言模型(LLM)的趋势愈发明显,越来越多的人开始在个人电脑或系统上部署这些模型。

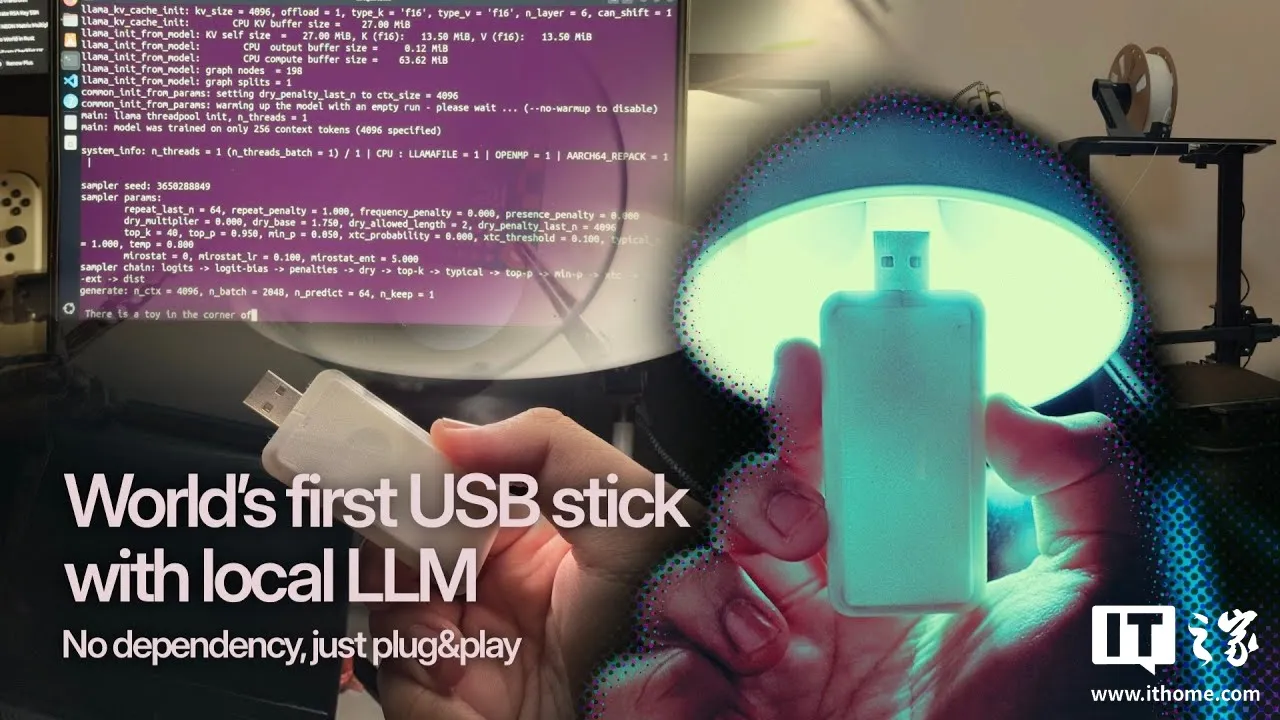

AI在线注意到,越南开发者 Binh Pham 最近尝试使用树莓派 Zero(Raspberry Pi Zero)进行了一项创新实验。他成功地将这款设备改造为一个小型 USB 驱动器,使其能够在本地运行 LLM,无需任何额外设备。这一项目主要得益于 llama.cpp 和 llamafile 的支持,这两者结合了指令集和一系列轻量级软件包,旨在提供一种离线的轻量级聊天机器人体验。

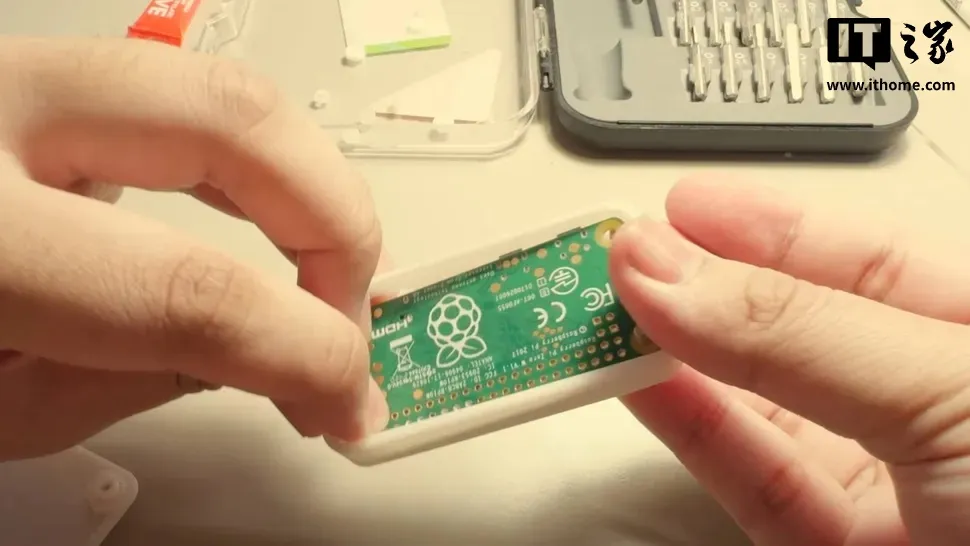

然而,由于树莓派 Zero 已经问世八年,其硬件性能有限,因此将 llama.cpp 移植到该设备并非易事。首先,Pham 将设备连接到 USB 接口,并为其 3D 打印了一个外壳。

在解决了硬件问题后,项目又因树莓派 Zero W 的 512MB 内存限制而变得更加复杂。在尝试将 llama.cpp 编译到该设备时,Pham 遇到了失败,此前也无人尝试在树莓派 Zero 或 One 上编译该软件。

问题的根源在于树莓派 Zero 的 CPU 采用的是 ARMv6 架构。为了克服这一障碍,Pham 不得不对 llama.cpp 的 ARMv8 指令集进行转换,并移除所有基于现代硬件的优化或注释。

在成功修改 llama.cpp 源代码后,Pham 将注意力转向软件的运行和用户体验的优化。他构建了一个基于文本文件输入的 LLM 实现,这些文本文件作为主要的提示,而 LLM 则会根据这些提示生成故事,并以完整的输出文件形式返回。

为了测试性能,Pham 设置了 64 个 token 的限制,并对 15M 到 136M 不等的多个模型进行了基准测试。其中,Tiny15M 模型的每个 token 处理速度为 223 毫秒,而较大的 Lamini-T5-Flan-77M 模型的每个 token 处理速度为 2.5 秒,SmolLM2-136M 模型的每个 token 处理速度为 2.2 秒。

这些 token 处理速度表明,该设备在许多实际应用场景中可能会显得过慢。尽管这一项目具有创新性,但在实际应用中,使用老旧的轻量级硬件运行本地 LLM 并不具备太多实用价值。相比之下,使用更复杂的模型,例如在树莓派 5 上运行 Deepseek,可能会是更好的选择。