香港大学和Adobe联合提出了一种直接在原始像素空间中运行的图像生成模型PixelFlow,这种方法简化了图像生成过程,无需预先训练的变分自编码器 (VAE),并使整个模型能够端到端训练。通过高效的级联流建模,PixelFlow 在像素空间中实现了可承受的计算成本。它在 256x256 ImageNet 类条件图像生成基准上实现了 1.98 的 FID。

- 论文:https://arxiv.org/pdf/2504.07963

- 代码:https://gihub.com/ShoufaChen/PixelFlow

- 试用:https://huggingface.co/spaces/ShoufaChen/PixelFlow

论文介绍

PixelFlow是一系列直接在原始像素空间中运行的图像生成模型,与主流的潜在空间模型形成对比。这种方法简化了图像生成过程,无需预先训练的变分自编码器 (VAE),并使整个模型能够端到端训练。通过高效的级联流建模,PixelFlow 在像素空间中实现了可承受的计算成本。它在 256x256 ImageNet 类条件图像生成基准上实现了 1.98 的 FID。定性的文本转图像结果显示,PixelFlow 在图像质量、艺术性和语义控制方面表现出色。

PixelFlow是一系列直接在原始像素空间中运行的图像生成模型,与主流的潜在空间模型形成对比。这种方法简化了图像生成过程,无需预先训练的变分自编码器 (VAE),并使整个模型能够端到端训练。通过高效的级联流建模,PixelFlow 在像素空间中实现了可承受的计算成本。它在 256x256 ImageNet 类条件图像生成基准上实现了 1.98 的 FID。定性的文本转图像结果显示,PixelFlow 在图像质量、艺术性和语义控制方面表现出色。

方法概述

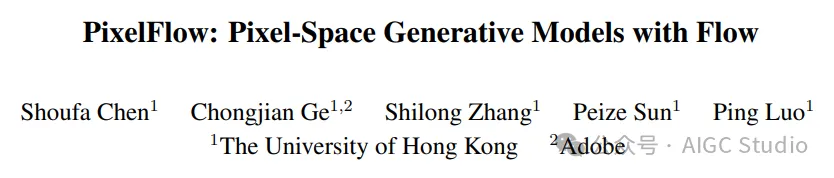

基于潜伏层的扩散模型 (LDM)、基于像素的扩散模型 (PDM) 和 PixelFlow 的设计范式比较:(a) LDM 将训练分为两个独立的阶段——首先独立训练现成的 VAE,然后基于从预训练 VAE 中提取的 token 训练扩散模型;(b) 之前的 PDM 通常训练两个独立的模型:一个用于低分辨率图像的扩散模型和一个用于高分辨率合成的上采样器;(c) 相比之下,PixelFlow 为基于像素的生成提供了端到端的解决方案,兼具高效率和强大的生成性能。

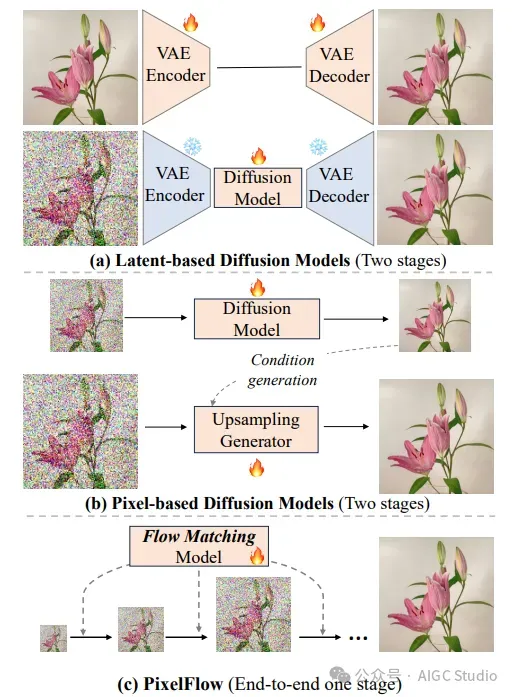

PixelFlow 用于从像素空间进行级联图像生成。将整个生成过程划分为一系列分辨率阶段。在每个分辨率阶段开始时,我们都会将前一阶段中相对嘈杂的结果进行放大,并将其作为当前阶段的起点。因此,随着分辨率的提高,可以获得更精细的样本。

级联阶段中间结果的可视化。从四个阶段中提取中间结果进行直接可视化。我们在各个分辨率阶段观察到清晰的去噪过程。

实验结果

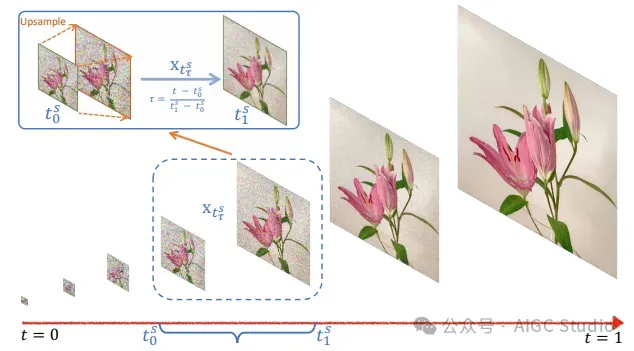

PixelFlow 类条件图像生成的定性结果。所有图像均为 256×256 分辨率。

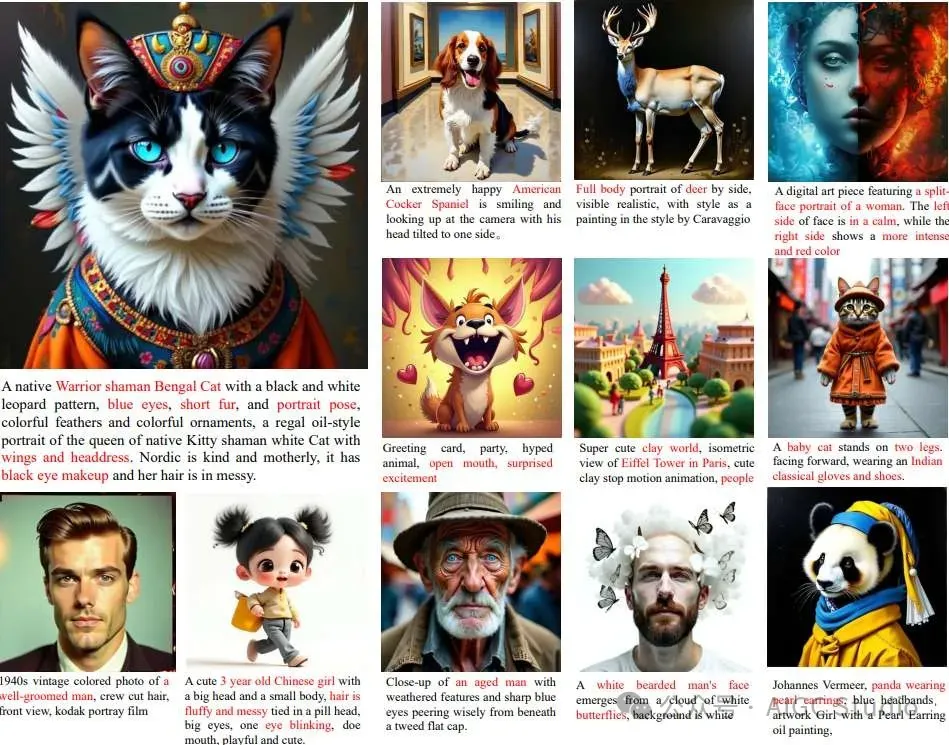

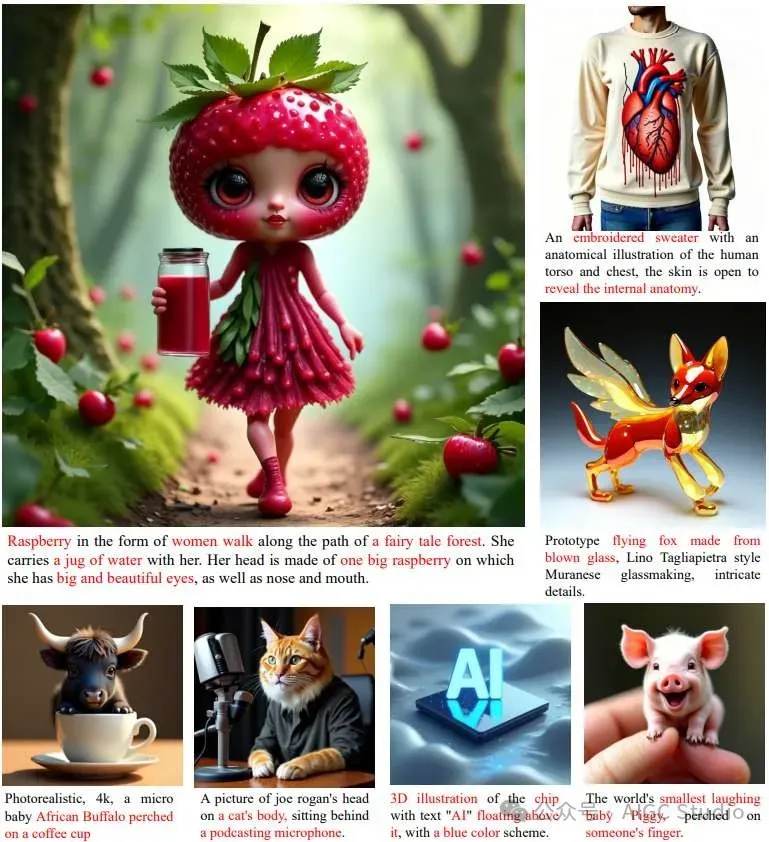

PixelFlow 文本条件生成的定性结果。所有图像均为 512×512 分辨率。题目的关键部分以红色突出显示。

PixelFlow 的定性样本。展示了 1024×1024 分辨率的生成图像。关键词以红色突出显示。

结论

论文推出了一种全新的图像生成模型 PixelFlow,它通过直接在原始像素空间上进行操作,重新思考了基于潜在空间的模型的优势。通过直接在不同分辨率阶段之间进行转换,该模型在简洁性和端到端可训练性方面展现出显著优势。在类条件图像生成和文本到图像生成基准测试中,PixelFlow 已被证明能够比主流的基于潜在空间的方法展现出更强大的图像生成能力。