在这个数字化时代,生成式AI技术正以前所未有的速度改变着我们的创作方式。近期,阿里通义实验室发表了一篇题为《AnyStory: Towards Unified Single and Multi-Subject Personalization in Text-to-Image Generation》的论文,该论文提出了一种创新的框架,旨在通过统一的路径实现单个及多个主体的个性化文本到图像生成,为故事可视化、艺术创作乃至更多领域带来了革命性的突破。

论文中深入探讨了当前文本到图像生成技术面临的挑战,如主体一致性、细节保留以及多主体个性化等方面的不足。为了解决这些问题,他们提出了AnyStory框架,该框架结合了增强的主体表示编码器和解耦的实例感知主体路由器,实现了前所未有的个性化生成效果。

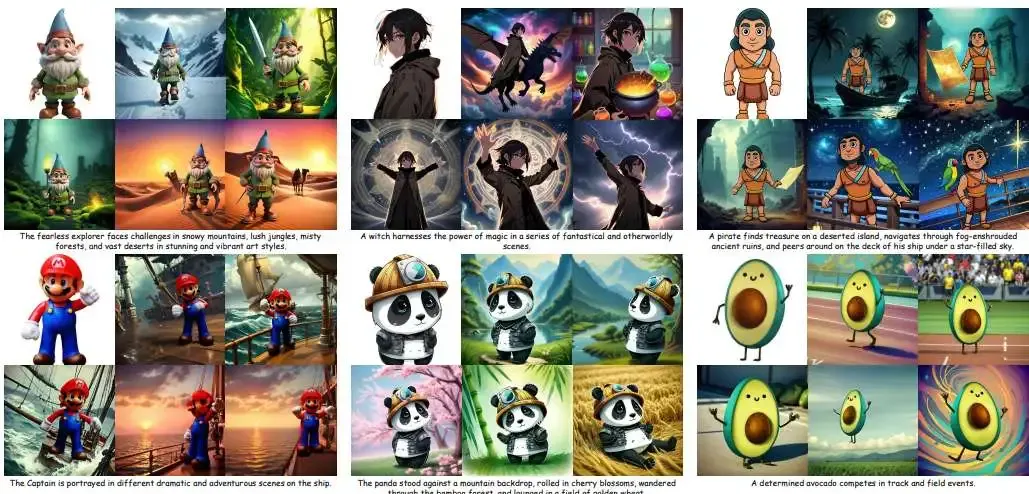

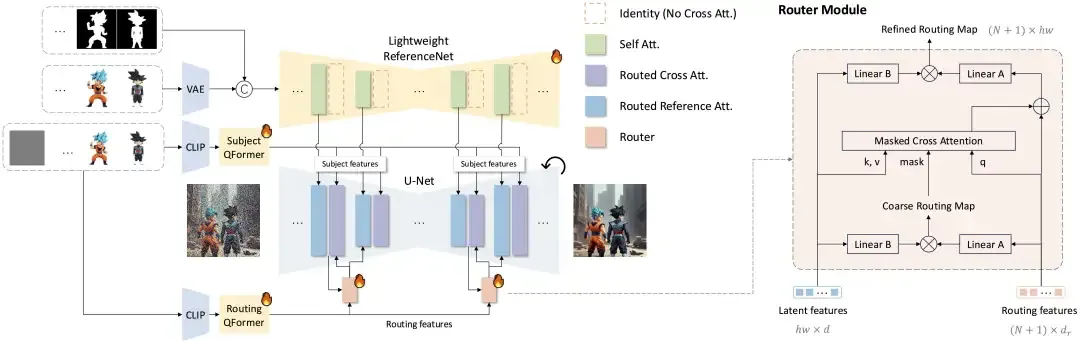

上图为AnyStory的示例。该方法在保留主题细节、对齐文本描述和个性化多个主题方面表现出色。其中纯白色背景的图像作为参考。

上图为AnyStory的示例。该方法在保留主题细节、对齐文本描述和个性化多个主题方面表现出色。其中纯白色背景的图像作为参考。

相关链接

- 论文:https://arxiv.org/pdf/2501.09503v1

- 主页:https://aigcdesigngroup.github.io/AnyStory/

论文介绍

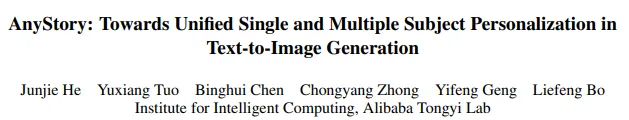

最近,大规模生成模型已经展示了出色的文本到图像生成能力。 然而,生成具有特定主题的高保真个性化图像仍然存在挑战,特别是在涉及多个主题的情况下。论文出了一种统一的个性化主题生成方法 AnyStory。AnyStory 不仅可以实现单个主题的高保真个性化,还可以实现多个主题的高保真个性化,而不会牺牲主题保真度。具体来说,AnyStory 以“编码然后路由”的方式对主题个性化问题进行建模。在编码步骤中,AnyStory 利用通用且强大的图像编码器 ReferenceNet 与 CLIP 视觉编码器结合实现主题特征的高保真编码。在路由步骤中, AnyStory 利用解耦的实例感知主题路由器 准确感知和预测潜在空间中相应主题的潜在位置,并指导主题条件的注入。详细的实验结果证明了我们的方法在保留主题细节、对齐文本描述和针对多个主题进行个性化方面的出色表现。

方法

AnyStory 遵循“编码后路由”的条件生成范式,首先利用简化的 ReferenceNet 结合 CLIP 视觉编码器对主体进行编码,然后利用解耦的实例感知主体路由器引导主体条件注入。训练过程分为两个阶段:主体编码器训练阶段和路由器训练阶段。为简洁起见省略了文本条件分支。

效果展示

论文中的大量实验结果验证了AnyStory在单个及多个主体个性化生成方面的卓越性能。无论是生动的动漫场景、逼真的电影画面,还是充满想象力的奇幻世界,AnyStory都能根据文本提示,生成高度一致且个性化的图像序列。此外,通过可视化路由图,我们可以直观地看到框架如何精确地预测和定位每个主体的潜在位置。