Hopper

算力再飞跃!英伟达官宣下一代AI芯片Rubin,性能剑指Hopper900倍

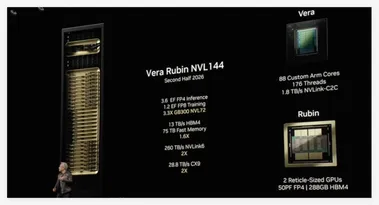

在 GTC2025大会上,英伟达正式官宣其下一代人工智能(AI)芯片平台,并命名为「Vera Rubin」,致敬美国著名天文学家薇拉·鲁宾(Vera Rubin),延续了英伟达以科学家名字命名架构的传统。 该系列的首款产品 Vera Rubin NVL144预计将于2026年下半年发布。 英伟达首席执行官黄仁勋表示,Rubin 的性能将达到当前 Hopper 架构的900倍,相较之下,最新的 Blackwell 架构已经实现了对 Hopper68倍的性能提升,预示着 Rubin 将带来又一次巨大的算力飞跃。

3/19/2025 9:59:00 AM

AI在线

DeepSeek FlashMLA:大模型推理的“涡轮增压器”

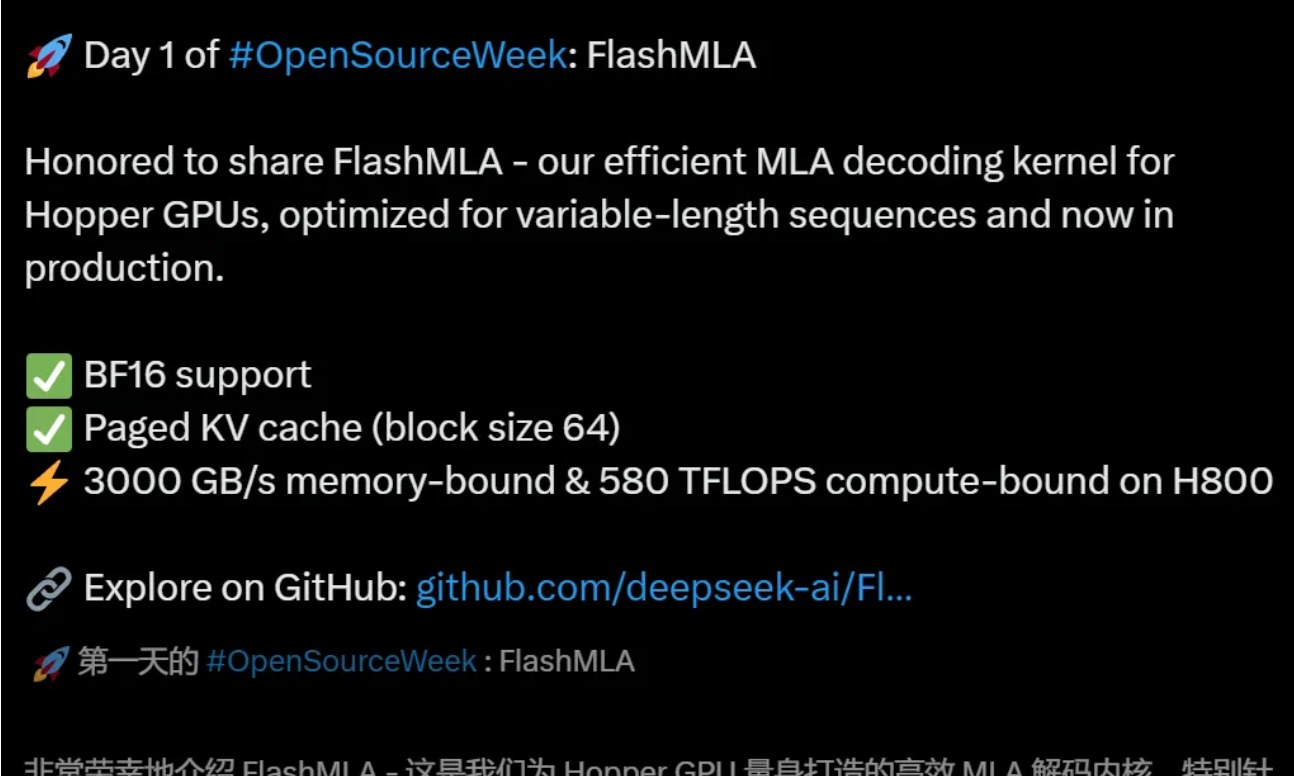

FlashMLA(Flash Multi-head Latent Attention)是DeepSeek针对英伟达Hopper架构GPU(如H800/H100)设计的高效解码内核,其核心技术围绕多头潜在注意力(MLA)机制展开,通过软硬件协同优化实现性能突破

2/25/2025 9:08:12 AM

AI在线

距离“全自动”漏洞挖掘又近了一步!腾讯安全大数据实验室论文入选ACM CCS 2023

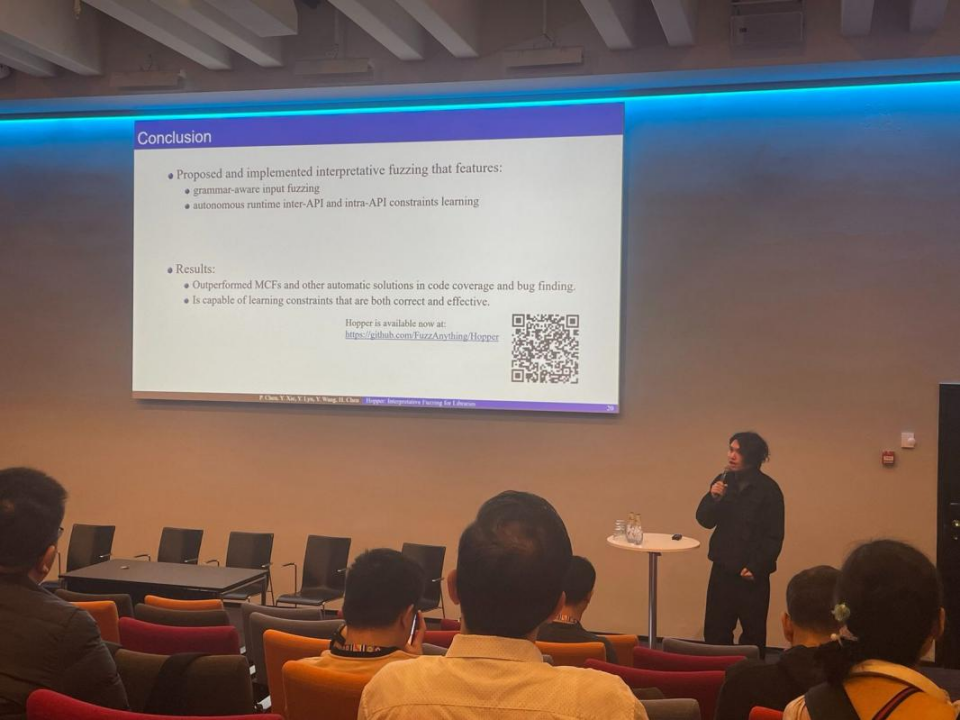

计算机领域国际权威学术顶会ACM CCS 2023于11月26日在丹麦哥本哈根开幕。腾讯安全大数据实验室团队论文《Hopper: Interpretative Fuzzing for Libraries》被大会收录,昨天,实验室研究员谢雨轩受邀出席大会进行主题分享。该论文提出了解释性模糊测试(Interpretative Fuzzing)方法,展示了如何基于动态反馈来学习API内外的约束进行代码自动化生成,从而在没有任何外部专家知识的前提下生成有效可用的代码调用方式,并且根据这些代码来挖掘漏洞。该研究方法的出现旨在

11/29/2023 5:08:00 PM

新闻助手

资讯热榜

标签云

AI

人工智能

OpenAI

AIGC

模型

ChatGPT

谷歌

DeepSeek

AI绘画

大模型

机器人

数据

AI新词

Midjourney

开源

Meta

微软

智能

用户

GPT

学习

技术

智能体

Gemini

马斯克

Anthropic

英伟达

图像

AI创作

训练

LLM

论文

代码

算法

苹果

AI for Science

Agent

Claude

腾讯

芯片

Stable Diffusion

蛋白质

具身智能

开发者

xAI

生成式

神经网络

机器学习

人形机器人

3D

AI视频

RAG

大语言模型

研究

百度

Sora

生成

GPU

工具

华为

字节跳动

计算

AGI

大型语言模型

AI设计

搜索

生成式AI

视频生成

DeepMind

特斯拉

场景

AI模型

深度学习

亚马逊

架构

Transformer

MCP

编程

视觉

预测