编辑 | 伊风

出品 | 51CTO技术栈(微信号:blog51cto)

源神 Qwen3 赶在五一假期前重磅上线!

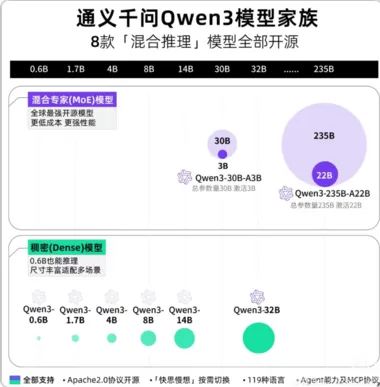

这次 Qwen3 直接放出了一整个“全家桶” ——总共 8 个模型,包括 2 个 MoE(稀疏专家)模型和 6 个稠密模型,规模从 0.6B 到 235B 不等,阵容堪称豪华。

图片

图片

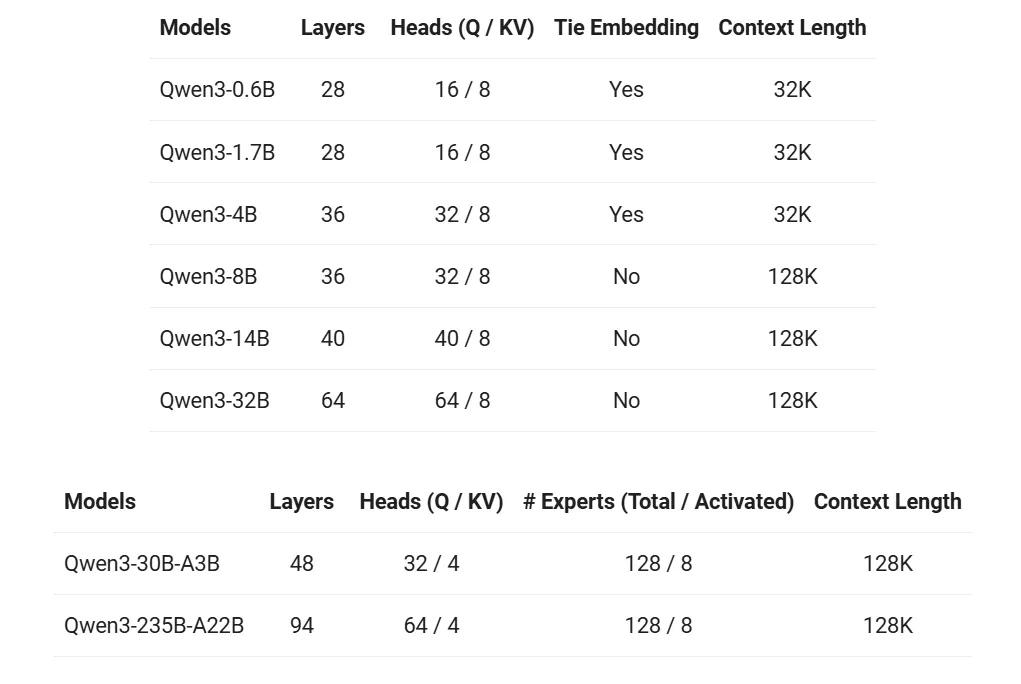

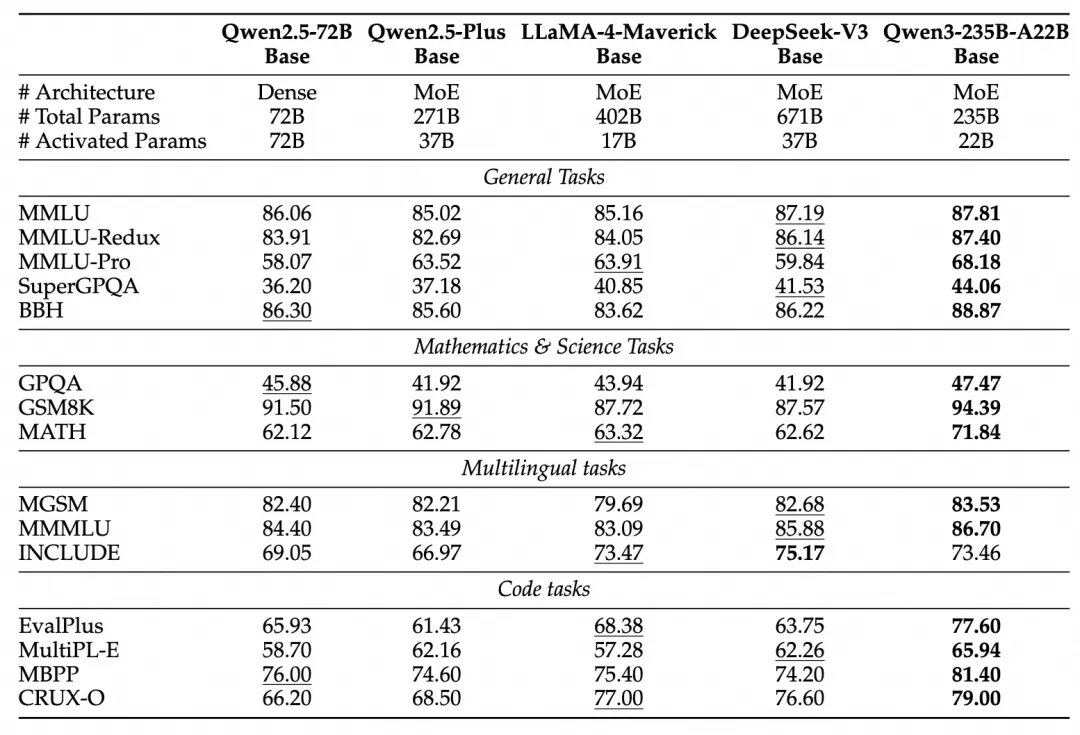

其中,旗舰模型 Qwen3-235B-A22B 强势登顶,成为新一代开源之王!在编码、数学、通用能力等多个基准评测中,表现可与 DeepSeek-R1、o1、o3-mini、Grok-3 和 Gemini-2.5-Pro 等顶尖模型媲美。

图片

图片

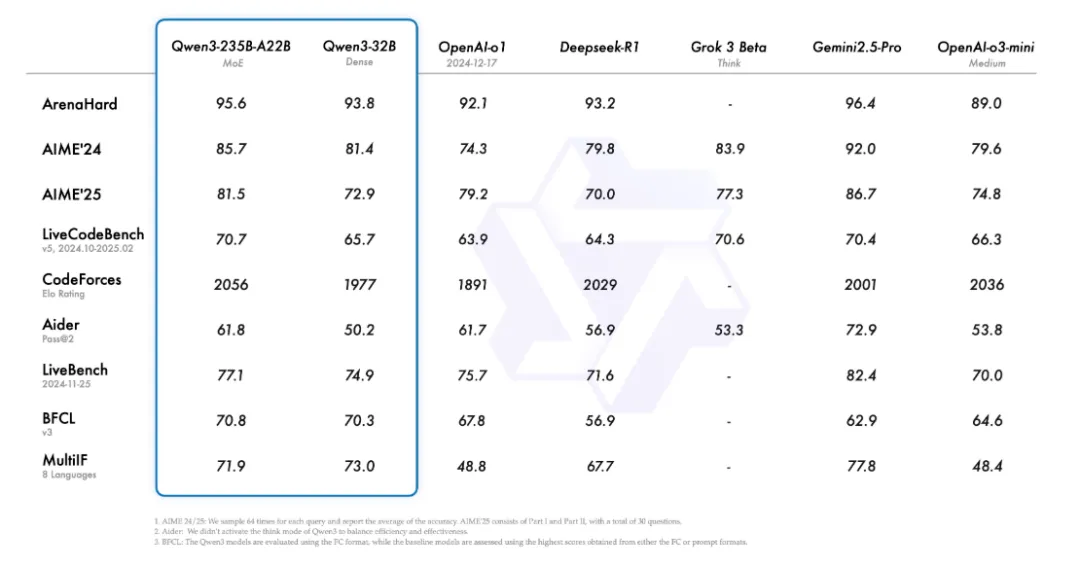

不仅大模型强,小型号也一样能打。小型 MoE 模型 Qwen3-30B-A3B,虽然激活参数量仅有 QwQ-32B 的十分之一,却实现了全面反超;而轻量级 Qwen3-4B,也几乎达到了 Qwen2.5-72B-Instruct 的水平。

图片

图片

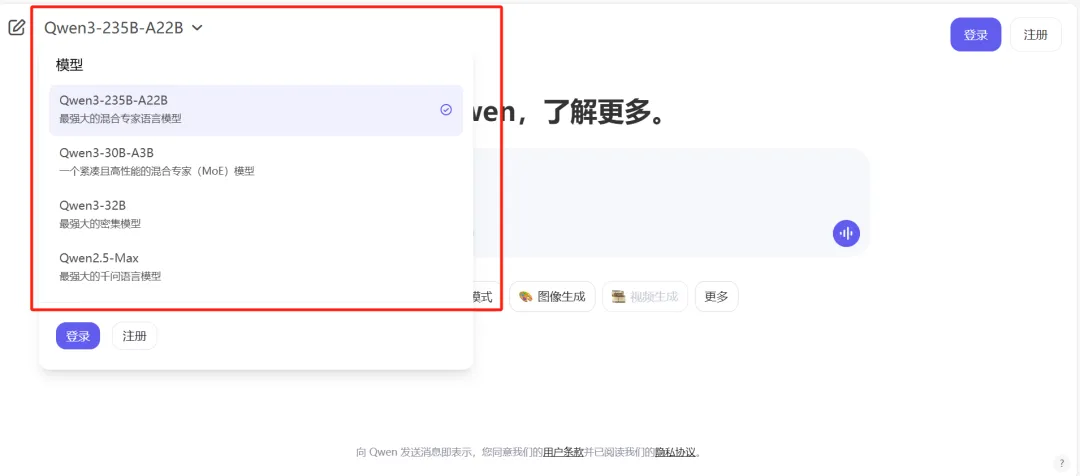

Qwen3当然也是惯例的上线即开源,并且其网页端已经可以体验该系列中最强大的几个模型!

- Hugging Face:

https://huggingface.co/collections/Qwen/qwen3-67dd247413f0e2e4f653967f

- Qwen Chat Web:

https://chat.qwen.ai/

图片

图片

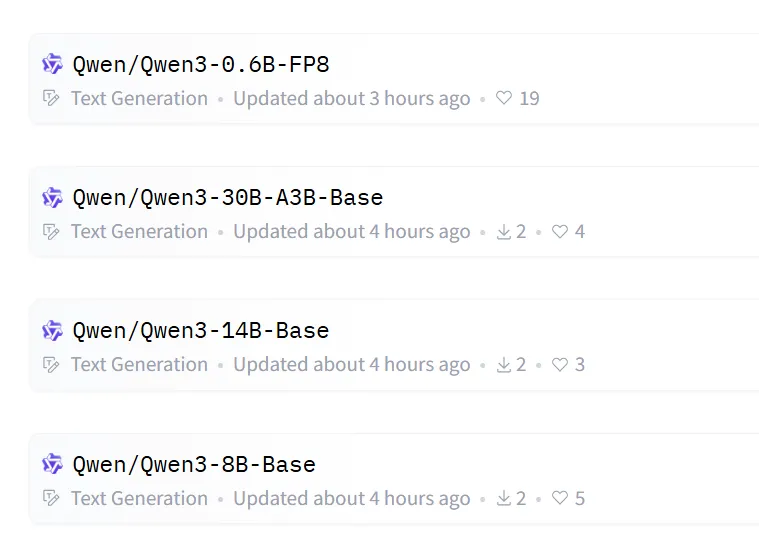

点进 Hugging Face 的 Qwen3 页面你会发现,模型列表比想象中还要长得多!这次源神不仅开源了完整模型,还贴心放出了部分对应的预训练版本!

比如 Qwen3-30B-A3B,它的预训练版 Qwen3-30B-A3B-Base 也一并上线了,现在已经可以在 Hugging Face、ModelScope、Kaggle 等平台上使用。

图片

图片

Qwen3 blog中还贴心给到了部署建议,对于部署,建议使用SGLang和vLLM这样的框架。对于本地使用,强烈建议使用Ollama、LMStudio、MLX、llama.cpp和KTransformers等工具。

昨晚,国内外一大批关注开源的开发者们,熬夜苦等到凌晨,只为了这句话——终于等到了!

图片

图片

Qwen3特性亮点:混合推理模型、双模式按需切换、MCP支持全面升级!

以下是官方总结的Qwen3的最强亮点。

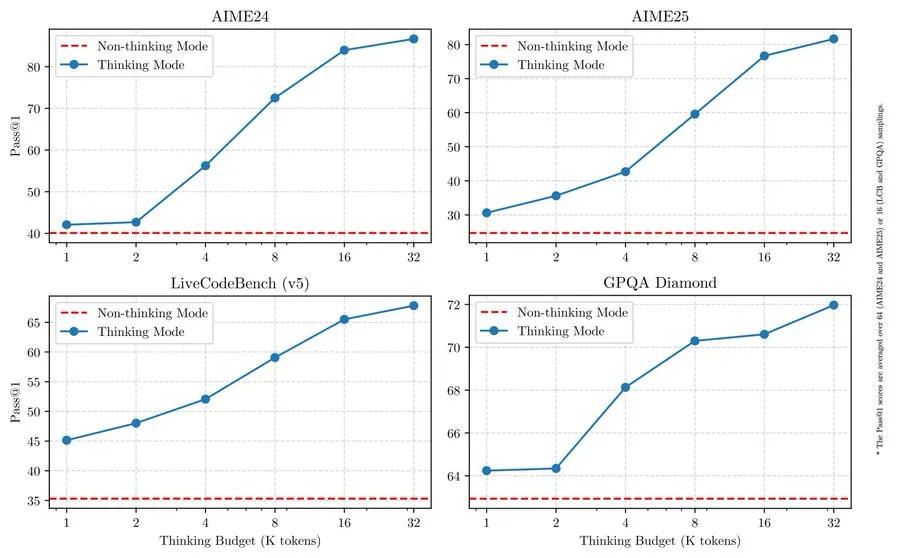

1.混合思维模式

Qwen3 系列模型引入了混合式问题解决方法,支持两种推理模式:

- 思考模式:模型会一步步推理后再给出最终答案,适合需要深入思考的复杂问题。

- 非思考模式:模型快速、几乎即时地响应,适合对速度要求更高、无需复杂推理的简单问题。

这种灵活的设计,让用户可以根据任务需求,自由控制模型的“思考量”。比如,遇到难题时启用更充分的推理流程,而在处理简单问题时则可以直接快速作答。

当然,这样就实现了更好更便宜——双模式集成显著提升了模型在推理预算管理上的稳定性与效率。用户可以根据实际需求,轻松调整推理预算,在成本和推理质量之间拿捏得更精准。

图片

图片

2.多语言支持

Qwen3 一口气支持了119种语言和方言,这一规模,足以让全球用户在刚上线的 Qwen APP 中畅通无阻地体验新一代大模型。真正实现了“让世界各地的人都能用上”的愿景!

原blog中列出了全语言的清单,其中不乏闻所未闻的冷门印欧系语言,如迈蒂利语、博杰普尔语、信德语等;在汉藏语系中则支持中文(简体中文、繁体中文、粤语)和缅甸语。

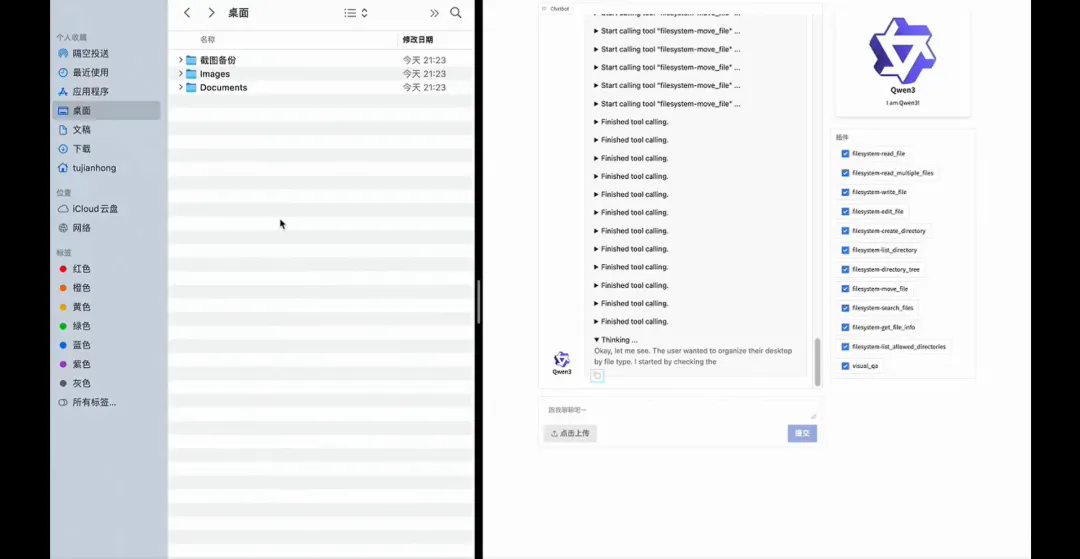

3.智能体能力提升

Qwen3 模型的编码能力和智能体(Agentic)能力进行了优化,并进一步增强了对 MCP(多智能体协作协议)的支持。

在给出的视频demo里,提问者给模型一个Qwen的开源主页,要求提取页面的 Markdown 内容,并绘制一张柱状图展示每个项目的 star 数量。模型出色地完成了思考,并最终通过MCP协议主动把柱状图保存到了本地文件中。

图片

图片

Qwen3是如何练成的:三阶段预训练和四阶段后训揭秘

在预训练方面,Qwen3 的数据集相比 Qwen2.5 有了大幅扩展。Qwen2.5 的预训练量为 18 万亿 tokens,而 Qwen3 直接翻倍,使用了约 36 万亿 tokens,覆盖了 119 种语言和方言。

为了构建这一超大规模数据集,团队人员不仅收集了网页数据,还纳入了大量类似 PDF 的文档数据。

在处理文档数据时,他们使用 Qwen2.5-VL 进行文本抽取,再用 Qwen2.5 提升抽取内容的质量。为了增加数学与代码数据的比例,还利用 Qwen2.5-Math 和 Qwen2.5-Coder 生成了大量合成数据,涵盖教科书内容、问答对和代码片段。

Qwen3 的预训练过程分为三个阶段:

- 第一阶段(S1):在超过 30 万亿 tokens 上进行预训练,采用 4K tokens 的上下文长度,为模型打下了基本的语言能力和通识知识基础。

- 第二阶段(S2):提升数据集的知识密集度,增加了更多 STEM、编码与推理相关的数据,新增预训练了 5 万亿 tokens。

- 第三阶段:引入高质量的长上下文数据,将模型的上下文长度扩展到 32K tokens,确保能够有效处理更长的输入。

图片

图片

得益于模型架构的优化、训练数据量的提升以及训练方法的改进,Qwen3 的稠密基础模型在整体性能上达到了参数量更大的 Qwen2.5 基础模型的水平。例如,Qwen3-1.7B/4B/8B/14B/32B-Base 分别对标 Qwen2.5-3B/7B/14B/32B/72B-Base。

特别是在 STEM、编码和推理领域,Qwen3 的稠密模型甚至可以超越更大规模的 Qwen2.5 模型。

至于 Qwen3 的 MoE 基础模型,它们在只使用约 10% 激活参数量的情况下,实现了与 Qwen2.5 稠密基础模型相当的性能,大幅降低了训练和推理成本。

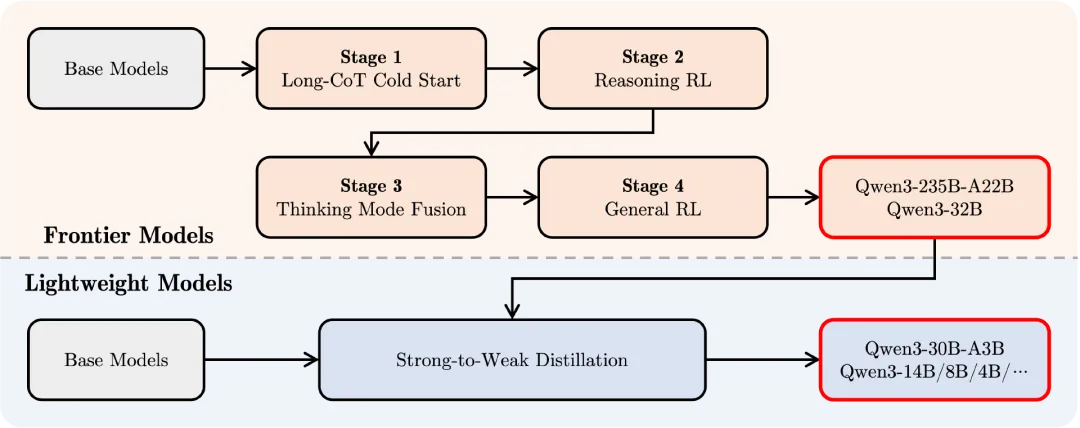

在后训练方面,为了打造兼具逐步推理能力和快速响应能力的混合模型,Qwen3 采用了四阶段训练流程,包括:

- 长链式思考(CoT)冷启动

- 基于推理的强化学习(RL)

- 思考模式与非思考模式融合

- 通用领域强化学习

图片

图片

在第一阶段,使用覆盖数学、编码、逻辑推理和 STEM 问题等多领域、多任务的长链式推理数据,对模型进行微调,奠定了基础推理能力。

第二阶段,放大了推理阶段的计算资源投入,结合基于规则的奖励信号,提升了模型的探索与利用能力。

第三阶段,将非思考模式融入到已有思考模式中,使用长链推理数据与常规指令微调数据的混合数据进行微调,这部分数据是由第二阶段强化后的思考模型生成的,确保了推理与快答能力的自然融合。

最后,在第四阶段,针对 20 多个通用领域任务进一步进行强化学习,包括指令遵循、格式遵循、智能体能力等,全面提升模型的通用能力并修正不良行为。

写在最后:从“训练模型”的时代,加速过渡到“训练智能体”的新时代

在整个blog的最后,Qwen表示还将持续进化,向着“扩大数据规模、增加模型参数量、延长上下文长度、拓展多模态能力”的方向进发,同时通过环境反馈推动强化学习,支持更长链条的推理能力。

从模型到智能体的跨越,正在加速到来。未来,基础模型的每一次进化,都不仅是参数的跃迁,更是智能边界的扩张。新的征程已经启航,让我们一起见证!