三维空间占有率(3D Occupancy)预测的目的是预测三维空间中的每个体素是否被占有,如果被占有,则对应的体素将被标记。3D Semantic Occupancy是在三维空间内同时编码占用状态和语义信息,成为描述自动驾驶 3D 场景的一种极具吸引力的表示方式。而自动驾驶世界模型(World Model)具备对真实物理世界的理解能力,基于一些历史信息/状态,能够预测未来时刻的场景变化甚至agents的状态变化。因此将OCC和世界模型结合,除了可以实现当前时刻的OCC预测,还可以预测未来时刻的OCC演变,可以直接影响到自动驾驶的规划/决策,也是这两年自动驾驶研究的一个重点方向,预计2025年会有更多的工作问世,今天自动驾驶之心就和大家一起复盘2024年OCC和世界模型相关的工作,并在文末总结未来的趋势~

Scene as Occupancy

- paper: https://arxiv.org/abs/2306.02851

- code:https://github.com/OpenDriveLab/OccNet

虽然OccNet不属于世界模型+OCC的范畴,但是有必要简单介绍一个这个工作,有助于理解后续介绍的方法。

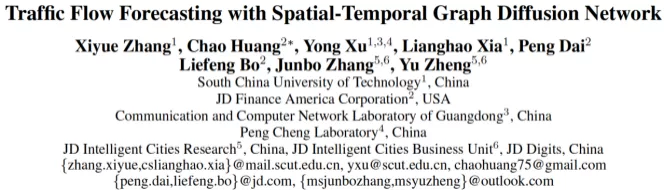

人类驾驶员能够通过视觉系统轻松描述复杂的交通场景。这种精确感知的能力对于驾驶员的规划至关重要。为了实现这一点,一种将物理三维场景量化为具有每个单元语义标签的结构化网格地图的几何感知表示形式,即三维占用表示,将是理想的。与边界框的形式相比,占用表示的关键见解在于它能够捕捉场景中关键障碍物的细粒度细节,从而促进后续任务。先前或同时期的文献主要集中在单个场景补全任务上,我们可能会认为这种占用表示形式的潜力可能会产生更广泛的影响。在本文中,我们提出了 OccNet,这是一种以多视图为中心的管道,具有级联和时间体素解码器来重建三维占用。OccNet 的核心是一个通用的占用嵌入来表示三维物理世界。这种描述符可以应用于广泛的驾驶任务,包括检测、分割和规划。为了验证这种新表示形式的有效性和我们提出的算法,针对该算法,我们提出了 OpenOcc,这是首个基于 nuScenes 构建的高密度高质量 3D 占有率基准。实证实验表明,在多个任务中均有显著的性能提升,例如,运动规划的碰撞率可降低 15% - 58%,这证明了我们方法的优越性。

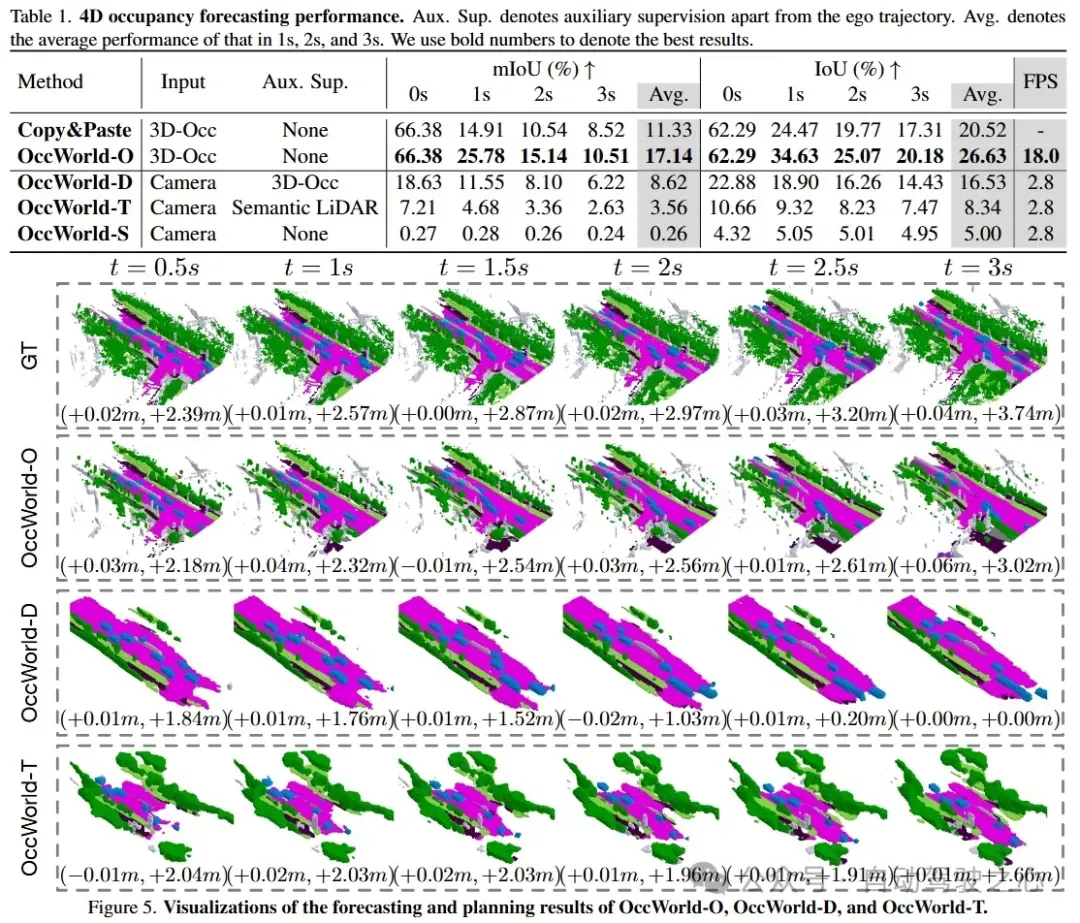

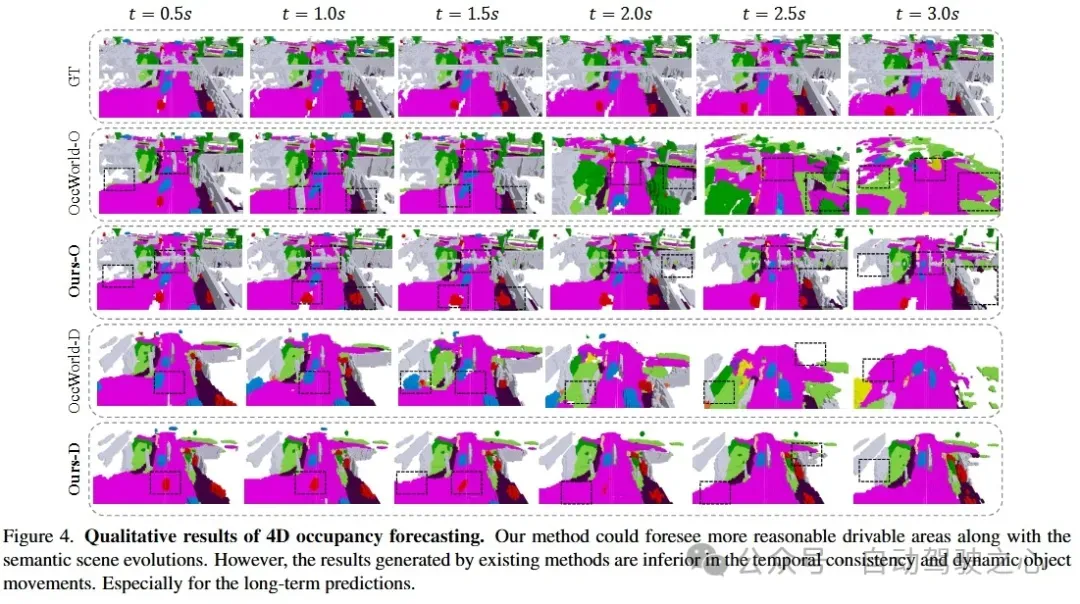

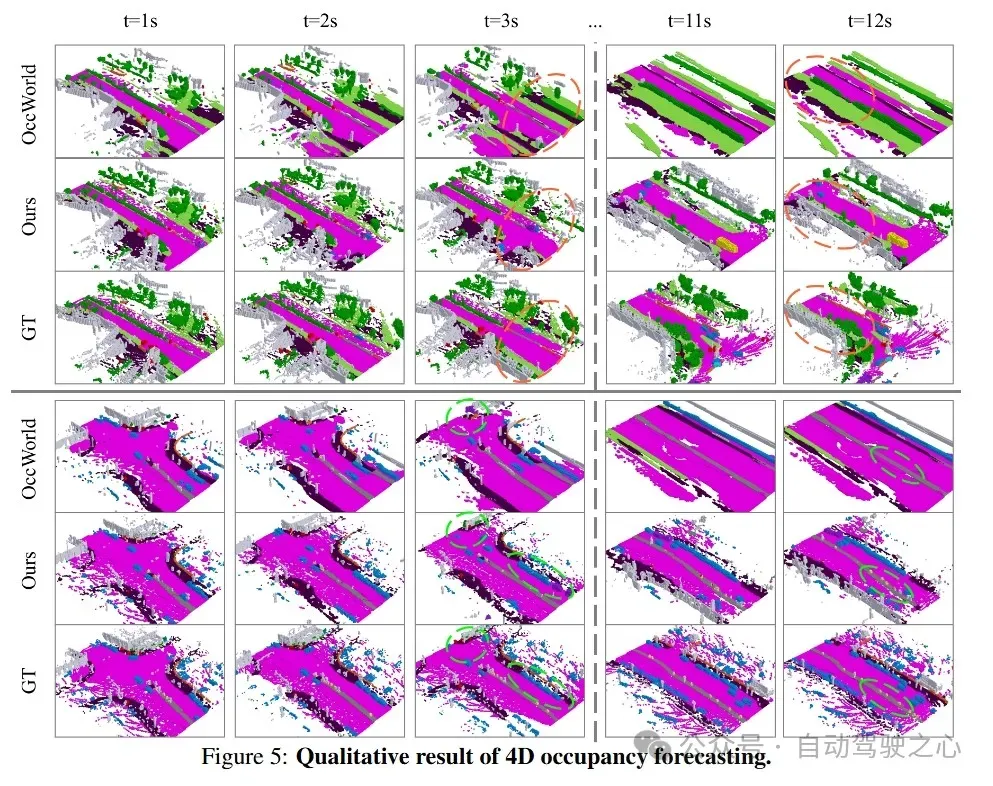

OccWorld: Learning a 3D Occupancy World Model for Autonomous Driving

- paper: https://arxiv.org/pdf/2311.16038

- code: https://github.com/wzzheng/OccWorld

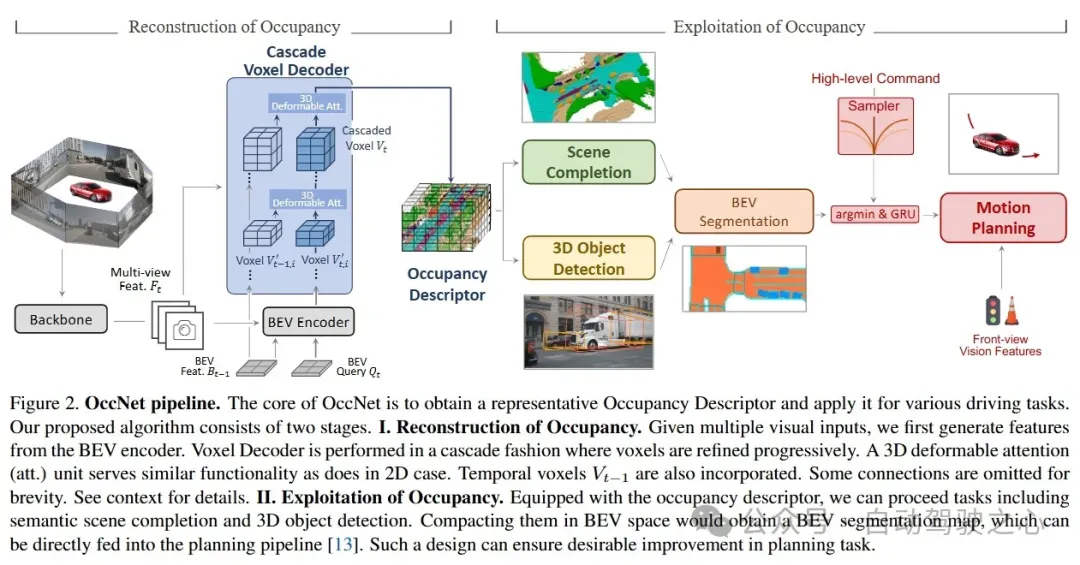

理解三维场景如何演变对于自动驾驶中的决策至关重要。大多数现有的方法通过预测物体检测框的运动来实现这一点,但无法捕捉到更精细的场景信息。在本文中,我们探索了一种新的框架,即在三维占用空间中学习世界模型,名为OccWorld,以同时预测自动驾驶汽车的运动和周围场景的演变。我们提出基于三维占用而非三维边界框和分割图来学习世界模型,原因有三:1)表达能力:三维占用能够描述场景更精细的三维结构;2)效率:三维占用率更易于获取(例如,从稀疏的激光雷达点中获取)。3)通用性:三维占用率能够适应视觉和激光雷达。为了便于对世界演变进行建模,我们在三维占用率上学习了一种基于重建的场景tokenizer,以获取离散的场景tokens来描述周围场景。然后,我们采用类似 GPT 的时空生成转换器来生成后续场景和ego tokens,以解码未来的占用率和自车轨迹。在广泛使用的 nuScenes 基准上进行的大量实验表明,OccWorld 能够有效地对驾驶场景的演变进行建模。OccWorld 还在不使用实例和地图监督的情况下产生了具有竞争力的规划结果。

OccWorld是两阶段模型:

- VQ-VAE 的训练极大地阻碍了效率,并为第二阶段引入了性能瓶颈。为场景tokenizer找到合适的超参数在平衡重建和预测性能方面仍然具有挑战性

- 完全依赖于自回归方式的隐式特征。它要么忽略了相邻场景中显式的结构一致性,要么忽略了图像中容易获取的纹理信息。这些都阻碍了模型充分捕捉环境动态的能力

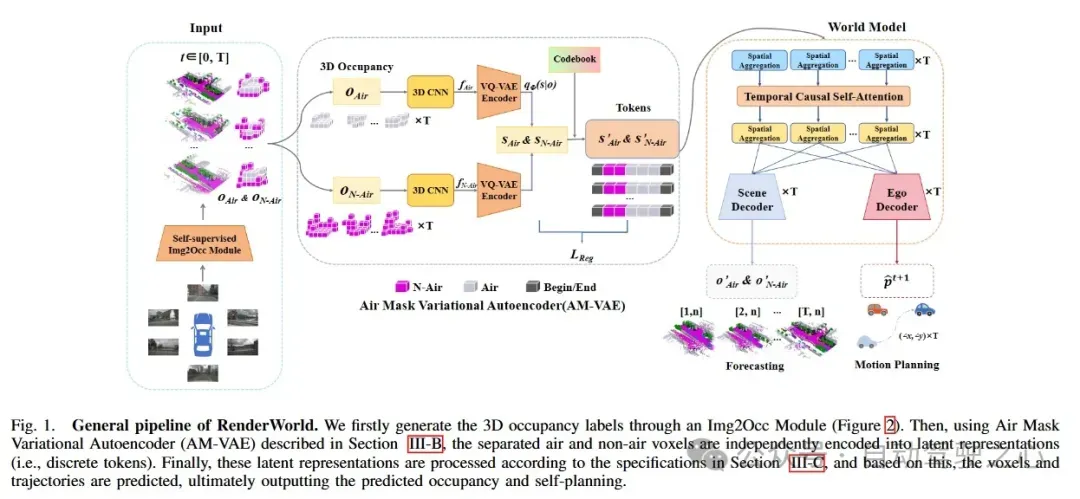

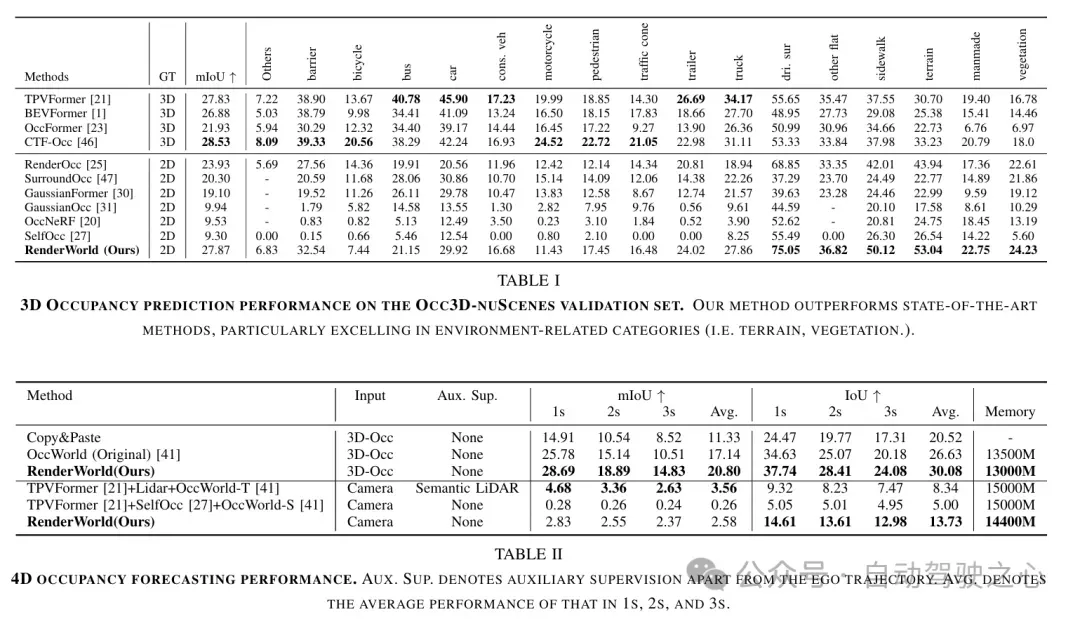

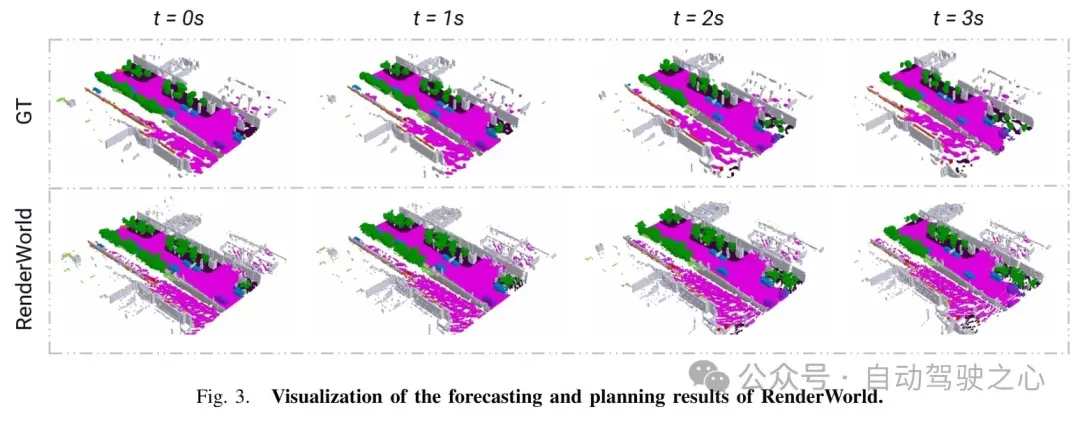

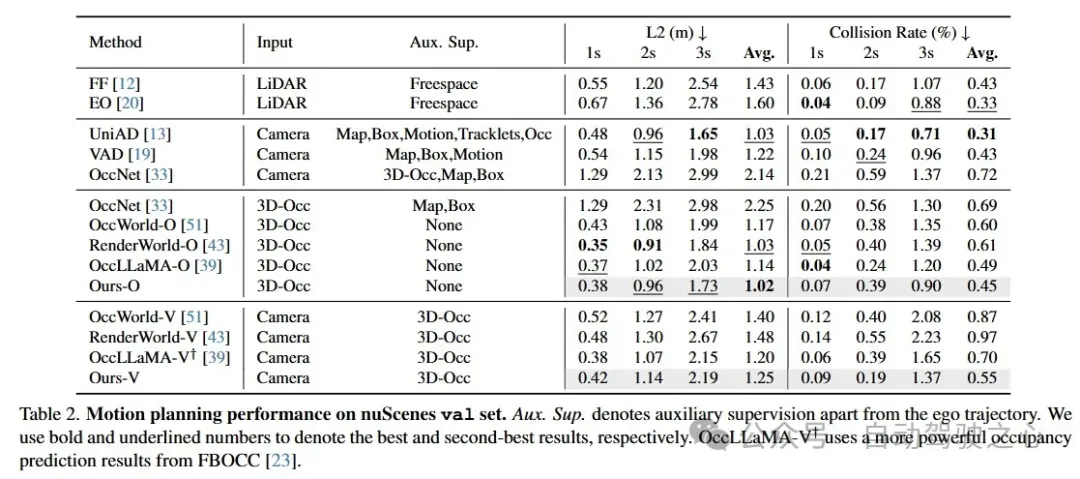

RenderWorld: World Model with Self-Supervised 3D Label

- paper: https://arxiv.org/abs/2409.11356

仅基于视觉的端到端自动驾驶不仅比激光雷达与视觉融合的方法更具成本效益,而且比传统方法更可靠。为了实现经济且鲁棒的纯视觉自动驾驶系统,我们提出了 RenderWorld,这是一种仅基于视觉的端到端自动驾驶框架,它使用基于自监督高斯的 Img2Occ 模块生成 3D 占有率标签,然后通过 AM-VAE 对标签进行编码,并使用世界模型进行预测和规划。RenderWorld 采用高斯点阵来表示 3D 场景并渲染 2D 图像,与基于 NeRF 的方法相比,这极大地提高了分割精度并减少了 GPU 内存消耗。通过应用 AM-VAE 分别对air和non-air进行编码,RenderWorld 实现了更精细的场景元素表示,在自回归世界模型的 4D 占有率预测和运动规划方面均达到了最先进的性能。

两阶段训练范式。

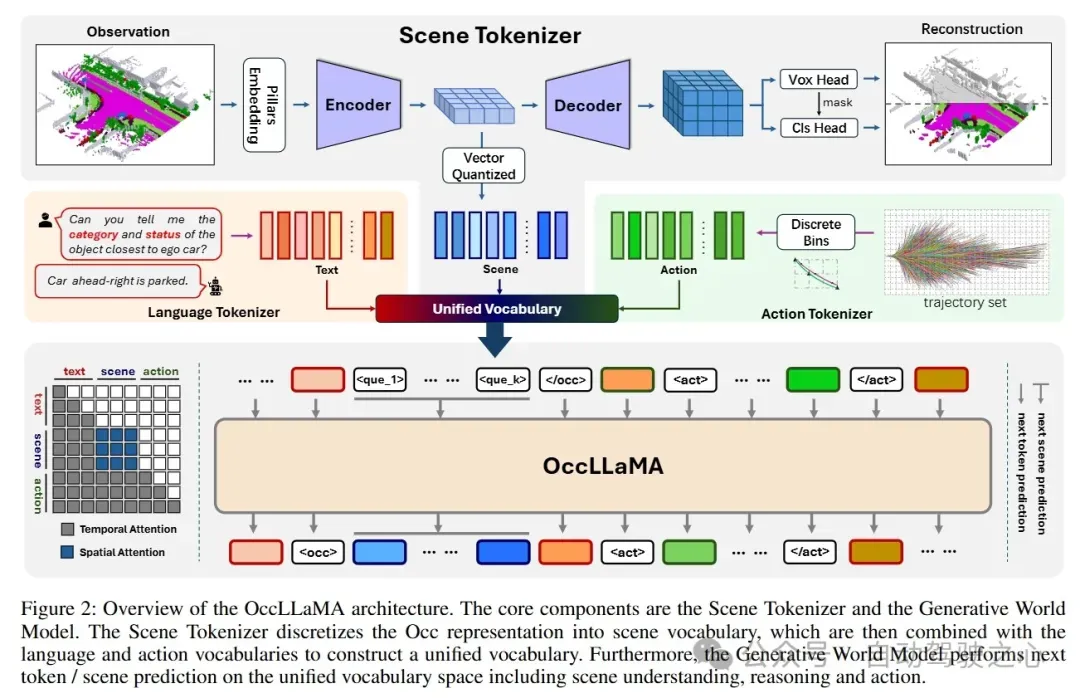

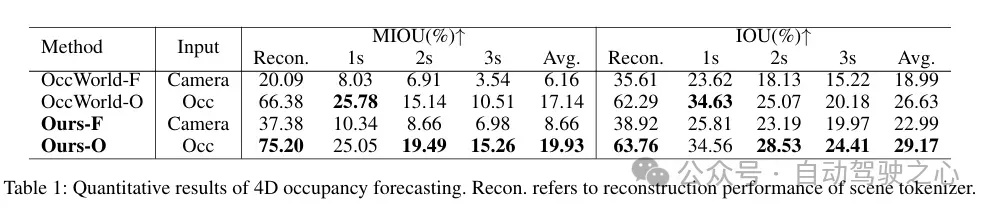

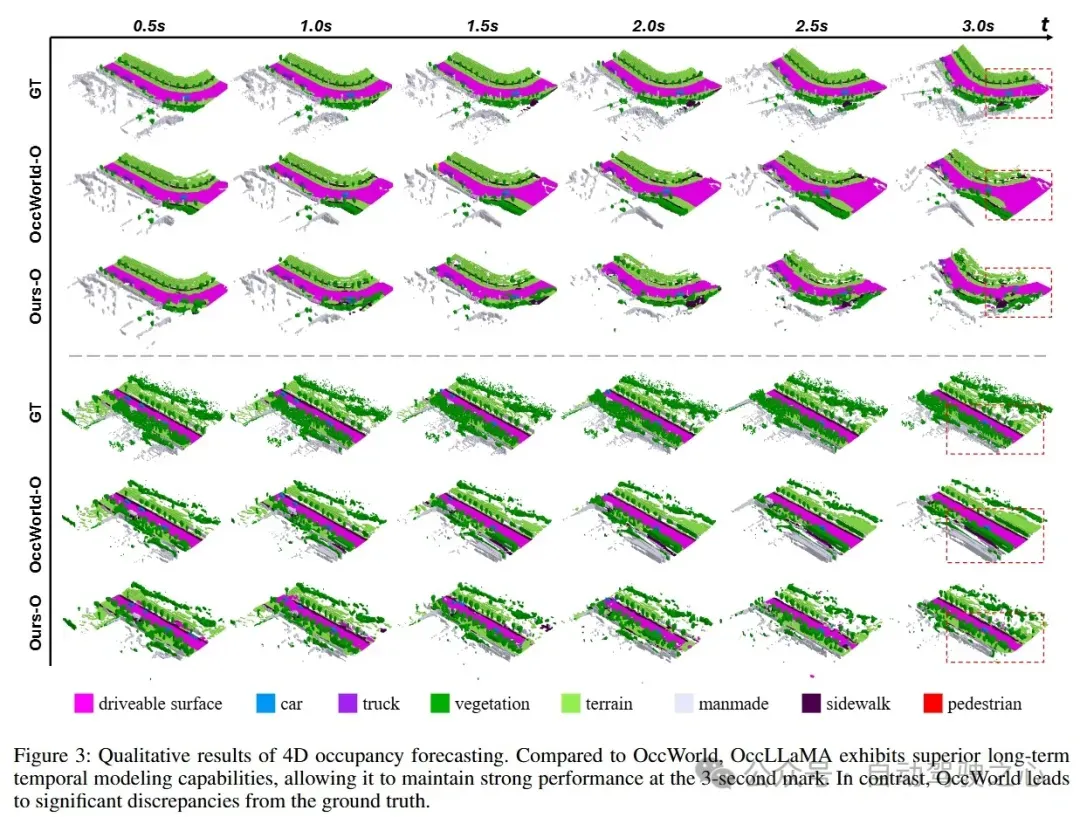

OccLLaMA: An Occupancy-Language-Action Generative World Model for Autonomous Driving

- paper: https://arxiv.org/abs/2409.03272

多模态大型语言模型(MLLMs)的兴起推动了其在自动驾驶中的应用。近期基于 MLLM 的方法通过学习从感知到动作的直接映射来执行动作,忽略了世界的动态以及行为与世界动态之间的关系。相比之下,人类拥有世界模型,能够基于三维内部视觉表征模拟未来状态,并据此规划行为。为此,我们提出了 OccLLaMA,这是一种占用-语言-动作生成式世界模型,它采用语义占用作为通用视觉表示,并通过自回归模型统一了视觉-语言-动作(VLA)模态。具体而言,我们引入了一种类似 VQVAE 的场景tokenizer,以高效地离散化和重建语义占用场景,同时考虑到其稀疏性和类别不平衡的问题。然后,我们为视觉、语言和动作构建了一个统一的多模态词汇表。此外,我们增强了大型语言模型(LLM),特别是 LLaMA,使其能够在统一的词汇表上进行下一token/场景预测,以完成自动驾驶中的多项任务。大量实验表明,OccLLaMA 在包括 4D 占用预测、运动规划和视觉问答在内的多项任务中均取得了具有竞争力的性能,展示了其作为自动驾驶基础模型的潜力。

两阶段训练范式。

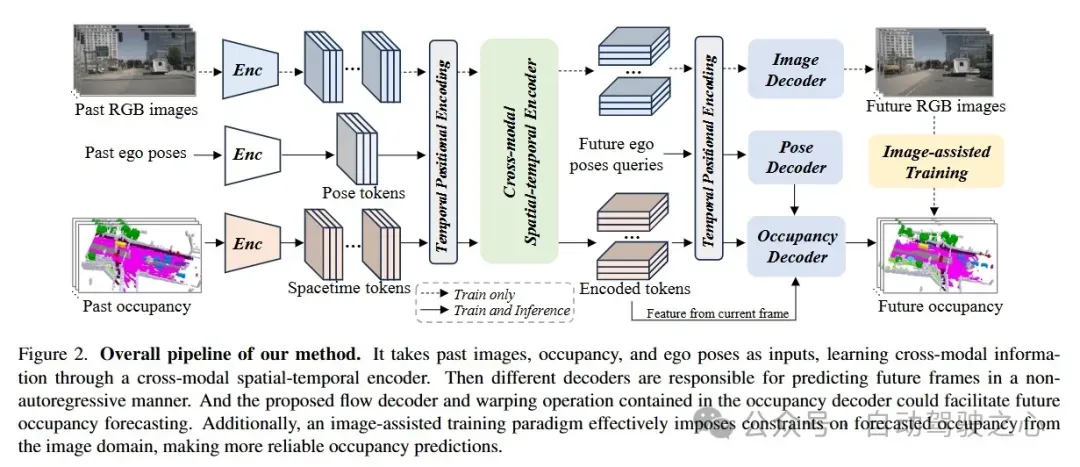

An Efficient Occupancy World Model via Decoupled Dynamic Flow and Image-assisted Training

- paper: https://arxiv.org/abs/2412.13772

自动驾驶领域对世界模型的兴趣日益浓厚,这类模型旨在基于历史观测预测潜在的未来场景。在本文中,我们介绍了 DFIT-OccWorld,这是一种高效的 3D 占有世界模型,它利用了解耦动态流和图像辅助训练策略,显著提升了 4D 场景预测性能。为了简化训练过程,我们摒弃了之前的两阶段训练策略,并创新性地将占有预测问题重新表述为解耦的体素变形过程。我们的模型通过使用体素流对现有观测进行变形来预测未来的动态体素,而静态体素则通过姿态变换轻松获得。此外,我们的方法还引入了图像辅助训练范式以增强预测的可靠性。具体而言,采用可微体积渲染通过预测的未来体积生成渲染深度图,并将其用于基于渲染的光度一致性。实验表明了我们方法的有效性,在 nuScenes 和 OpenScene 基准测试中展示了其在 4D 占有预测方面的先进性能。该模型实现了精准预测、端到端运动规划和点云预测。具体而言,与现有的 3D 世界模型相比,它达到了最先进的性能,同时计算成本大幅降低。

效率和性能都比之前的两阶段模型好。

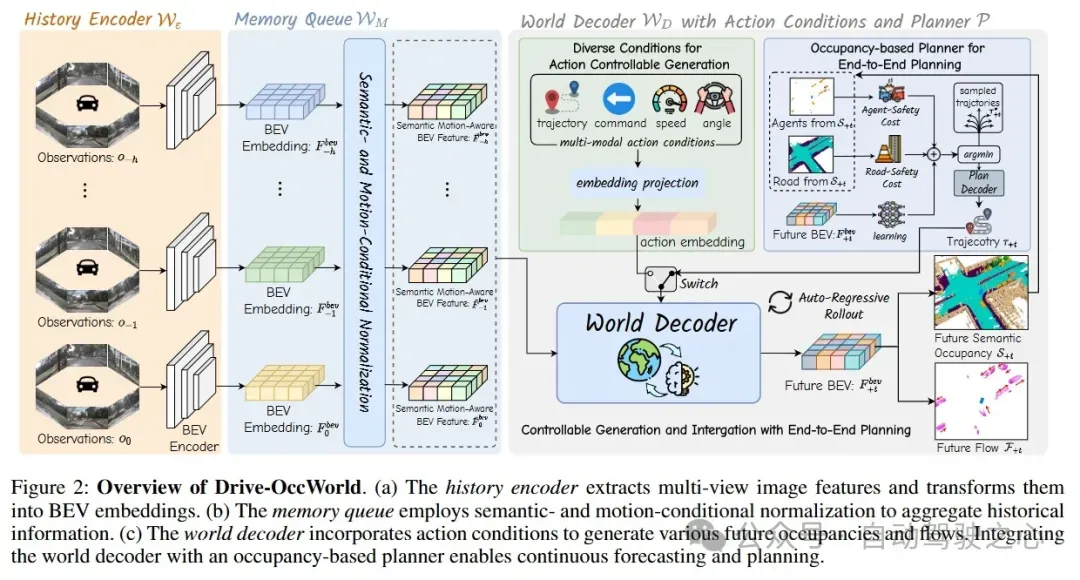

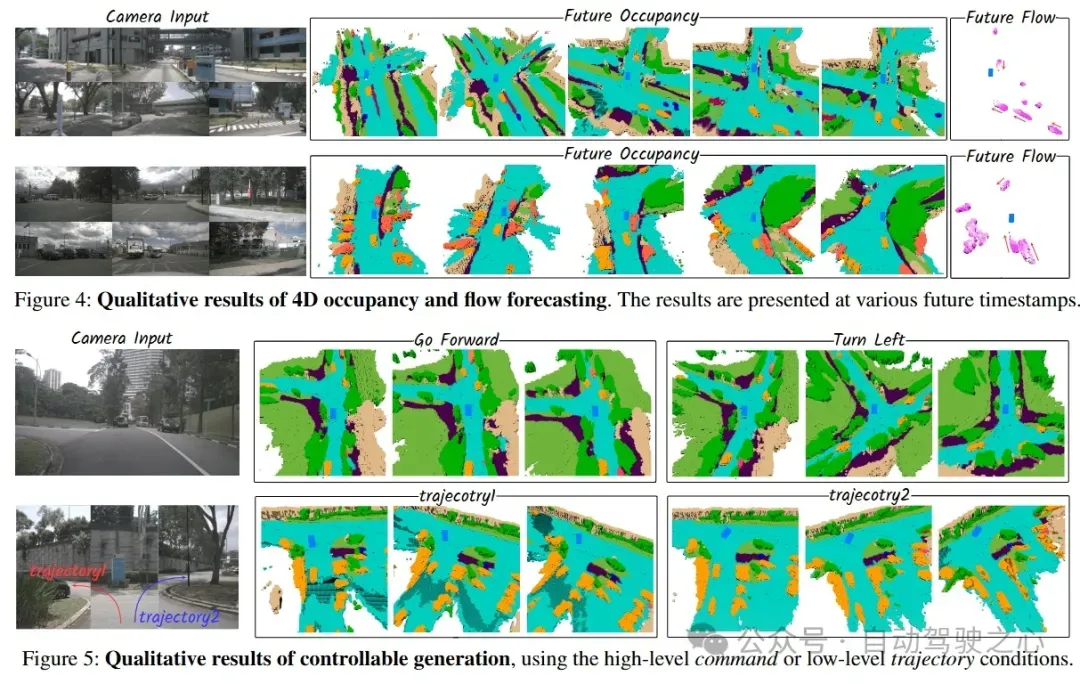

Driving in the Occupancy World: Vision-Centric 4D Occupancy Forecasting and Planning via World Models for Autonomous Driving

- paper:https://arxiv.org/abs/2408.14197

- project page: https://drive-occworld.github.io/

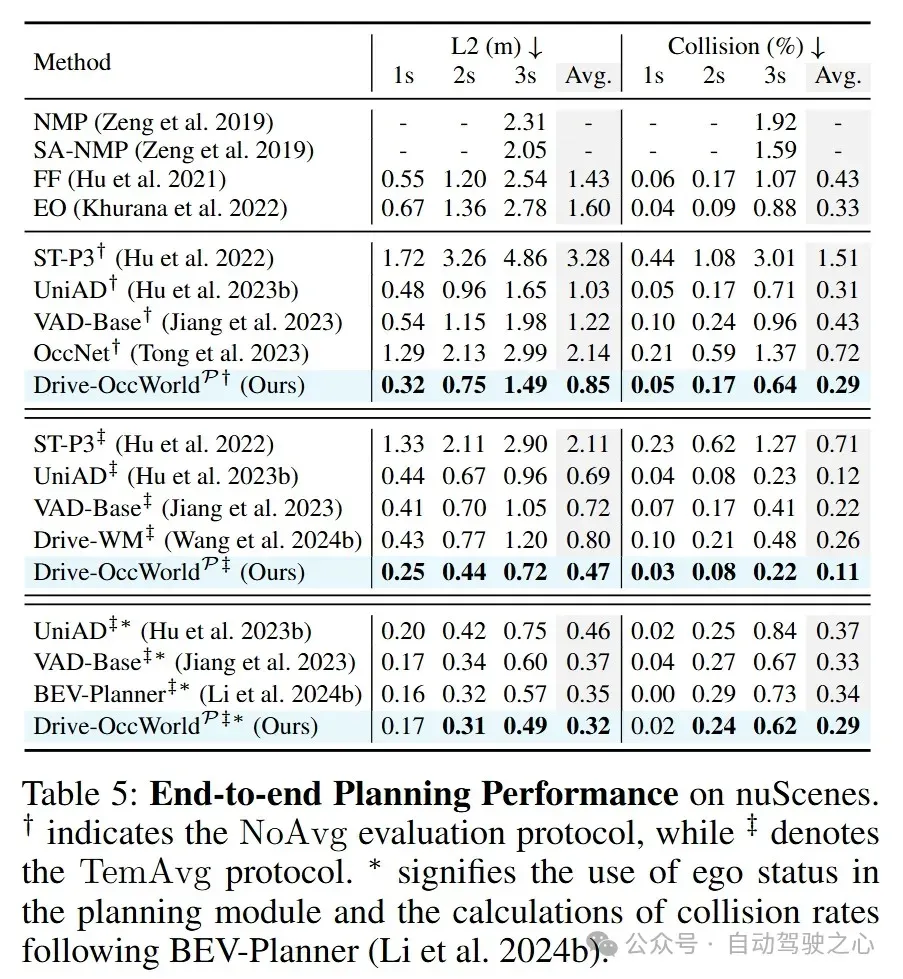

世界模型基于各种ego行为设想潜在的未来状态。它们嵌入了关于驾驶环境的大量知识,有助于实现安全且可扩展的自动驾驶。大多数现有的方法主要侧重于数据生成或世界模型的预训练范式。与上述先前的工作不同,我们提出了 Drive-OccWorld,它将以视觉为中心的 4D 预测世界模型适应于自动驾驶的端到端规划。具体而言,我们首先在内存模块中引入语义和运动条件归一化,该模块从历史 BEV 嵌入中积累语义和动态信息。然后,这些 BEV 特征被传递到世界解码器,用于未来占用和流预测,同时考虑几何和时空建模。此外,我们提出将灵活的动作条件(如速度、转向角、轨迹和指令)注入世界模型,以实现可控生成,并促进更广泛的下游应用。此外,我们还探索了将 4D 世界模型的生成能力与端到端规划相结合,从而能够利用基于占用率的成本函数连续预测未来状态并选择最优轨迹。在 nuScenes 数据集上进行的大量实验表明,我们的方法能够生成合理且可控的 4D 占用率,为驾驶世界生成和端到端规划开辟了新的途径。

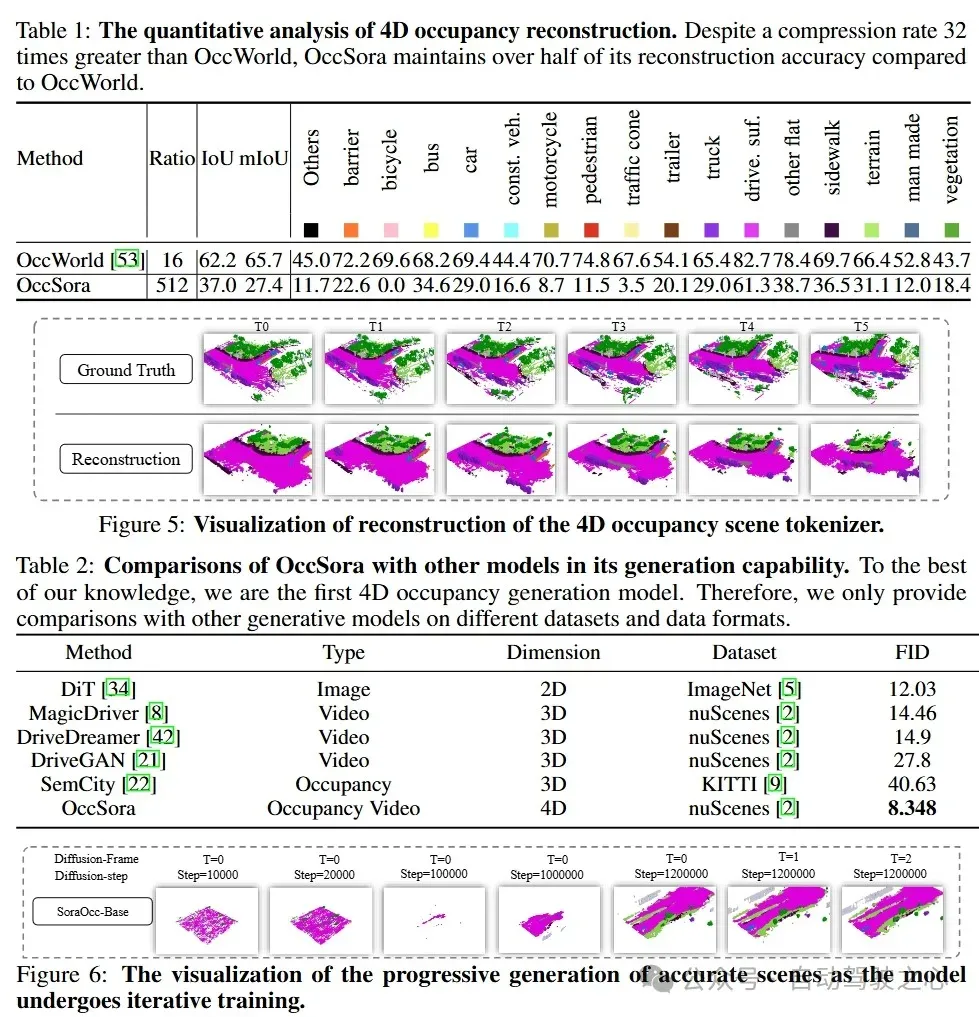

OccSora: 4D Occupancy Generation Models as World Simulators for Autonomous Driving

- paper: https://arxiv.org/abs/2405.20337

- code: https://github.com/wzzheng/OccSora

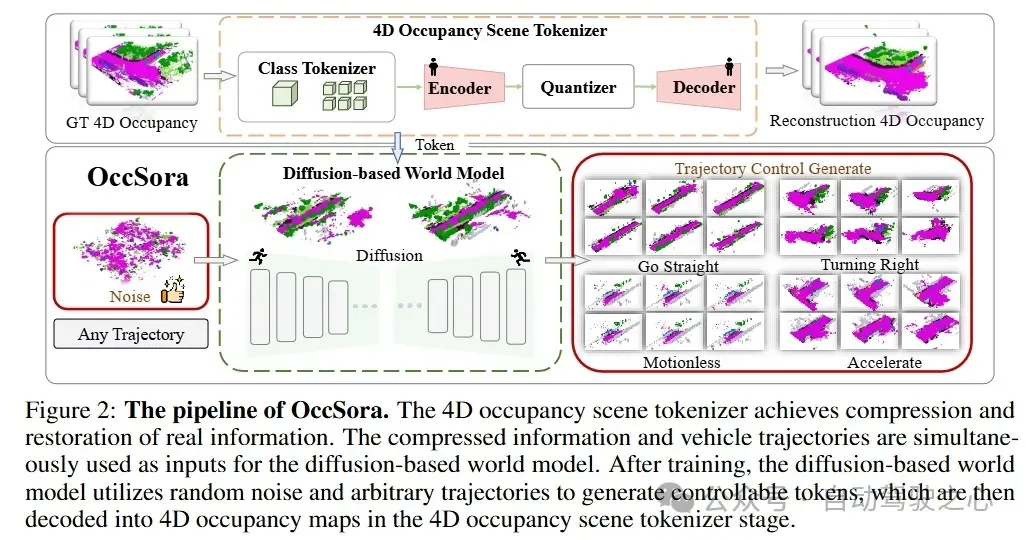

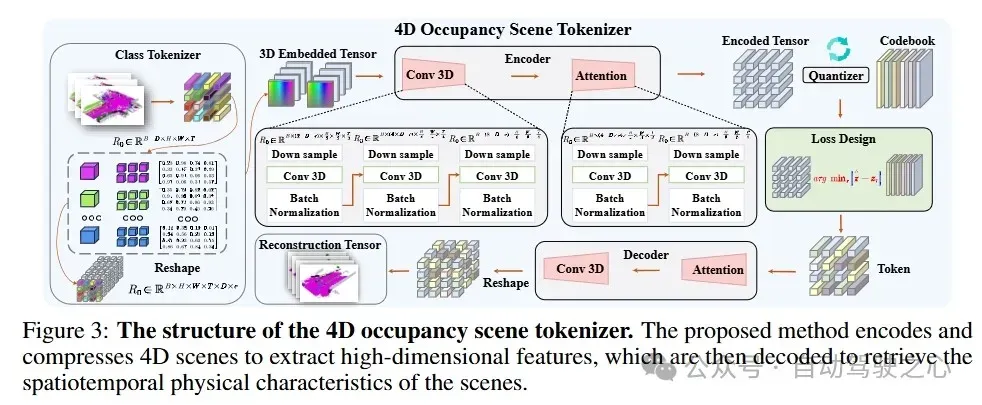

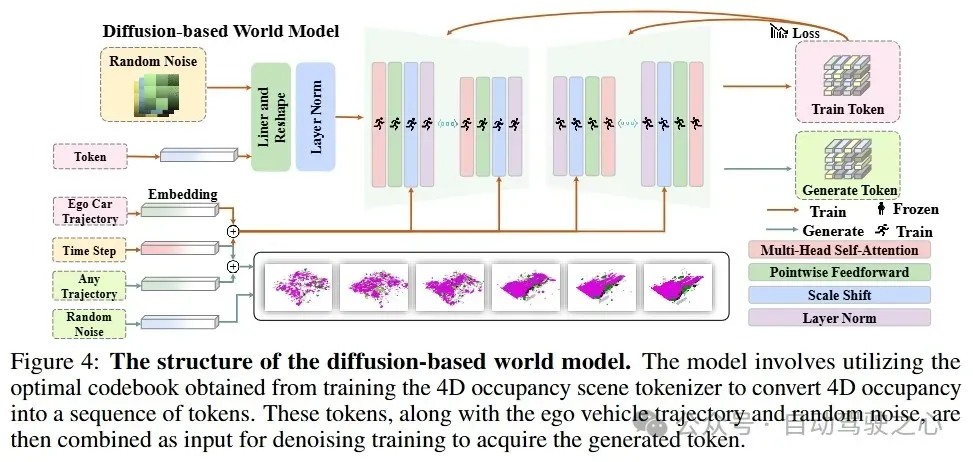

理解 3D 场景的演变对于实现有效的自动驾驶至关重要。虽然传统方法通过单个实例的运动来建模场景的发展,但世界模型作为一种生成框架,能够描述一般的场景动态。然而,大多数现有的方法采用自回归框架来进行下一个token预测,这在对长期时间演变进行建模时效率低下。为了解决这个问题,我们提出了一种基于扩散的 4D 占有率生成模型 OccSora,用于模拟自动驾驶中的 3D 世界的发展。我们采用 4D 场景tokenizer来获取 4D 占有率输入的紧凑离散时空表示,并实现对长序列占有率视频的高质量重建。然后,我们在时空表示上学习扩散Transformer,并根据轨迹提示生成 4D 占有率。我们在广泛使用的 nuScenes 数据集上进行了大量实验,该数据集带有 Occ3D 占有率注释。OccSora 能够生成具有真实 3D 布局和时间一致性的 16 秒视频,这表明它能够理解驾驶场景的空间和时间分布。凭借轨迹感知的 4D 生成能力,OccSora 有可能成为自动驾驶决策的世界模拟器。

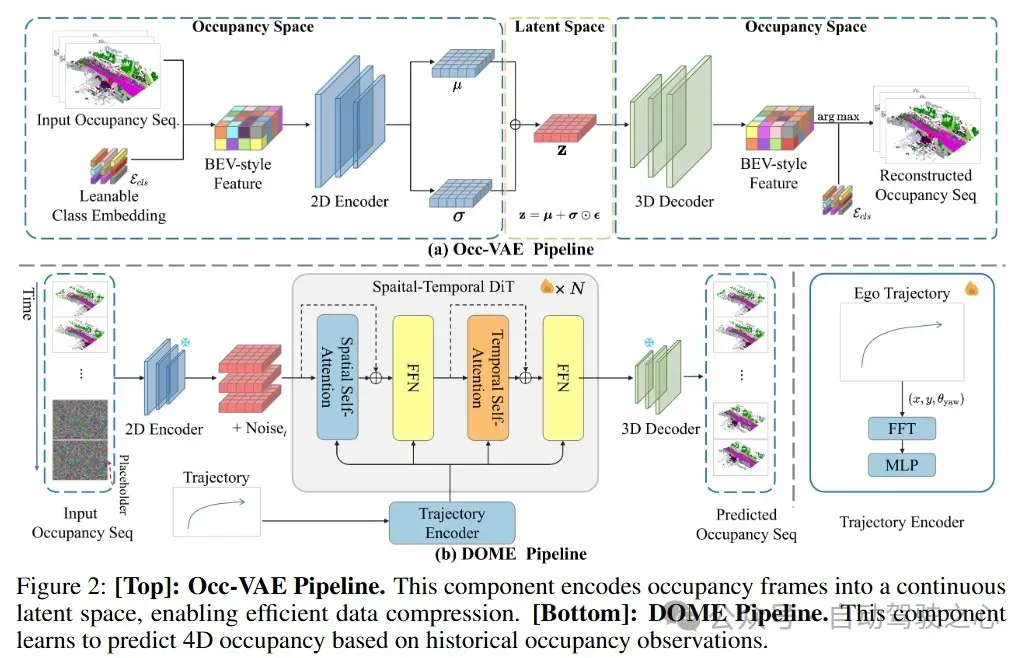

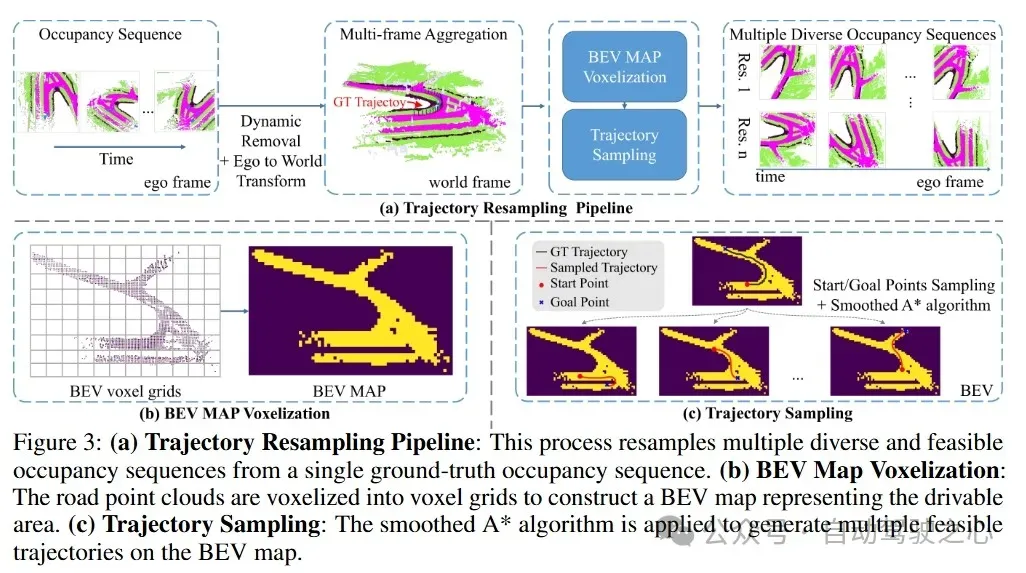

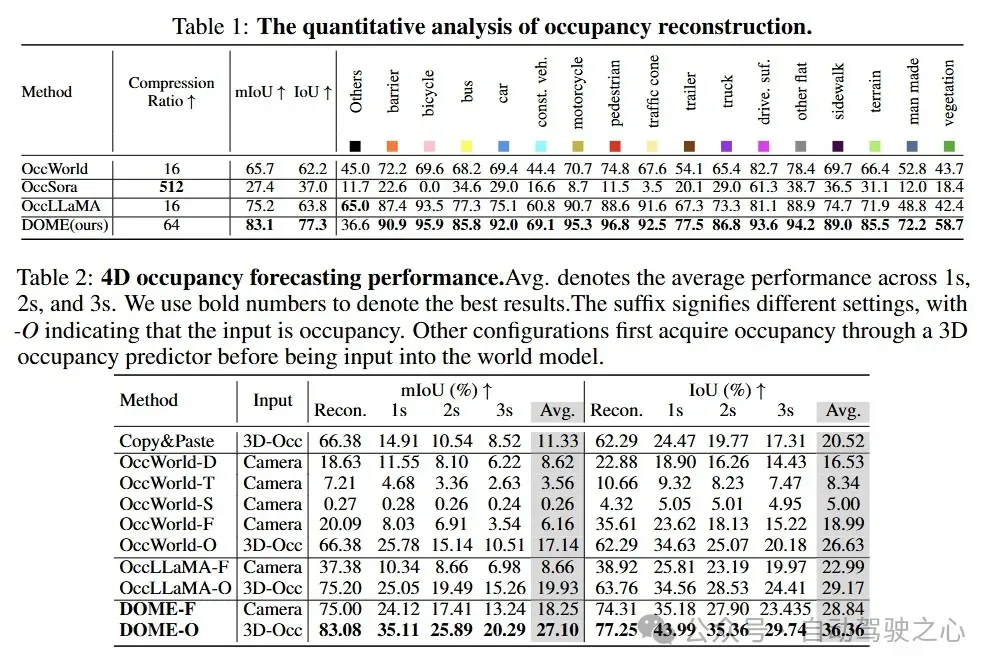

DOME: Taming Diffusion Model into High-Fidelity Controllable Occupancy World Model

- paper: https://arxiv.org/abs/2410.10429

- project page: https://gusongen.github.io/DOME

我们提出了一种基于扩散的世界模型 DOME,它能够根据过去的占用情况预测未来的占用帧。这种世界模型捕捉环境演变的能力对于自动驾驶中的规划至关重要。与基于 2D 视频的世界模型相比,占用世界模型利用了原生的 3D 表示,具有易于获取的标注且不受模态限制。这种灵活性有可能促进更先进世界模型的发展。现有的占用世界模型要么因离散tokens而损失细节,要么依赖于简单的扩散架构,导致预测未来占用情况时效率低下且难以实现可控性。我们的 DOME 具有两个关键特性:(1)高保真度和长时生成。我们采用时空扩散Transformer,基于历史上下文预测未来的占用帧。这种架构能够高效地捕捉时空信息,从而实现高保真度的细节,并具备长时间生成预测的能力。(2)细粒度可控性。我们通过引入一种轨迹重采样方法来应对预测中的可控性挑战,这显著增强了模型生成可控预测的能力。在广泛使用的 nuScenes 数据集上进行的大量实验表明,我们的方法在定性和定量评估中均超越了现有的基准,在 nuScenes 上建立了新的最先进性能。具体而言,在占用重建方面,我们的方法在 mIoU 上比基准高出 10.5%,在 IoU 上高出 21.2%;在 4D 占用预测方面,在 mIoU 上高出 36.0%,在 IoU 上高出 24.6%。

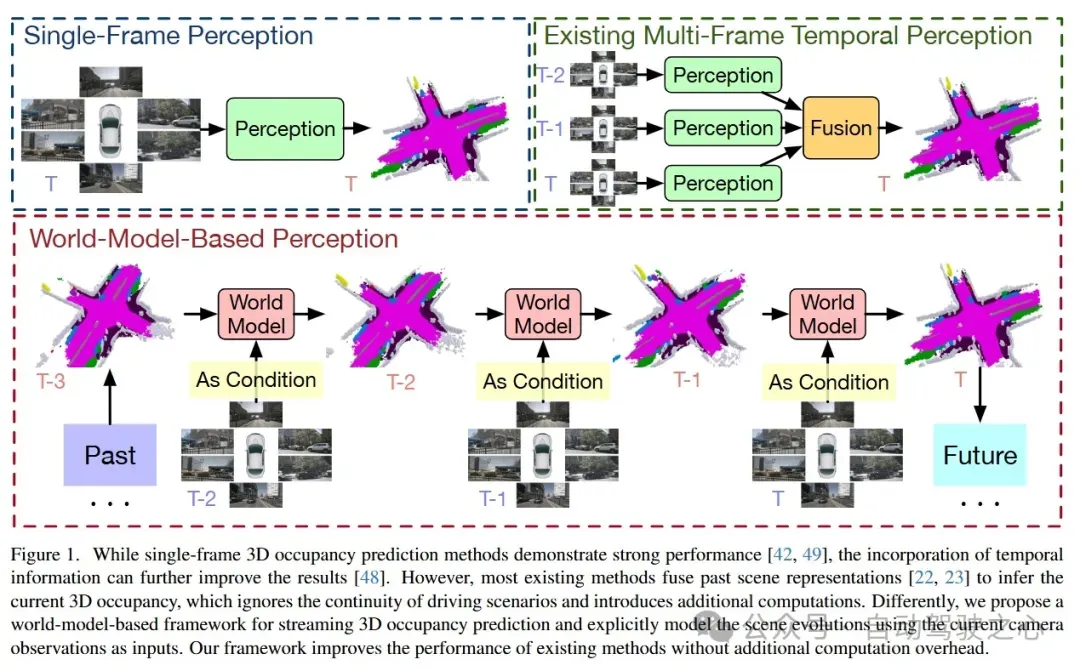

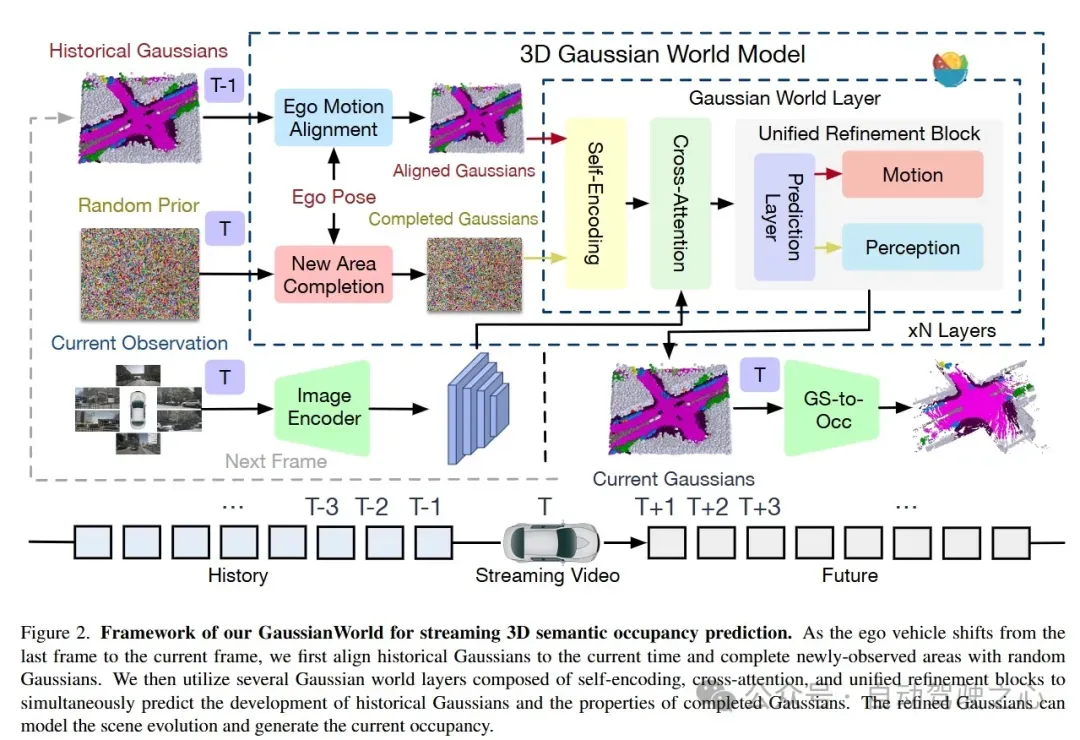

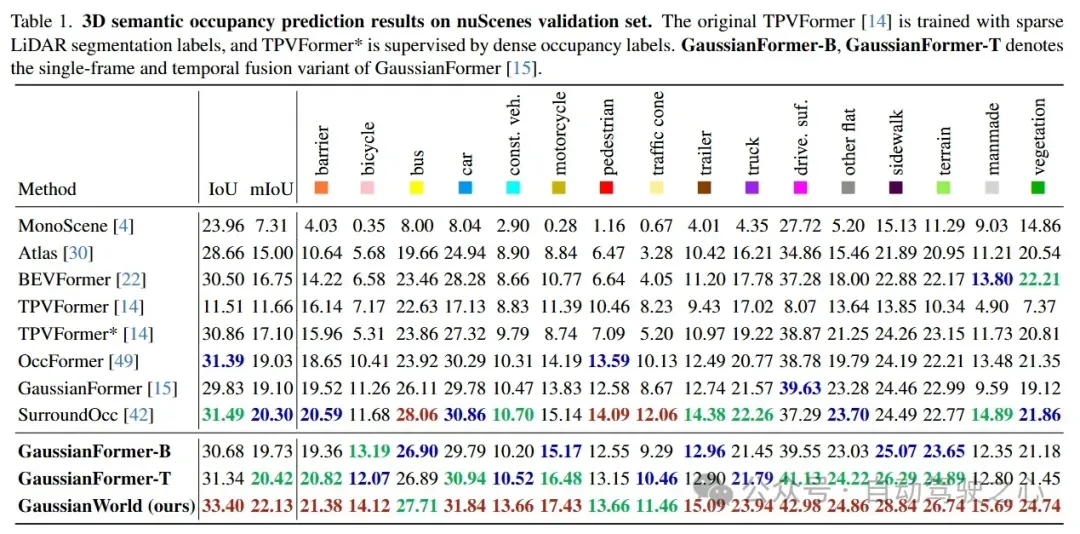

GaussianWorld: Gaussian World Model for Streaming 3D Occupancy Prediction

- paper: https://arxiv.org/abs/2412.10373

- code: https://github.com/zuosc19/GaussianWorld

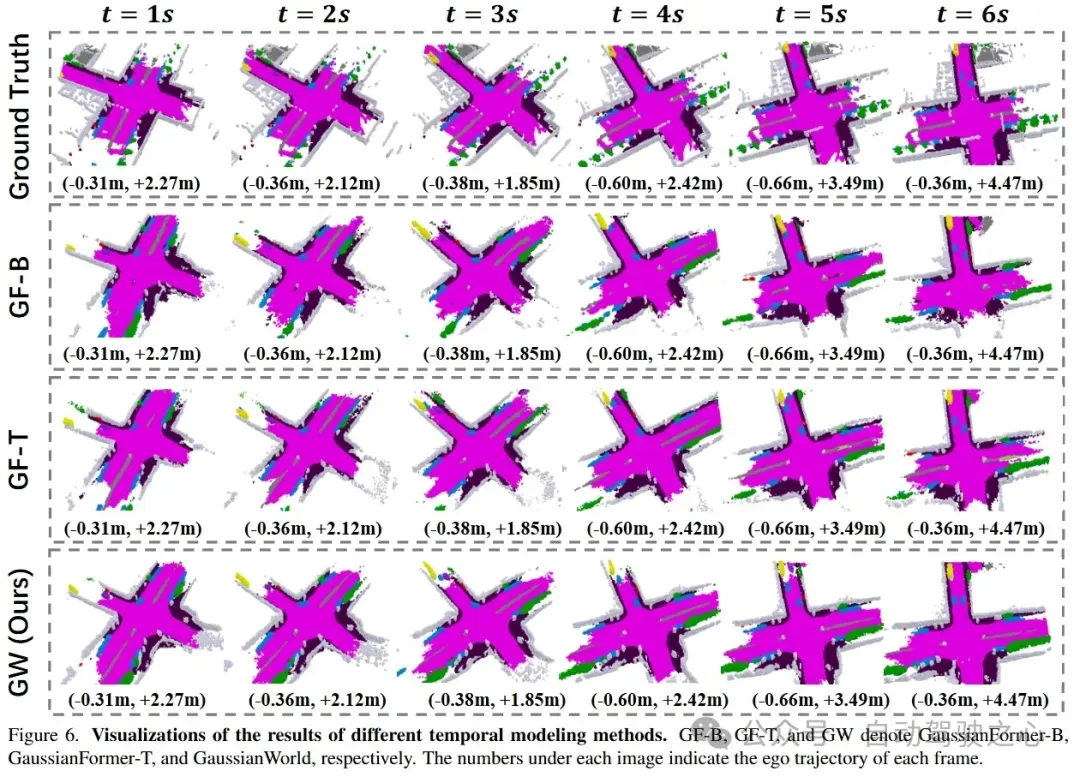

3D 占有率预测对于自动驾驶至关重要,因为它能全面感知周围环境。为了融合序列输入,大多数现有方法将先前帧的表示融合起来以推断当前的 3D 占有率。然而,它们未能考虑驾驶场景的连续性,并且忽略了 3D 场景演变所提供的强大先验信息(例如,只有动态物体在移动)。在本文中,我们提出了一种基于世界模型的框架,以利用场景演变进行感知。我们将 3D 占有率预测重新表述为一个基于当前传感器输入的 4D 占有率预测问题。我们将场景演变分解为三个因素:1)静态场景的自身运动对齐;2)动态物体的局部移动;3)新观察到场景的补全。然后,我们采用高斯世界模型(GaussianWorld)来明确利用这些先验信息,并在考虑当前 RGB 观测的情况下,在 3D 高斯空间中推断场景演变。我们在广泛使用的 nuScenes 数据集上评估了我们框架的有效性。我们的GaussianWorld在不增加额外计算量的情况下,将单帧对应模型的 mIoU 性能提高了 2% 以上。

Self-supervised Multi-future Occupancy Forecasting for Autonomous Driving

- paper: https://arxiv.org/abs/2407.21126

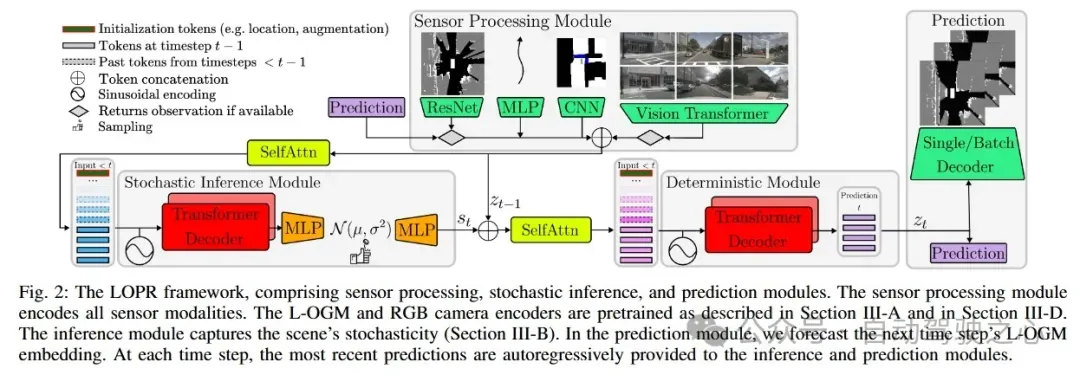

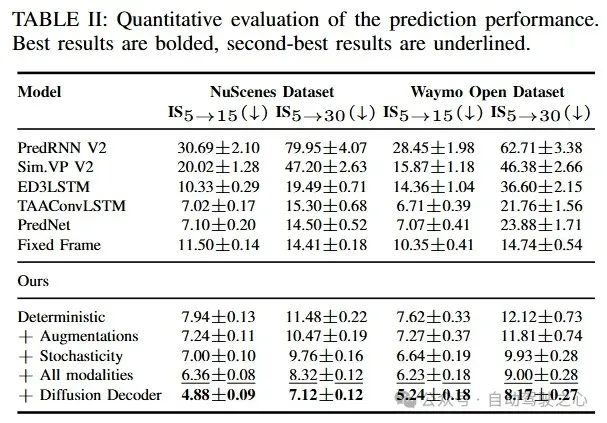

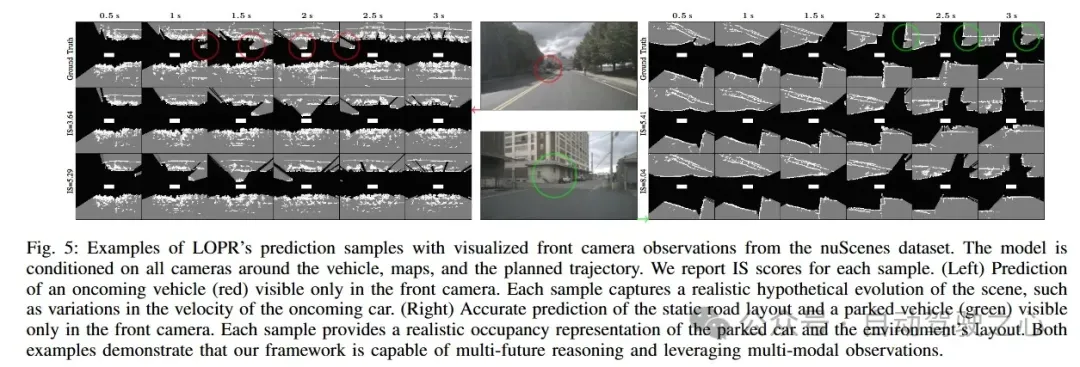

环境预测框架对于自动驾驶汽车(AV)在动态环境中的安全导航至关重要。激光雷达生成的占用网格地图(L-OGM)为场景表示提供了可靠的鸟瞰视角,能够实现自监督的联合场景预测,同时对部分可观测性和感知检测失败具有较强的鲁棒性。先前的方法主要集中在网格单元空间内的确定性 L-OGM 预测架构上。尽管这些方法取得了一定的成功,但它们经常产生不切实际的预测,并且无法捕捉环境的随机性。此外,它们还不能有效地整合自动驾驶汽车中现有的其他传感器模态。我们提出的框架在生成架构的潜在空间中进行随机 L-OGM 预测,并允许基于 RGB 相机、地图和规划轨迹进行条件设置。我们使用单步解码器来解码预测,该解码器能够实时提供高质量的预测,或者使用基于扩散的批处理解码器,该解码器可以进一步优化解码帧,以解决时间一致性问题并减少压缩损失。我们在 nuScenes 和 Waymo Open 数据集上进行的实验表明,我们方法的所有变体在定性和定量方面都优于先前的方法。

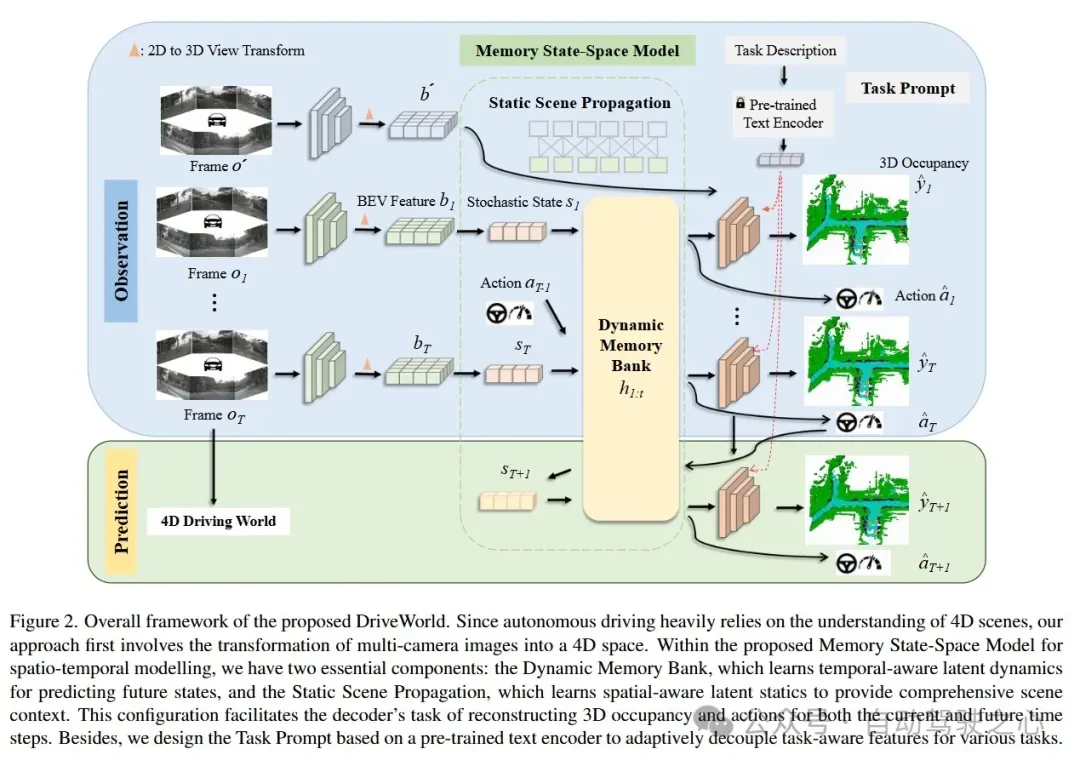

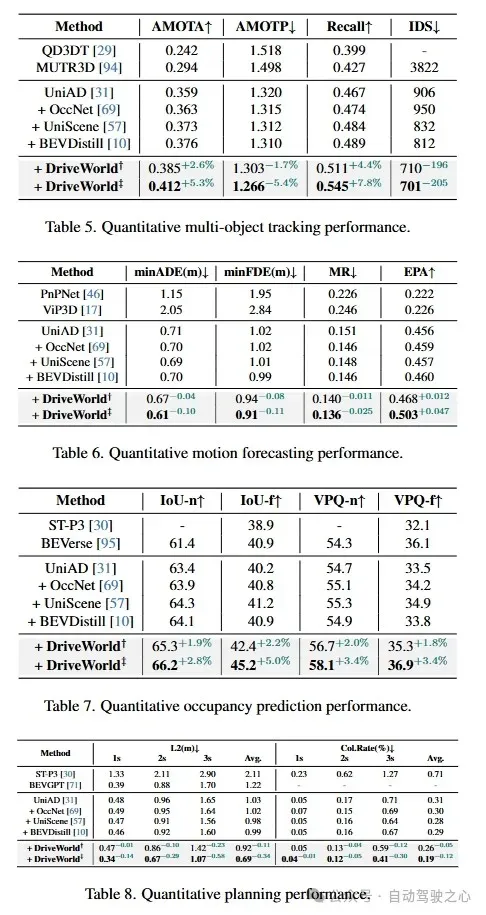

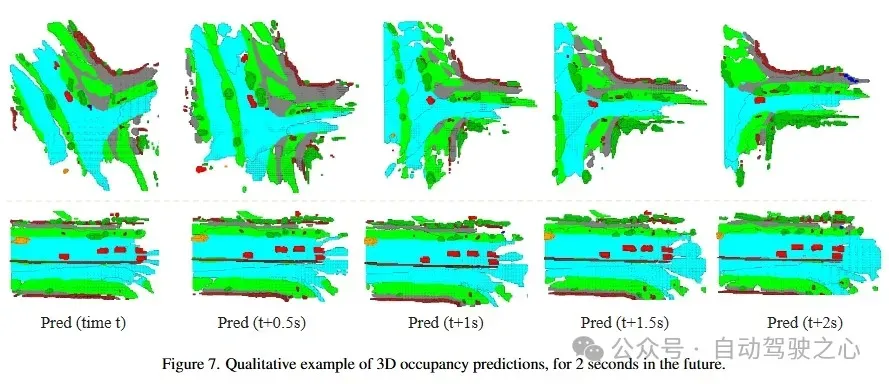

DriveWorld: 4D Pre-trained Scene Understanding via World Models for Autonomous Driving

- paper: https://arxiv.org/abs/2405.04390

以视觉为中心的自动驾驶由于成本较低,近来受到了广泛关注。预训练对于提取通用表示至关重要。然而,当前以视觉为中心的预训练通常依赖于 2D 或 3D 的预训练任务,忽略了自动驾驶作为 4D 场景理解任务的时间特性。在本文中,我们通过引入一个基于世界模型的自动驾驶 4D 表示学习框架来解决这一挑战,该框架被称为DriveWorld,能够从多摄像头驾驶视频中以时空方式预训练。具体而言,我们提出了一种用于时空建模的记忆状态空间模型,它由一个动态记忆库模块组成,用于学习具有时间感知的潜在动态以预测未来变化,以及一个静态场景传播模块,用于学习具有空间感知的潜在静态以提供全面的场景上下文。我们还引入了一个任务提示,以解耦适用于各种下游任务的任务感知特征。实验表明,DriveWorld 在各种自动驾驶任务中取得了令人鼓舞的结果。在使用 OpenScene 数据集进行预训练时,DriveWorld 在 3D 物体检测方面实现了 7.5% 的 mAP 提升,在在线地图绘制方面实现了 3.0% 的 IoU 提升,在多目标跟踪方面实现了 5.0% 的 AMOTA 提升,在运动预测方面实现了 0.1 米的 minADE 降低,在占用预测方面实现了 3.0% 的 IoU 提升,在规划方面实现了平均 L2 误差 0.34 米的减少。

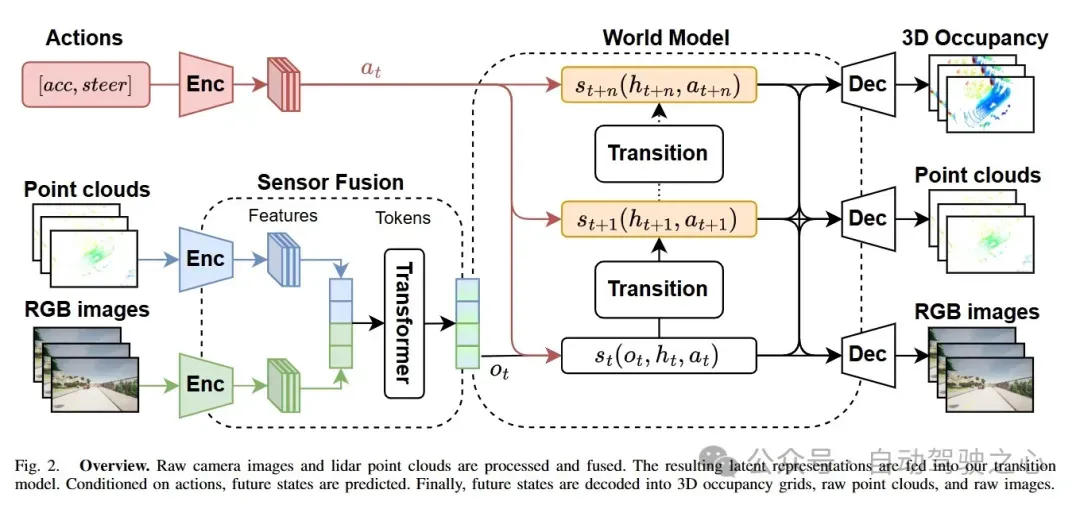

MUVO: A Multimodal World Model with Spatial Representations for Autonomous Driving

- paper: https://arxiv.org/abs/2311.11762

- code: https://github.com/fzi-forschungszentrum-informatik/muvo

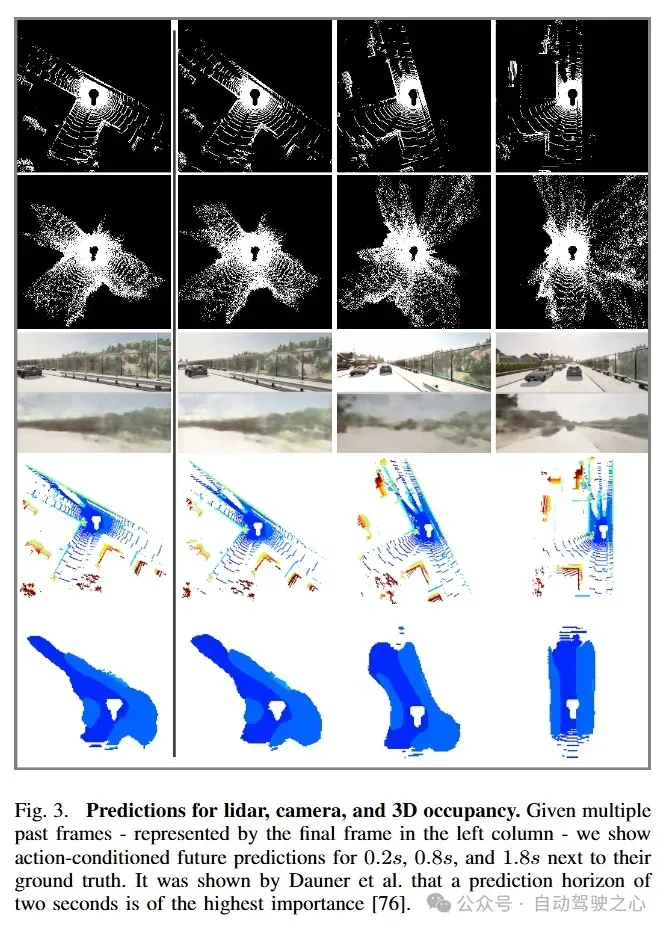

为自动驾驶学习无监督世界模型有可能极大地提升当今系统的推理能力。然而,大多数工作都忽略了世界的物理属性,仅关注传感器数据。我们提出了 MUVO,一种具有空间体素表示的多模态世界模型,以应对这一挑战。我们利用原始的摄像头和激光雷达数据来学习一种与传感器无关的世界几何表示。我们展示了多模态的未来预测,并表明我们的空间表示提高了摄像头图像和激光雷达点云的预测质量。

总结

- OCC+世界模型的范式具有很大的潜力,相信接下来会有更多的相关工作;

- 使用diffusion-base的世界模型生成未来时刻的数据这个过程比较耗时,同时多帧以及多传感器的融合策略也可能会影响实时性;

- OCC的演变本身依赖于世界模型的生成能力,但是目前训练一个精确理解物理世界演变的世界模型非常困难,因此一定程度上会影响这类模型的性能;

- Gaussian的强大表达能力有助于提高帧间的一致性,而且相比NeRF,占用更少的资源,有待进一步探索。