本文经AIGC Studio公众号授权转载,转载请联系出处。

这项研究主要是针对如何智能控制图像中的光照,采用了一种不需要重新训练模型的新方法。简而言之,研究人员利用一种叫作Retinex理论的方法,先识别出图像中的光照元素,然后用这些元素来指导图像生成模型。具体来说,就是通过设定灯光的类型和位置,调整生成的图像的亮度、阴影和光照方向,而这一切都无需额外的数据支持。这意味着无论是创造新的图像还是修整现有的图像,用户都能快速实现想要的光照效果,而且过程简单易行。这种创新的做法大大提高了扩散模型在图像生成过程中的灵活性和实用性。

相关链接

论文地址:https://arxiv.org/pdf/2407.20785v1

论文阅读

Retinex-Diffusion:利用Retinex理论控制扩散模型中的光照条件

Retinex-Diffusion:利用Retinex理论控制扩散模型中的光照条件

摘要

本文介绍了一种在扩散模型中处理光照操作的新方法,着重解决了光照条件下的间隙条件图像生成问题。我们将扩散模型概念化为黑盒图像渲染,并根据图像形成模型有策略地分解其能量函数。该方法在生成过程中有效地分离和控制与光照相关的属性。它生成具有逼真照明效果的图像,包括投射阴影,软阴影和相互反射。值得注意的是,它不需要学习内在分解,在潜在空间中寻找方向,也不需要对新数据集进行额外的训练。

方法

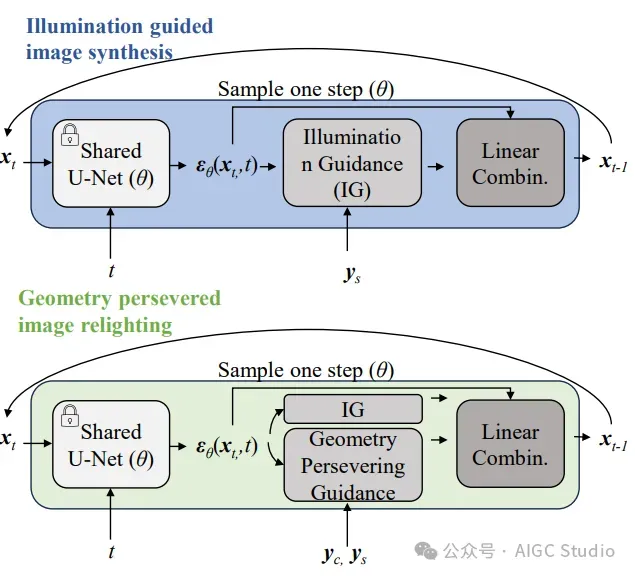

我们的方法执行两个任务:

- 它可以控制生成图像的照明条件

- 它可以在realimages上应用新的照明条件。

为了完成这些任务,我们首先重新表述了扩散过程中的能量函数。然后介绍了图像合成中的照明制导。最后,我们提出了真实图像的几何保留重照明。值得注意的是,这个管道不需要进一步训练,也不需要额外的数据标签或CGI技术。

效果

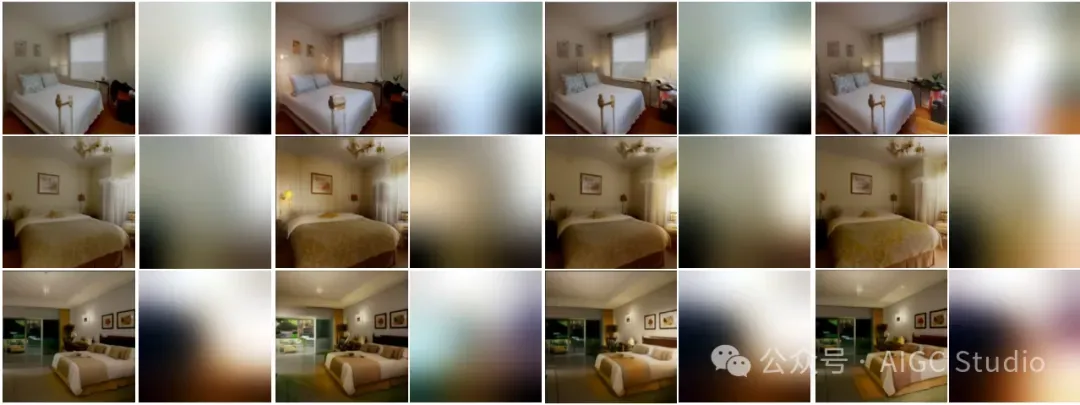

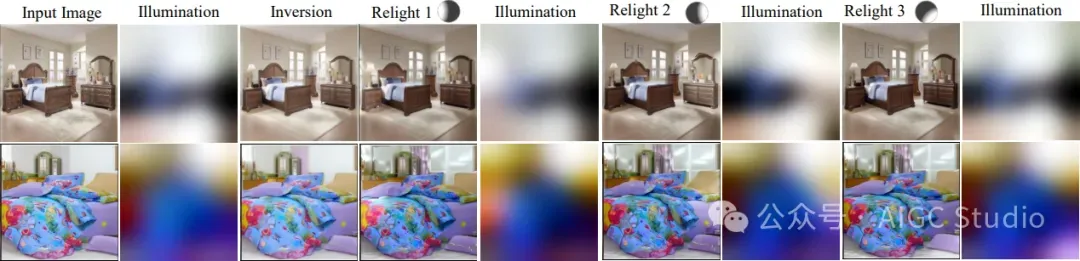

照明属性引导图像生成:每对列显示生成的图像及其相应的照明特征。最初的两列表示没有照明引导的原始图像及其照明特征。随后的栏目展示了在各种特定照明条件下生成的图像,照明方向由球体表示。

照明属性引导图像生成:每对列显示生成的图像及其相应的照明特征。最初的两列表示没有照明引导的原始图像及其照明特征。随后的栏目展示了在各种特定照明条件下生成的图像,照明方向由球体表示。

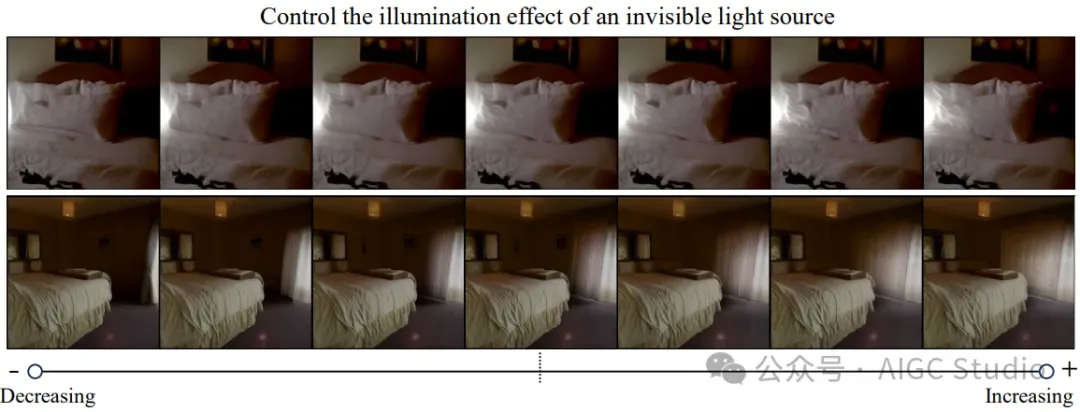

不可见光源的照明效果控制。给定相同的照明方向提示,我们的方法能够产生与光源强度相关的多种照明效果。

不可见光源的照明效果控制。给定相同的照明方向提示,我们的方法能够产生与光源强度相关的多种照明效果。

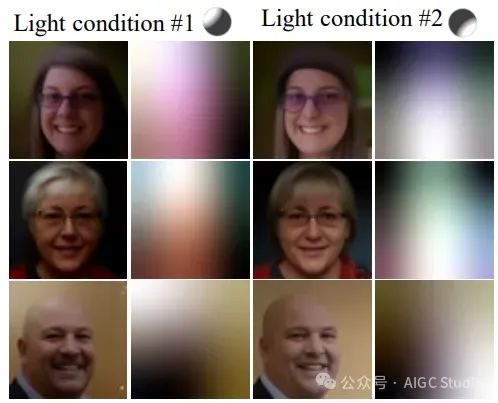

照明属性引导图像生成:每对列显示生成的图像及其相应的照明特征。由球体指示的照明方向。

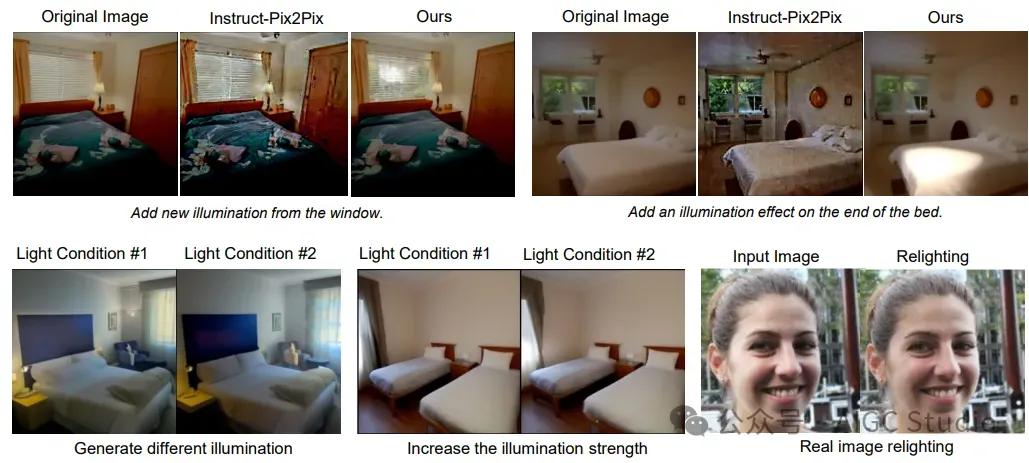

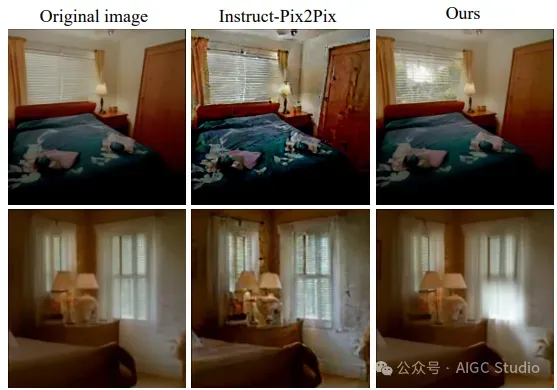

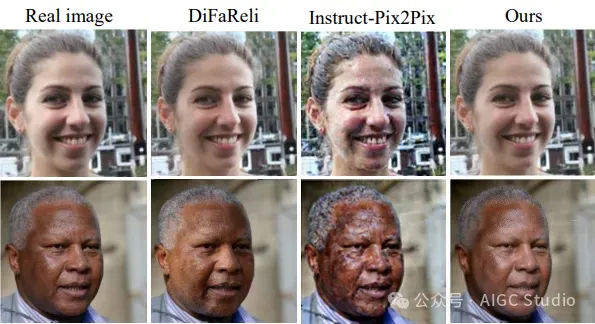

在产生新的光照条件的背景下,最先进图像与图像扩散模型的视觉比较。

几何保持图像重光照:从左到右的顺序显示了原始输入图像、倒转图像和三种不同光照条件下的图像重光照结果(分别表示为Relight 1、Relight 2和Relight 3)。这种顺序证明了我们的方法在改变光照条件的同时保持几何一致性的有效性。由球体指示的照明方向。

真实室内图像重新照明对比

真实人脸图像重光照对比

结论

我们提出了一种新颖的、基于物理的、无需训练的方法,用于在扩散生成和真实图像中操纵照明。该方法在图像形成模型的基础上,通过对扩散模型的能量函数进行改造,实现了光照条件下图像的精确生成。我们的方法不需要任何类型的额外培训或方向研究。它很容易嵌入到当前的扩散模型中。通过提示与照明相关的特征,扩散模型能够为适当的照明条件(如打开灯和打开窗户)生成/调整与照明相关的语义。

限制。 这种照明控制并不总是准确的,它与预训练扩散模型的学习数据分布一致。今后需要对扩散模型的本征提取进行更深入的研究。