前言:

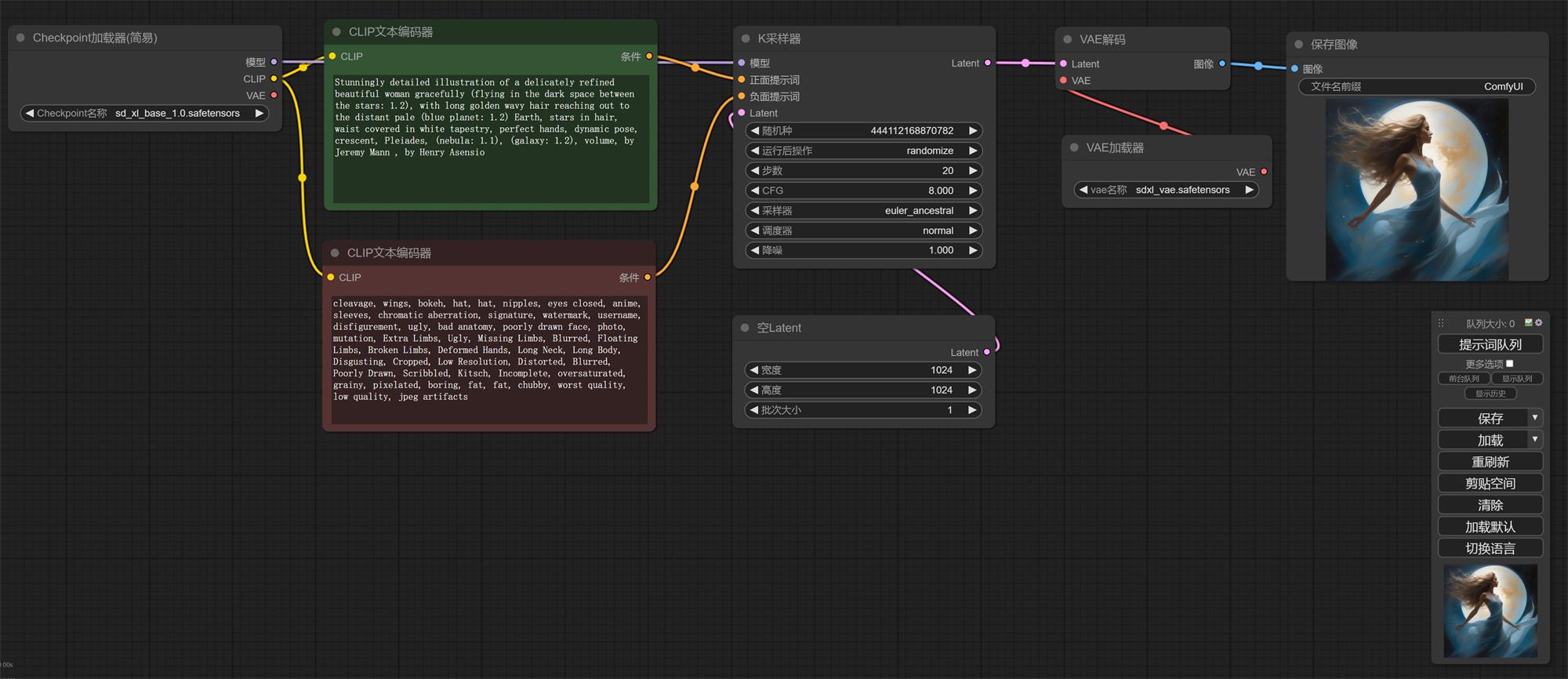

1. 这节课我们开始学习 ComfyUI,我们先从最基础的文生图开始学起。为了方便讲解(方便我这英语不好的人),我文章中的节点大多都是汉化之后的,和我一样英语不好的小伙伴还请看我上篇内容,安装汉化插件。

上期回顾:

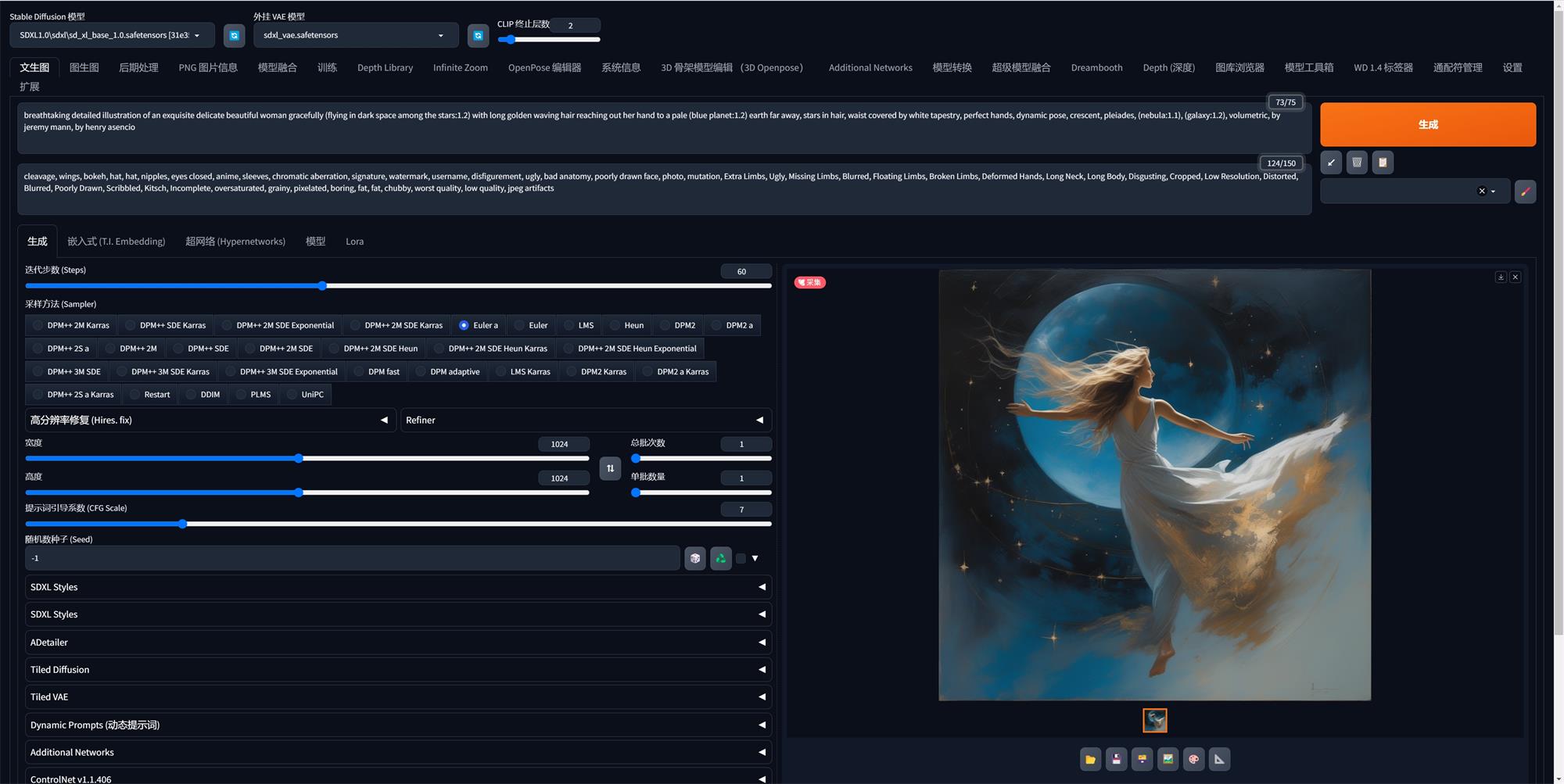

2. 在学习前我们先回忆一下使用 Web UI 进行文生图的时候用到了哪些功能。

3. 是不是有大模型、正向提示词、反面提示词、采样器、步数、宽高、VAE、显示图像。既然我们知道有哪些节点,就把他们按照流程去连起来吧。

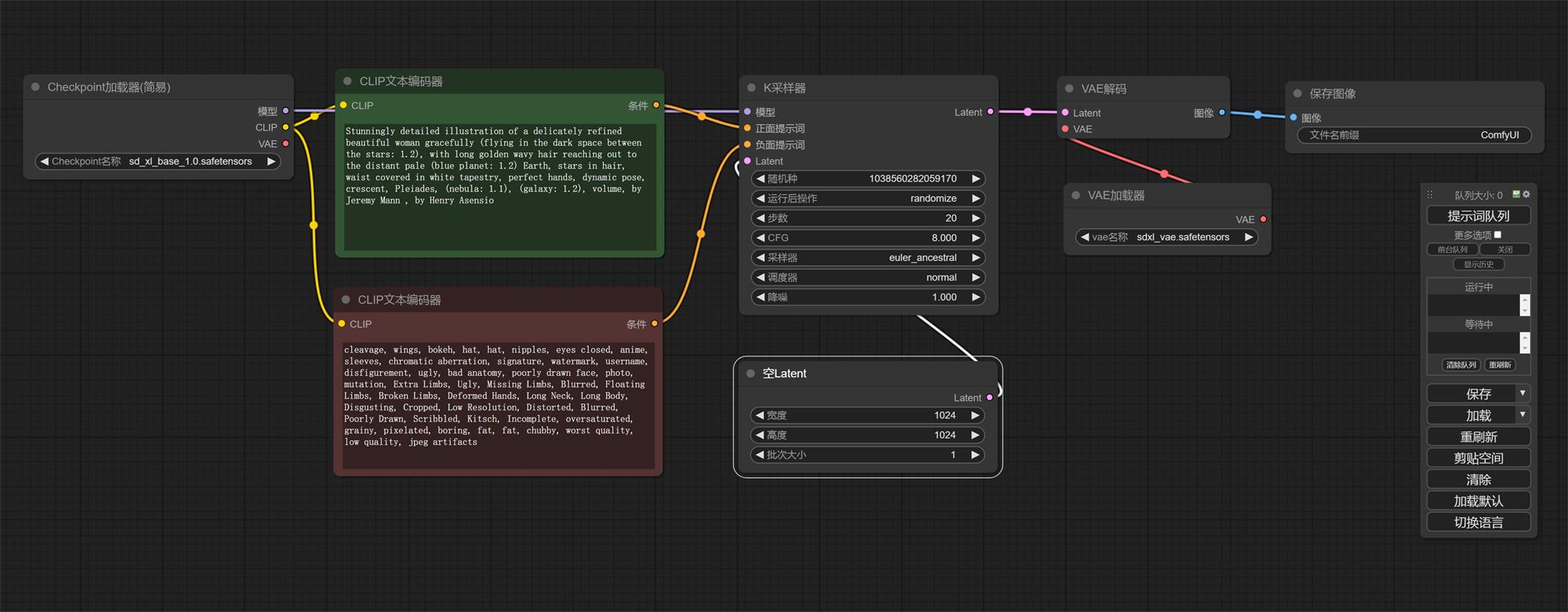

一、创建流程

大模型加载器:

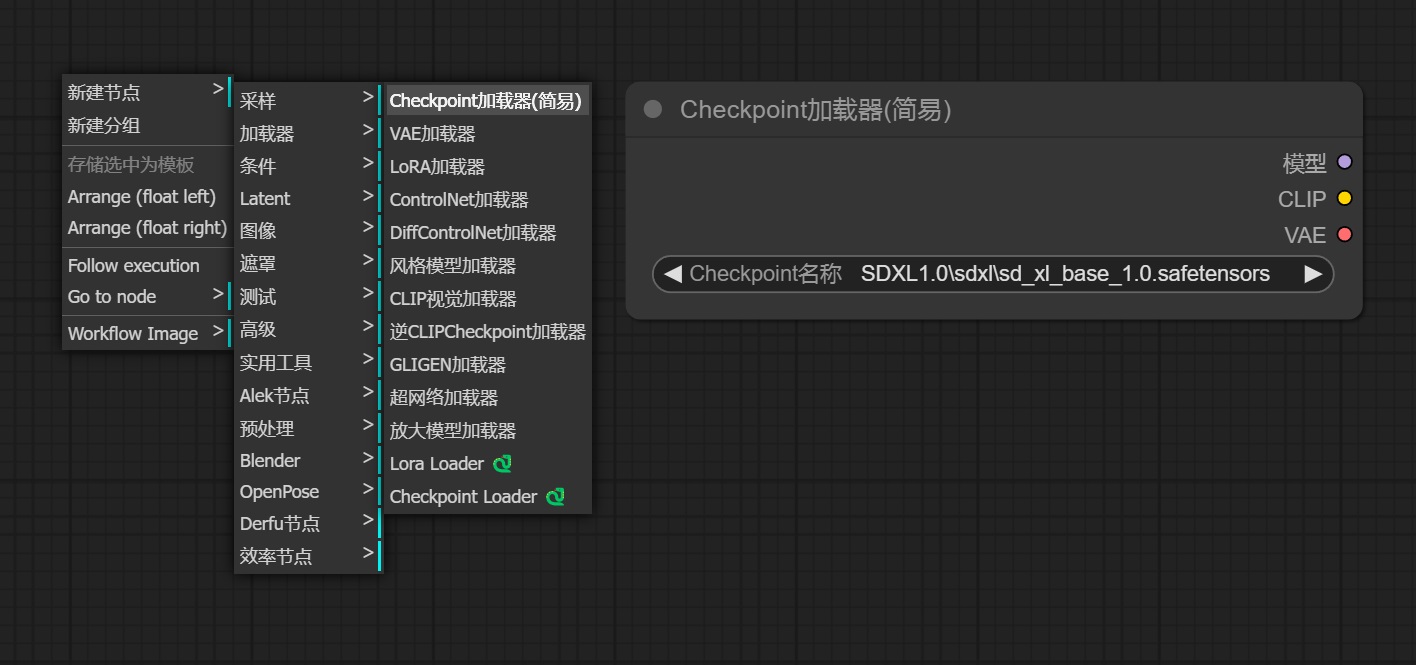

1. “右键——新建节点——加载器”我们会看到很多加载器,看名字是不是都挺熟悉的,没错这就是我们需要用到的“Checkpoint加载器(大模型加载器)、VAE加载器、Lora加载器等”我们先把大模型加载器添加进来(也可以使用 Checkpoint Loader,这是我们上节课安装的 ComfyUI-Custom-Scripts 插件中的加载器,可以用来预览缩略图)。

2. 点击“Checkpoint 名称”位置选择我们需要的模型。

文本输入节点(CLIP 文本编码器):

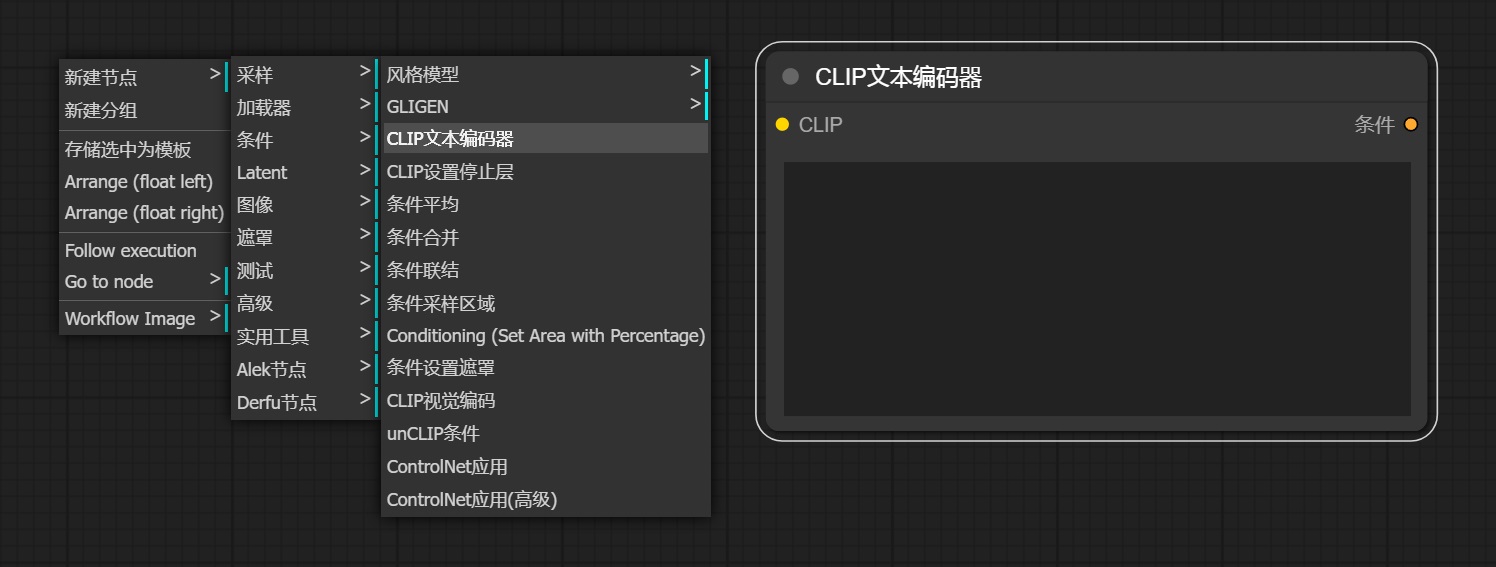

1. 接下来我们去添加关键词输入节点,这时候要注意了,他没有正、反关键词的区分,都是用的一个叫“CLIP 文本编码器的节点”。

2. 我们用同样的方法“右键——新建节点——条件——CLIP文本编码器”,这个地方我们要添加两个“CLIP文本编码器”用来输入正、反关键词。

3. 因为没有区分正反关键词,我们可以自己去修改名称和颜色用于区分,我们在节点上方“右键——标题”输入名称后确定就可以。修改节点颜色也是“右键——颜色”然后选择颜色就可以了。

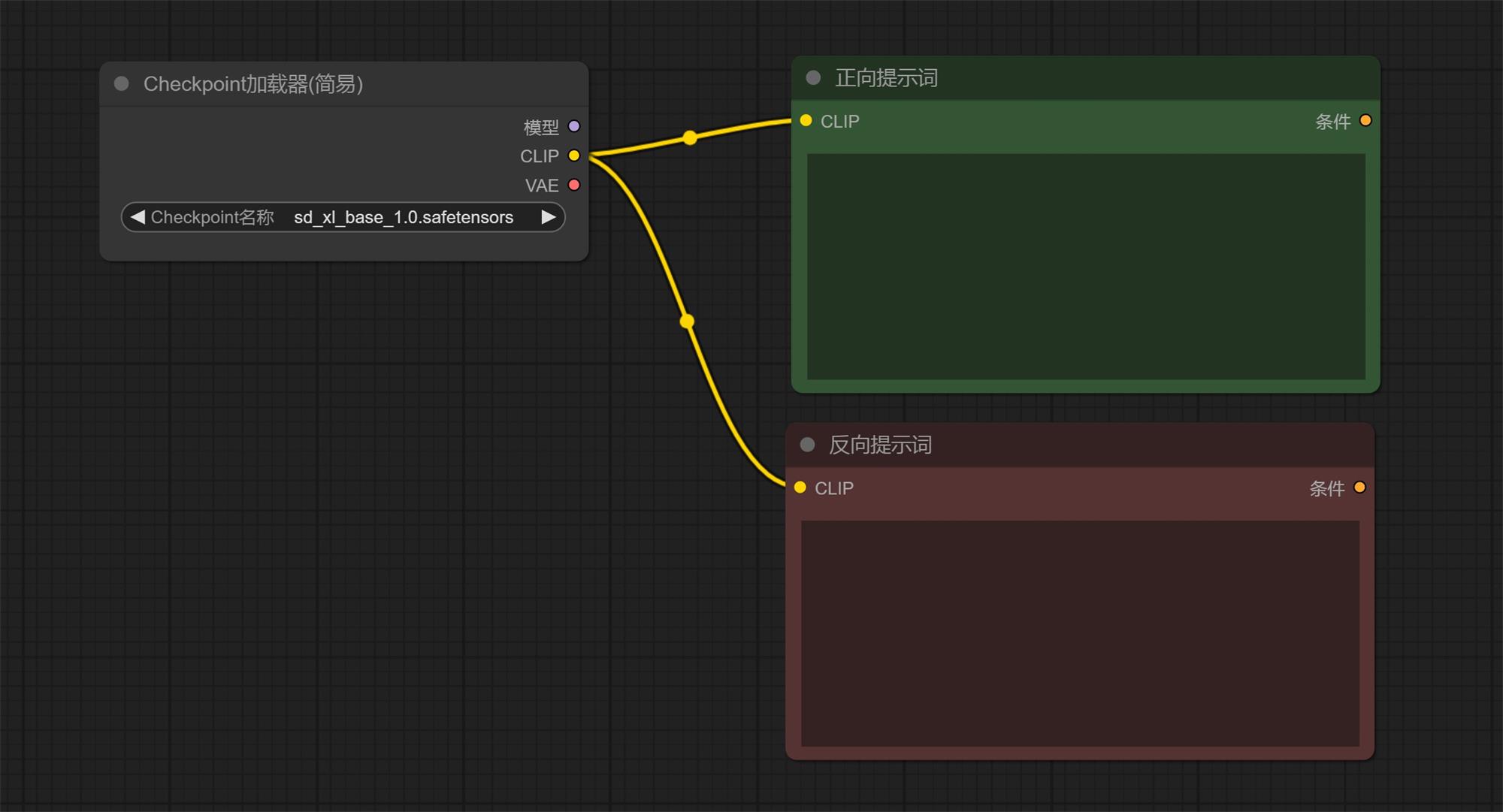

4. 这时候我们是不是发现“Checkpoint 加载器”和“CLIP 文本编码器”上面都有一个同样名称、同样颜色的黄点“CLIP”,我们把它连起来(鼠标放在上面会有“十”字标识,我们左键按住住拖到另一个节点的对应位置就连上了)。

注意:我们 Checkpoint 加载器只有一个 CLIP 连接点,而我们需要连接正面、反面两个提示词。这个地方我们可以理解为作为输出可以连接多个节点,作为输入只能连接一个。

采样器:

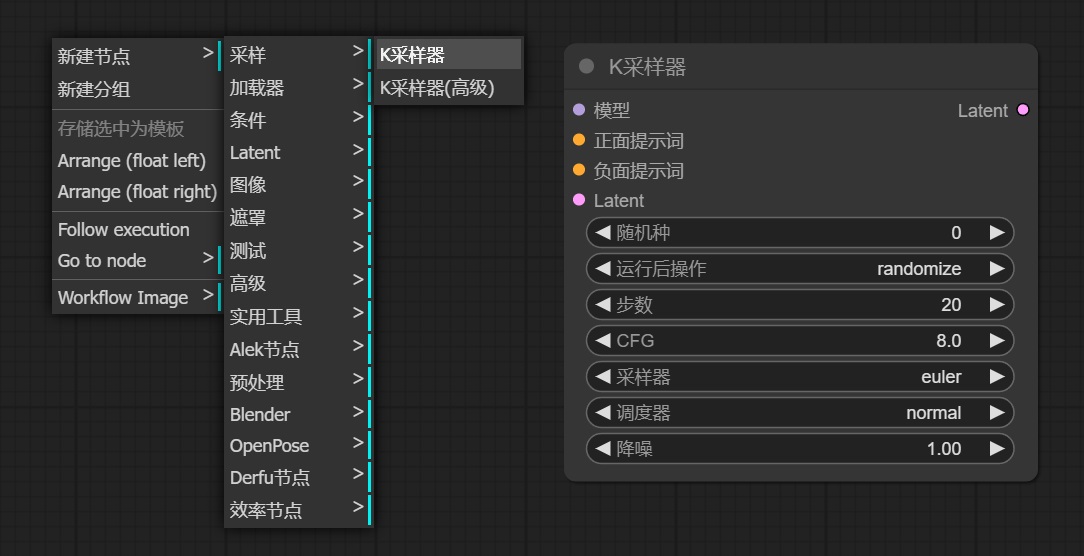

1. “右键——采样——采样器(这个地方是有两个采样器的,我们选择普通的采样器就好)”。

2. 我们可以在采样器上看到 7 个可以修改的选项:

a. 随机种:随机种子,每张图都有一个随机的编号;

b. 运行后操作:种子是需要固定、增加(在原来的种子值上+1)、减少、随机,我们一般用的是固定和随机;

c. 步数:设置我们画这张图需要去除噪波的次数;

d. CFG:提示词引导系数,越大越符合提示词,基本在 8 左右就够了;

e. 采样器:这个选项有太多了,我们在使用 Web UI 的时候也需要进行选择,后面我找时间挨个介绍一下他们的区别,我通常会选择 euler_ancestral(web ui 中的 Euler a)、dpmpp_2m(DPM++ 2m)、dpmpp_2m_sde_gpu

f. 调度器:每一次迭代步数中控制噪声量大小的,一般我们选择 normal 或 karras;

g. 降噪:和步数有关系,1 就是我们 100%的按照上方输入的步数去完成,0.1 就是 10%,这里我们填 1。

3. 这时候我们会看到左侧有“模型、正面提示词、负面提示词、Latent”四个可连接的点;

4. 我们分别把“模型”和“Checkpoint 加载器的模型”相连,“正面提示词”和“正面提示词的条件”相连,“负面提示词”和“负面提示词的条件”相连。

5. 这时候我们还剩下一个“Latent”,这个我们用来连接控制出图宽高的节点。

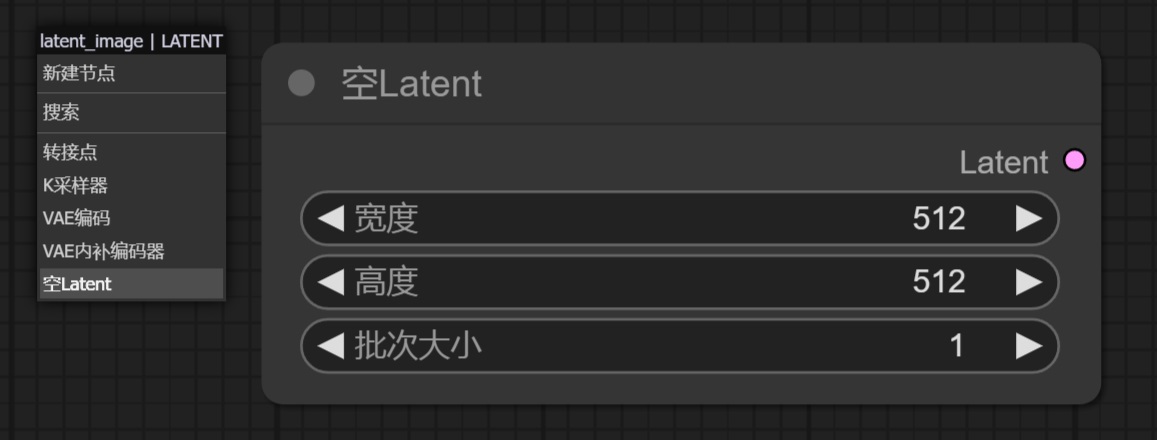

宽高(空 Latent):

1. 鼠标点击住“Latent”往外拉,松开然后选择“空 Latent”,直接添加节点并连接上了。

2. 此添加节点的方法适用于任何一个节点(前面的模型、CLIP 都可以通过这个方式快速的添加节点)。

3. 宽高就不用说了吧,批次就是一次出几张图的意思。

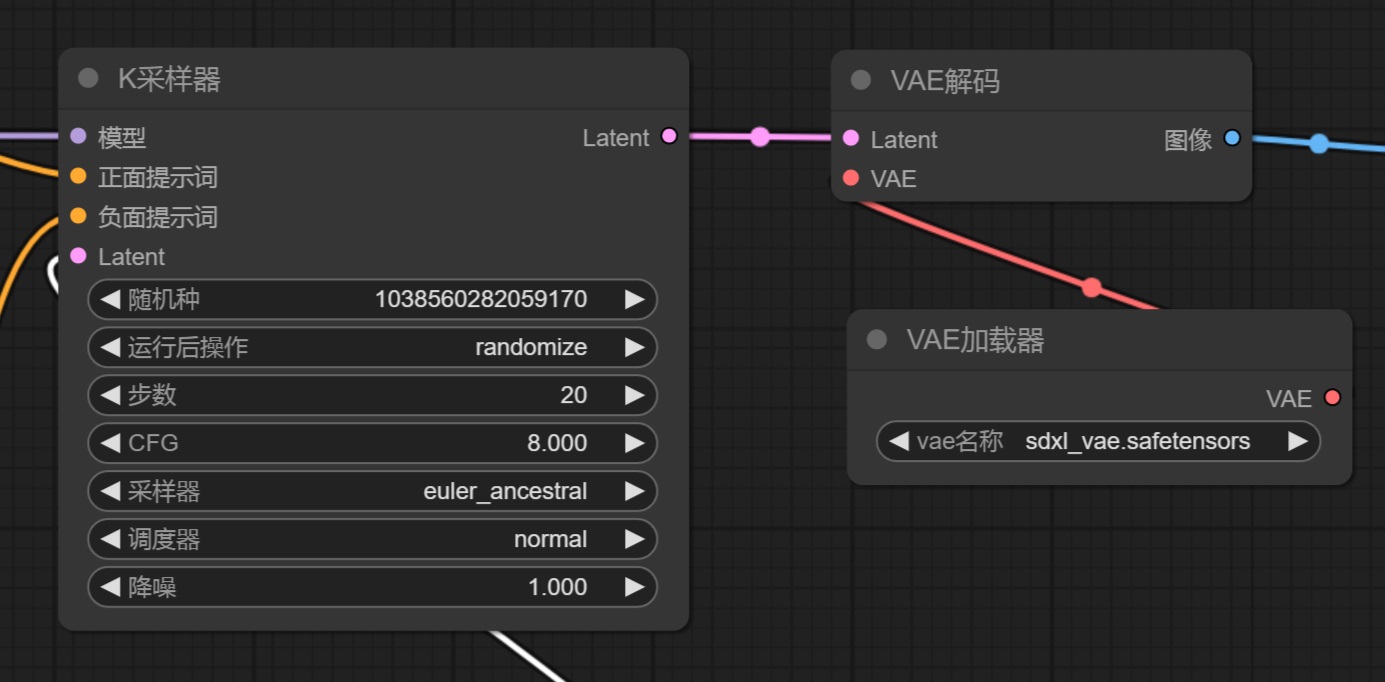

VAE 解码:

1. 注意:这个地方我们选择的不是“VAE 加载器”,而是“VAE 解码”

2. “右键——新建节点——Latent——VAE解码”(和前面一样直接左键拖拽也可以);

3. “VAE 解码的 Latent”和“采样器的 Latent”相连,这时候左侧会剩下一个 VAE;

4. 我们是不是想起来“Checkpoint 加载器”还剩一个“VAE”没有连接,我们把它两个连在一起就可以了(这个地方要注意一下,大部分大模型都包含有 VAE 模型在里面的,我们可以直接连接;也可以添加一个“VAE 加载器”去加载一个 VAE 模型进行连接;这两个连接方法我们选其中一个就可以)。

保存图像:

1. “右键——新建节点——图像——保存图像”(或左键拖拽),这个地方我们可以有两种选择“保存图像”和“预览图像”。

2. 保存图像相比预览图像来说多了一个功能就是把生成的图像保存到“ComfyUI 下的 output”文件夹里面。

3. 保存图像同样具有预览的功能。

二、出图

1. 这个时候我们已经连接好所有节点了,输入关键词,调节好模型、步数、宽高等;

2. 点击右侧设置面板的“提示词队列”,或者“ctrl+回车”进行出图就可以了;

3. 只要是出图成功,就说明我们连接的节点没问题,可以按照我上节课教的把工作流保存下来,以便日后使用;

4. 在出图的过程中我们可以看到进行到哪一步,哪一个节点就会有绿色的框,非常方便我们熟悉流程。