在数字化转型的浪潮中,人工智能正以前所未有的速度渗透到企业运营的各个环节。尤其对于算力需求旺盛的企业,例如那些关注Nvidia GPU、A800、H100等高性能计算资源的公司,以及积极探索AI Agent(如AutoGen、Devin AI)和低代码平台潜力的组织,如何安全、高效地利用AI提升内部知识管理和对外服务能力,成为其保持竞争力的关键。本文将深入探讨如何通过DeepSeek强大的语言模型,结合Dify便捷的AI应用开发平台,构建一个私有化部署的企业知识库,为企业带来更智能、更安全、更高效的知识管理体验。

企业知识库的智能升级迫在眉睫

企业知识库作为组织智慧的沉淀,是员工获取信息、解决问题的重要工具。然而,传统的知识库往往面临信息孤岛、检索效率低下、内容更新滞后等问题。将AI能力融入知识库,能够实现更精准的语义搜索、更智能的问答交互、更高效的内容管理,从而极大地提升知识库的价值。

为什么选择私有化部署DeepSeek?

简单来说,私有化部署就是将DeepSeek AI模型安装在您自己的服务器或者电脑上,而不是使用像ChatGPT那样的在线服务。这样做的好处显而易见:

- 数据安全: 敏感的企业数据不会离开您的内部网络,从根本上降低了数据泄露的风险。

- 合规性: 满足行业特定的数据隐私法规,例如金融、医疗等行业对数据安全有着极为严格的要求。

- 定制化: 企业可以根据自身的具体需求对模型进行调整和优化,使其更贴合业务场景。

- 成本效益: 长期来看,对于高频使用的场景,私有化部署可能比按量付费的云服务更经济。

图片

图片

强大组合: DeepSeek AI 与 Dify

要构建这样一个私有化的智能知识库,我们需要两个核心组件:强大的AI模型和便捷的应用开发平台。DeepSeek AI 和 Dify 的组合正是为此而生。

DeepSeek AI:为企业知识库注入强大动力

DeepSeek AI 是一家专注于开发高性能、低成本大语言模型和AI系统的创新企业。其核心技术基于先进的Transformer架构和独特的MoE(混合专家)模型,使其在自然语言处理、代码生成、数学推理等方面表现出色。DeepSeek AI 的优势在于卓越的推理能力、强大的多语言支持、开源与企业级并重的策略,以及高效且经济的特性。

Dify:简化私有化AI知识库的构建与部署

Dify 是一款开源的AI应用开发平台,致力于帮助开发者快速构建和部署各种AI应用,包括我们这里要构建的智能知识库助手。Dify 的特点是易于使用,并且支持集成各种不同的AI模型,包括DeepSeek。其简易的私有化部署、灵活的模型集成、强大的知识库管理功能以及低代码/无代码的应用构建能力,大大降低了构建智能知识库的门槛。

手把手教程:构建您的私有化AI知识库

接下来,我们将一步步指导您如何使用 DeepSeek 和 Dify 搭建企业专属的智能知识库。

先决条件

硬件要求

- CPU:≥ 4核

- 显存/内存:≥ 16GB

- 磁盘最少20GB

软件要求

- Window 8以上版本,家庭版或专业版 | MacOS M芯片/Intel | Ubuntu/Debian | Docker

部署指南

第一步DeepSeek 私有化部署

步骤:

- 安装Ollama: 访问 Ollama 官方网站 根据您的操作系统(Windows、macOS 或 Linux)下载并安装Ollama。Windows用户可能需要安装 WSL 2(适用于Linux的Windows子系统) 以获得更好的兼容性。

- 验证安装: 安装完成后,打开终端(在Windows上是命令提示符或PowerShell,macOS和Linux上是Terminal),输入 ollama -v 并回车。如果显示Ollama的版本号,则说明安装成功。

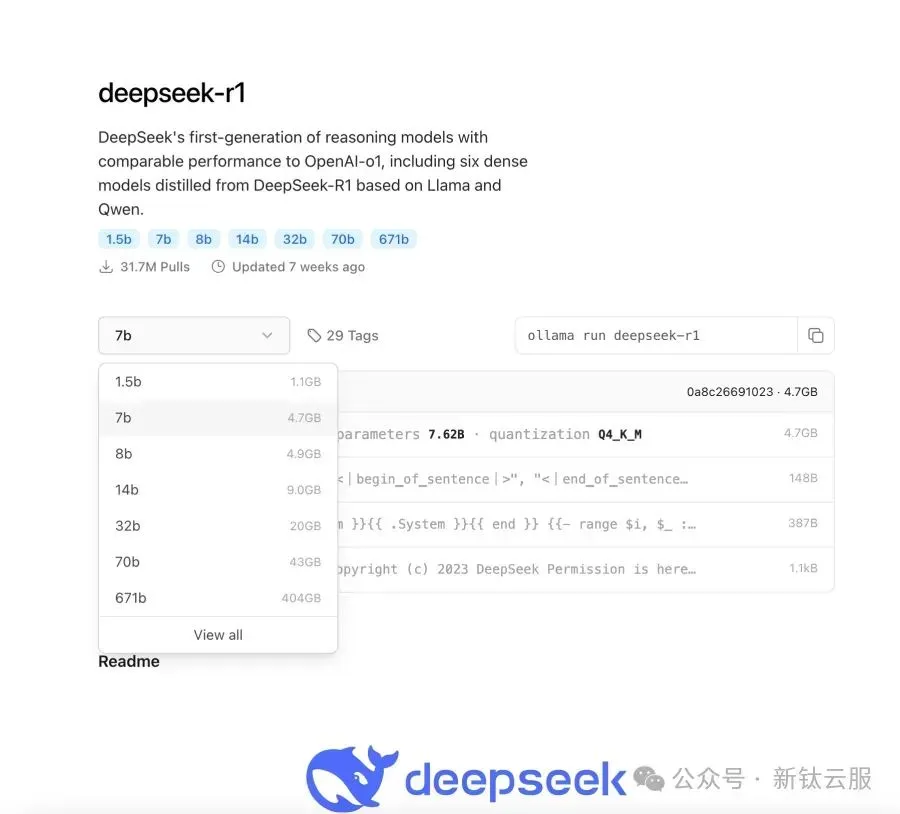

- 运行DeepSeek模型: 在终端中输入 ollama run deepseek-r1:7b 并回车。这条命令会从Ollama的服务器下载DeepSeek-R1模型的70亿参数版本,并开始在您的本地电脑上运行。Ollama首次运行模型时会需要一些时间下载模型文件,请耐心等待。下载完成后,您就可以在终端中直接与DeepSeek模型进行对话了。

图片

图片

小贴士: 您可以通过修改命令中的模型名称来运行DeepSeek的其他版本,例如 ollama run deepseek-r1:1.5b (更小的模型,资源占用更少)或者 ollama run deepseek-r1:32b (后缀B表示训练参数的数量,一般来说参数越多以为着性能越好,内存要求越高)。

图片

图片

第二步安装 Dify 社区版

Dify提供了多种安装方式,对于初学者,我们推荐使用 Docker 进行安装,因为它比较简单快捷。

步骤:

1. 安装Docker: 如果您的电脑上还没有安装Docker,请访问 Docker 官网 下载并安装适合您操作系统的Docker Desktop。

2. 克隆Dify代码仓库: 打开终端,执行以下命令克隆Dify的GitHub代码仓库:

复制git clone https://github.com/langgenius/dify.git cd dify

3. 启动Dify: 在 dify 目录下,执行以下命令启动Dify:

复制docker compose up -d

这条命令会下载Dify所需的所有组件并启动运行。首次启动可能需要一些时间。

4. 访问Dify平台: Dify社区版默认运行在您服务器或电脑的 80 端口。在浏览器中输入您服务器的IP地址(如果您在本地电脑上安装,则输入 http://localhost 或 http://127.0.0.1)。

小贴士: 如果您希望修改Dify的访问端口,可以参考Dify的官方文档。

第三步集成 DeepSeek 到 Dify

现在我们已经成功运行了DeepSeek模型和Dify平台,接下来需要将它们连接起来,让Dify能够使用我们私有化部署的DeepSeek模型。

步骤:

- 登录Dify平台: 在浏览器中打开Dify平台并登录。

- 进入模型提供商设置: 点击页面右上角的 “Profile” (个人资料) -> “Settings” (设置) -> “Model Providers” (模型提供商)。

图片

图片

- 添加Ollama模型: 在模型提供商页面,找到 “Ollama” 并点击 “Add Model” (添加模型)。

- 配置DeepSeek模型信息: 在弹出的对话框中,填写以下信息:

- Model Name (模型名称): 输入您在第一步中使用Ollama运行的DeepSeek模型名称,例如 deepseek-r1:7b。请务必与您运行的实际模型名称一致。

- Base URL (基础URL): 输入您的Ollama客户端的运行地址,通常是 http://your_server_ip:11434。如果您在本地电脑上运行,并且没有修改Ollama的默认设置,则输入 http://localhost:11434 或 http://127.0.0.1:11434。

- 其他选项保持默认值即可。

5.保存配置: 点击 “Save” (保存) 完成DeepSeek模型的集成。

小贴士: 如果您在连接过程中遇到问题,请检查您的Ollama服务是否正在运行,以及Dify平台是否能够访问Ollama的地址和端口。您可以在终端中输入 ollama list 来查看正在运行的模型。

第四步创建知识库

在Dify中,知识库是存储和管理您的企业文档的地方,这些文档将作为AI助手回答问题的依据。

步骤:

- 进入Dify首页: 登录Dify平台后,点击左侧导航栏的 “Knowledge” (知识)。

- 创建知识库: 点击 “Create Knowledge Base” (创建知识库) 按钮,并为您的知识库命名。

图片

图片

- 上传文档: 点击您创建的知识库,进入知识库详情页面。您可以点击 “Upload Files” (上传文件) 按钮上传您的企业文档。Dify支持多种文件格式,例如PDF、Word文档、TXT文件等,这里以Excel为例。

图片

图片

- 选择分块模式: 为了更好地理解文档内容,Dify会对上传的文档进行分块处理。建议您选择 “Parent-Child Chunking” (父子块分块) 模式,这样可以更好地保留文档的结构信息,提高AI回答的准确性。

- 等待AI分析: Dify会自动对上传的文档进行AI分析和索引,这个过程可能需要一些时间,具体取决于您的文档大小和数量。

小贴士: 您可以根据需要创建多个不同的知识库,用于存储不同类型或不同部门的知识。

第五步将知识库集成到 AI 应用

现在我们已经创建了包含企业知识的知识库,接下来需要将其关联到我们的AI应用中,这样AI才能在回答问题时查阅这些知识。

步骤:

- 进入Dify首页: 登录Dify平台后,点击左侧导航栏的 “Applications” (应用)。

图片

图片

- 创建AI应用: 点击 “Create Blank App” (创建空白应用),选择 “Chatbot” (聊天机器人) 或 “Chatflow” (对话流/工作流),并为您的应用命名。

图片

图片

- 配置AI应用的上下文: 进入您创建的AI应用的编辑页面,找到 “Context” (上下文) 部分。

- 添加知识库: 在上下文部分,点击 “Add Knowledge Base” (添加知识库),选择您在第四步中创建的知识库,并点击 “Confirm” (确认)。

图片

图片

小贴士: 您可以在一个AI应用中集成多个知识库,以便AI可以查阅更全面的信息,当前知识库显示信息都是测试假数据。

第六步构建智能问答应用

最后一步是配置我们的AI应用,使其能够利用集成的DeepSeek模型和企业知识库来回答用户的问题。

步骤(以Chatbot应用为例):

1. 选择模型: 在AI应用的编辑页面,找到 “Model Provider” (模型提供商) 部分,在下拉菜单中选择您在第三步中集成的 “Ollama”,然后在 “Model” (模型) 下拉菜单中选择您的DeepSeek模型,例如 deepseek-r1:7b。

2. 配置提示词(Prompt): 在 “Prompt” (提示词) 部分,您可以设置一些引导AI如何回答问题的指令。对于一个简单的知识库问答应用,您可以设置类似以下的提示词:

复制你是一个基于以下知识库的企业智能助手,请根据知识库的内容回答用户的问题。如果知识库中没有相关信息,请告知用户。

知识库内容:

{{context}}

用户问题:{{question}}

答案:其中 {{context}} 会被Dify自动替换为从知识库中检索到的相关内容,{{question}} 会被替换为用户提出的问题。

3. 测试您的应用: 在编辑页面的右侧,有一个 “Preview” (预览) 窗口,您可以在这里输入问题来测试您的智能问答应用。如果一切配置正确,AI应该能够根据您的知识库内容给出回答。

步骤(以Chatflow/Workflow应用为例):

- 添加LLM节点: 在Chatflow或Workflow的编辑页面,点击 “+ Add Node” (添加节点),选择 “LLM” (语言模型)。

- 配置LLM节点: 在LLM节点的配置中,选择 “Ollama” 作为模型提供商,并选择您的DeepSeek模型。在 “System Prompt” (系统提示) 中,您可以输入类似的提示词,使用 {{#sys.query#}} 变量来获取用户的输入。

- 添加知识库检索节点(可选但推荐): 为了更精确地从知识库中获取信息,您可以添加一个 “Knowledge Retrieval” (知识检索) 节点,并选择您创建的知识库。将用户的输入连接到知识库检索节点,并将检索结果连接到LLM节点的上下文。

- 添加结束节点: 添加一个 “End” (结束) 节点,并将LLM节点的输出连接到结束节点。

- 测试您的应用: 点击页面右上角的 “Preview” (预览) 按钮进行测试。

更高级的功能:

Dify还提供了更高级的功能,例如集成网页搜索、使用代码执行节点处理搜索结果、以及更复杂的对话流程控制。您可以根据您的具体需求进行探索和配置。

通过以上步骤,您就可以成功地将私有化部署的DeepSeek模型与Dify平台和您的企业知识库集成起来,构建一个智能、安全、高效的企业专属AI知识库助手了!希望这些详细的步骤能够帮助您更好地理解和实践。