作者 | 赖文昕

编辑 | 陈彩娴

「伟大的事情从来不是一个人做的,而是由一群人做的。」

智驾向左,具身向右

2015 年的一天,赵行走出 MIT的实验室,收到了浙大本科同级朋友董思远的消息,向同样涉足过光学的他了解 CSAIL 里各位教授的具体研究方向,也想到 MIT 里做些 CV 的工作。

两年前,这两位青年从浙大毕业后赴美深造,都围着视觉打转:赵行到 MIT读博,先后师从Ramesh Raskar和Antonio Torralba教授,研究计算成像和多模态学习;董思远到康涅狄格大学读研,师从郑国安,研究傅里叶叠层成像技术。

在接下来的十年里,两位从 CV 出发的年轻人都面对着同一个问题:做自动驾驶还是做智能机器人?

迄今为止,他们已回答过两遍这个问题,做出了两次不同的选择。

在 MIT 的头两年里,赵行意识到,计算成像的应用,尤其是拍照的社会影响力不够大——而自己想做能在现实世界产生价值、提高生产力的事。

2015 年,赵行决定不做计算成像后,开始参与多个项目探索自己感兴趣的方向,首先找到了 MIT Cheetah 系列四足机器人的负责人 Sangbae Kim教授,提出做其机器人课的助教。

MIT Cheetah 是仿生机器人领域的里程碑式成果,通过全电机驱动系统和高性能控制算法,实现了高速奔跑(最高时速达48 km/h)、复杂地形适应(如闭眼攀爬楼梯)以及动态平衡(如抗干扰稳定),推动了四足机器人从实验室向实际场景(如救援、军事巡检)的落地,其在 2019 年开源的 Mini Cheetah,其中的准直接驱动器的设计,更是影响了一波中国机器人企业的诞生与成长。

彼时 Sangbae Kim 组里有液压的人形和五个电驱机器狗,从硬件、结构到控制均为团队自研,研发成本奇高。因系统不够鲁棒容易损坏,上飞机需要安排货运,参加一次展会的成本大约是 3 万美元,团队往往只得放弃展示机会。

2015 年发布的 Cheetah 2

在Cheetah2项目里,赵行负责搭建感知系统,是唯一的华人成员。他曾向 Sangbae 力推深度学习,但当时深度学习在控制领域效果远不及模型预测控制(MPC),因此控制派学者并不认可,「做传统控制的老师们都非常厉害且坚信自己的道路,所以几乎都看不上没有数学保证的深度学习。」

后一年,赵行开始接触自动驾驶,参与John Leonard教授发起的 Duckietown 项目,开发自动驾驶的研究和教学平台,团队有来自不同实验室的十几人,包括两名博士生、博士后和老师,开设课程教授学生自驾系统各模块的知识。

项目链接:https://hangzhaomit.github.io/papers/duckietown.pdf

具体来说,他们自己搭建一个微缩版的城市交通,并且自己设计低成本的轮式小车,装上传感器和计算单元,就实现了自动驾驶车的硬件系统。软件上,搭建一个 ROS 中间件,通过它定义自驾各模块的接口,如感知、建图、定位、导航、规划、控制、人机共驾、多机协同、车路协同等。之后,各模块的开发工作将分配给不同团队的成员,最后大家共享专业知识,共同构建一个多智能体的自动驾驶交通系统。

作为助教,赵行负责搭建整个平台,并参与深度学习感知模块。该课程后来作为机器人系统的实践课程,被全球 250 多个大学和 160 多个公司所采用。

而在多模态学习方面,赵行在Antonio的课题组提出了视觉-声音跨模态学习方法 Sound of Pixels,解决语音领域长久以来的“鸡尾酒问题”;和隔壁组的赵明民(现 UPenn 助理教授)合作提出视觉-WiFi 跨模态学习方法 RF-Pose,用WiFi实现人体姿态识别。两项工作都是多模态学习领域的典范,获得了 NBC、BBC、Science 等媒体的广泛报道。

2019 年赵行毕业时,他的求职目标很明确:自己擅长的视觉和多模态学习对自驾和机器人很有价值。而既然机器人行业未成形,那便进入最有价值、最硬核的自驾行业。

加上自驾车辆配备如毫米波雷达、激光雷达、相机、夜视仪等多种传感器,为多模态学习提供了广阔的应用空间,如果能去头部的 Waymo工作和学习, 将这些技术应用于自驾汽车,他就不再考虑其他机会。

当时的Waymo如日中天,众多顶尖人才齐聚于此。例如,坐在赵行身边的 PointNet 作者 Charles Qi,VoxelNet 的作者周寅,还有自驾领域最早开展模仿学习工作 ChauffeurNet 的作者 Mayank Bansal 等人。

在 Waymo 研究院,赵行主要聚焦两个方向。

一是多模态感知,涉及视觉、激光雷达、毫米波雷达和声音等多传感器数据融合;二是学习驱动的预测规划,主要建模车辆与环境的交互。

很快赵行便结识了自己的最强搭档高继扬,他早三个月加入 Waymo,其自驱力在公司内尤为突出:既能高效开发产品,又主动推进研究,几乎是一人担两职。

彼时谷歌组织架构高度扁平化,内部合作极为灵活,二人便联合 Google Research 的孙晨(高继扬学长,曾引荐其师从 Ram Nevatia),三人跨三组合作自驾轨迹预测的系列工作 VectorNet 和 TNT。

另一边,在赵行逐步深入自驾行业之际,董思远也在 2015 年来到 MIT 读博,先是加入了正从视觉向触觉传感转型的 Ted Adelson 小组,意外开启了触觉与机器人的研究,跟着师姐原文祯学习 GelSight 传感器的原理和制作。

博二时因组里经费紧张,Ted 建议董思远和其他老师多交流以实现联合培养。

恰好此时亚马逊要举办第二届机器人拣选挑战赛(Amazon Picking Challenge),由传统控制大牛 Alberto Rodriguez 带领的 MIT 队决定同普林斯顿大学宋舒然团队组成 MIT-普林斯顿联队参赛,因需设计一个基于触觉反馈的抓取平台,便提出同 Ted 合作。

董思远得以参与其中,逐渐转到 Alberto 小组,开始聚焦操作领域(Manipulation),通过将触觉信息融合至控制器与规划器,系统性提升机器人任务执行效能。

到了博四,董思远与 Ted 团队合作自己最具代表性的成果——触觉反馈夹爪的线缆操作研究,并获得机器人顶会 RSS 2020 最佳论文提名奖。

针对柔性物体难以物理建模的挑战——理论上具有无限自由度,无法像刚体用六维位姿描述——该研究创新性利用触觉反馈追踪线缆姿态,仅凭触觉感知即可实现从线缆一端到另一端的精准操控,突破了传统视觉方案对柔性物体建模的复杂度瓶颈。

论文链接:https://arxiv.org/pdf/1910.02860

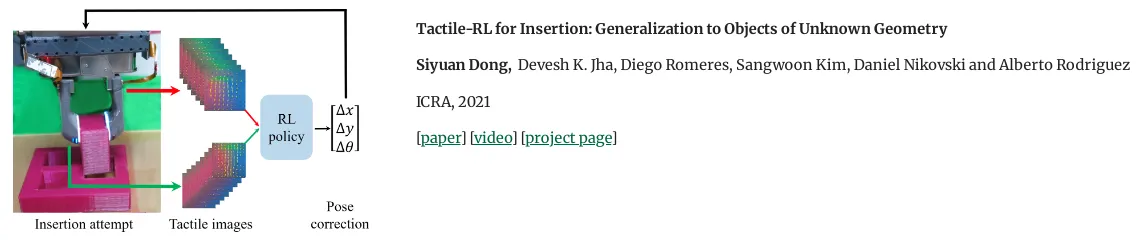

受深度学习浪潮影响,董思远开始探索其在机器人操作中的应用。但因两位导师都并非深度学习领域,尤其 Alberto 倾向基于模型的方法,所以在 MIT 的最后一年,董思远自行钻研机器人学习在插拔任务中的应用,开发了基于强化学习的高维触觉控制框架。

强化学习在处理高维传感器输入(如视觉触觉融合数据)的独特优势得以展现——通过深度网络构建端到端控制器,突破了基于牛顿力学的传统控制范式对低维抽象物理量的依赖,为高复杂度接触敏感型任务提供了数据驱动的解决方案。

论文链接:https://drive.google.com/file/d/15FSgNIV9BfjqL9Yekx0ui1kfzJb3NBSf/view

2020 年,想继续钻研 RL 的董思远来到华盛顿大学做博士后,与 Byron Boots 合作,研究将学习算法应用在四足狗上,使其在恶劣环境也能跑得更快,还帮助 Byron 带着学生做了不少机器人操作与触觉传感的探索。

2022 年 6 月,董思远回国加入华为的终端部门,先是在机器人和具身智能方向做了些探索,但他很快意识到,机器人离大规模商用仍十分遥远,就连最头部的特斯拉也仅是公布了 Optimus 的原型机。

一年后董思远所在部门面临重组,他便带着团队去了离具身智能机器人最近的自动驾驶部门,加入了华为车 BU,真正地走进自驾领域。

过去做科研时,董思远需独立搭建含控制器、规划器等从软到硬的整套系统,而更成熟的自驾领域则分工明确,仅需负责其中某模块;自驾重感知的模式也让其技术栈也得以更新,点亮了过去并非自己强项的感知算法。

最近,董思远又转向端到端框架,直接将传感器信号映射为规划指令,绕过模块分工实现「感知-控制闭环」,回归自己感兴趣及擅长的领域,把机器人学习算法运用在自驾领域。

在他看来,机器人与自驾在技术底层已高度趋同——当端到端架构兴起后,车辆本质上已成为具身智能在物理世界的延伸载体,二者的核心逻辑都是通过海量示范数据训练控制器,使系统能模仿人类行为:自驾追求「类人化」的安全决策,机器人则需完成叠衣、烹饪等家庭场景任务。

差异仅在于任务复杂度,自驾面对的是规则化道路环境,而具身智能需应对开放动态空间中的精细操作,这对硬件与数据提出了更苛刻的要求。

自驾之所以率先商业化,源于数据获取门槛低和硬件生态成熟的两大优势。反观机器人,操作任务的示范数据采集极其困难,需依赖高成本遥操作或雇佣专人生成数据,且硬件层面仍缺乏能精准复现人手灵活性的执行器,更难以说服消费者为高溢价却低实用性的家用机器人买单。

「虽然具身智能创业热潮涌动,但核心缺失在于涉及更复杂的物理交互与价值闭环的操作能力,唯有攻克,机器人才能真正创造人类可感知的应用价值,这也是具身智能商业化落地的必经之路。」

尽管决定继续扎根自驾领域,董思远却不认为自己离开了具身智能,「我反而觉得当前用海量数据去做学习训练的经历是非常宝贵的,这远比实验室小规模仿真更具工程价值,而且对于未来如果再做操作等具身智能任务,也非常有借鉴意义。」

与董思远相向而行,赵行则是从自动驾驶转向机器人。

在 Waymo 的一年多后,赵行在 2020 年回国加入清华任教。因意识到深度学习使各领域边界持续消融,他创立 MARS 实验室,希望不局限于单一研究方向,而做更广泛的 AI研究,包括多模态学习、自动驾驶和机器人。

刚回国后,赵行与刚上任理想汽车算法负责人的浙大师弟王轶伦讨论起自驾的技术进展,基于共同兴趣开展了视觉感知和无图自动驾驶的研究,后来发展为了与理想的正式合作。

到了 2023 年,之前在Waymo的合作者高继扬这时候找到他聊起创业,他们感觉到具身智能领域的创业时机成熟,一切恰如 2016 年自驾的起步阶段,并于年中正式成立星海图智能。

二人再次成为搭档合作尤其顺畅,最初计划开发轮式机器人,但在许华哲加入后,经过深入探讨,决定以仿人形双臂轮式机器人作为首款产品,最终确定了产品形态。(许华哲加入星海图的故事详情在伯克利具身智能图谱:深度强化学习浪尖上的中国 90 后们)

「自驾和 AR/VR 是我毕业时最火的俩方向,两者技术都有难度但自驾因社会意义大,尽管过去十年一直在烧钱,一直有社会各界的支持。」赵行认为做技术须兼具前沿性与社会价值,「相信具身智能机器人同样是各方会持续投入人力和财力推动发展的行业。」

看似殊途的赵行和董思远,或许会在未来再次同行。

GelSight 的演进

在董思远加入 Ted Adelson 组读博的 2015 年,团队已从 CV 向视触觉转型,专攻 GelSight 的视触觉研究和机器人应用的发展。

长久以来,触觉感知总被视为具身智能操作(Manipulation)的「最后一公里」,让机器人在黑暗中也能「看见」物体的形状、硬度与纹理,如同人类指尖在闭目时描绘世界的轮廓。

作为前沿中的前沿,触觉感知的技术路线自然未收敛,但在一众方案中,近年来受到最广泛关注和认可的触觉传感器 GelSight 正是诞生于 Ted Adelson 团队。

从聚焦视觉观测的传感器到结合上机器人触觉感知的「完全体」,GelSight 的演进离不开两个关键人物:李瑞和原文祯。

回到 2009 年,视觉认知和计算机视觉领域的泰斗、美国两院院士 Edward (Ted) Adelson 和其博后 Micah Kimo Johnson 在 CVPR 上首次提出 GelSight,其命名直指技术内核:通过有均匀反射涂层的透明凝胶材料形变捕捉信息,再利用光学成像和光度立体算法还原出接触面的高精度三维形状。

最初的 GelSight 是个边长为 50 厘米的大盒子,跟机器人的触觉毫无关系,更多是用来做物体表面微观结构的检测,比如说表面的纹理和凸起等。

同年,在新加坡南洋理工大学毕业的李瑞来到 MIT 读博,从 2005 年起他就开始做机器人和计算机视觉方面的研究。

2011 年秋,想继续钻研自己感兴趣的机器人和 CV 领域的李瑞在一次和 Ted 的交谈中讨论起做机器人也能用的传感器,帮助机器人更好实现类人的手眼协同操作,二人想法一致,便转组加入了团队,成为其机器人方向的第一位毕业的 PhD。

2011 年,Ted 和 Kimo 二人在 SIGGRAPH 上展示了更强大的第二代 GelSight:通过优化凝胶材料与多角度照明设计,将空间分辨率提升至惊人的 2 微米,甚至能无惧物体表面的光学特性(如反光或透明材质)捕捉几何细节——此时的 GelSight 用上了单反相机、已具备手持设备的雏形,但仍和机器人触觉无关,离机器人实际应用仍有较大差距。Kimo 也于同年创立了 GelSight Inc.公司,将 GelSight 技术主要应用于缺陷检测领域,但也与机器人并无关系。

彼时机器人操作领域的工作多是与视觉的结合,李瑞十分认可第一性原理,认为机器人若要像人一样操作,触觉不可或缺,极为重要。结合 GelSight 自身形变等特性,在 CV 领域深耕多年的李瑞和 Ted 设想将其改造成机器人触觉传感器。

李瑞从人的触觉获取灵感:一是能感知如纹理、形状的物体本身性质;二是可获取接触状态、反映在人的手指形变里的信息。

「此前的触觉传感器其实更应该叫压力传感器,仅能获取很稀疏的法向力信息,而 GelSight 接触物体时会像手指一样发生形变,我要做的就是通过摄像头捕捉多维的实时的形变信息,再用 CV 方法反推出触觉信息。这样其中一大好处就是可以获得超高分辨率的多维触觉信息。」

项目牵扯到硬件、软件、算法等多方面的综合,起初李瑞和 Ted 对能否成功都没有十足把握,不过随着李瑞完成视触觉传感器 Fingertip GelSight 雏形,他们对此路线愈发坚定。2010-2015 年间,Ted 围绕该方向陆续招收 3 名博士生,其他方向鲜少招人。随着组内其他学生陆续毕业,资源自然向视触觉研究集中。

看看 Fingertip GelSight 的研发过程。

2011 年,GelSight 已有的几个原型设备体积大、质量重、运行缓慢,用在机器人上既不实用也不合适,因此无论是电路、光路还是系统集成,都需要重新设计。

若仅算重大改动,主导项目的李瑞至少完成了二三十次版本迭代:为了兼顾满足性能需求、成本低廉、反应快速与尺寸小巧,测试了 40 多种摄像头;光路设计也历经多次迭代,涉及诸多光源、弹性体、支撑板、导光板的选型等细节调整;软件和算法上也要做到非常实时和精准。

这些组件组合方式繁多,难以确定最佳方案,甚至不确定能否正常运行,探索空间极大。他要在有限时间内,研发出性能适配的传感器及算法。

李瑞还跟 Ted 讨论过是否将其更名为「GelFinger」以跟之前的 GelSight 作区分,最后师徒二人还是决定沿用原名,但加了个前缀「Fingertip」。

在 CVPR 2013 上,李瑞发布了包含 40 种触觉纹理的数据库,使传感器能够通过接触识别多种不同的布料、砂纸、木材等材质。

2014 年,在机器人领域顶会 IROS 上,GelSight 迎来了历史性跨越,进化为现在大家所熟知的形态:李瑞与 Ted 推出全球首款超高分辨率的视触觉传感器 Fingertip GelSight(GelSight 指尖传感器,也称 GelSight 2014),其尺寸仅如人类指尖,是个边长约为 3 厘米的立方体。

论文链接:https://dspace.mit.edu/handle/1721.1/88136

这一设计让机器人实现类人手指精细操作,如插拔 USB 接口、自适应抓取等。大部分人类操作需手眼同时参与,即「手眼协同」,这对机器人实现类人通用操作同样关键。借助视觉-触觉闭环控制,机器人模仿人类「手眼协同」作业逻辑,完成精细操作:视觉粗定位与引导,触觉精细化闭环控制,二者相辅相成,缺一不可。

李瑞展示的机器人插拔 USB 的操作,使用的是早期重复定位精度只是毫米级的协作机器人 Baxter,但通过 Fingertip GelSight 实现亚豪米级的精准闭环操作,还展示了自适应抓取鸡蛋、薯片、树叶等脆弱或柔性物体,机器人可依据多维力反馈动态调整动作,而无须事先设定好每个物体力的大小,实现类人的通用自适应抓取能力,大大提升了机器人操作的能力上限。GelSight Inc.公司于 2022 年所推出的 GelSight Mini 传感器,正是在这版设计上改进而成。

除了传感器自身的软硬件和算法升级外,GelSight 技术在机器人触觉感知的应用也在不断突破,为此从无到有搭建起体系并奠定了关键基础的人,除了李瑞,还有晚一年进组的原文祯。

原文祯本科就读于清华机械工程系,在张文增指导下参与灵巧手和器械结构设计项目,负责用视觉做手势识别来控制灵巧手,参与过大量编程算法相关的软件工作。她发现,打造出色的机器人离不开智能软件与硬件的协同,希望找到二者最佳的结合方式,以此制造智能机器人。

因此,2012 年来到 MIT 后,对感知领域产生了浓厚兴趣的原文祯主动和多位研究人类认知科学与机械认知科学融合的教授交流,其中便有 Ted。

Ted 称自己已从视觉研究转向触觉,并向她展示了 GelSight,说打算做机器人触觉传感器,这与她想融合硬件与感知的想法不谋而合,遂决定加入团队。

作为一名机械系学生,原文祯进组后受到了不小的冲击。

GelSight 的核心硬件是带涂层的透明软胶,涉及化学流程,要亲自准备材料、做模具、融合材料,表面喷涂难度极大。

Ted 把原文祯带到实验室,指着一堆瓶瓶罐罐,让她抄录,说是要做软胶触膜的喷涂。身旁 GelSight 方向的大师姐贾晓丹一边教一边说自己即将离开,之后这屋子和全组的软胶研发制作就由她继承了。看着满屋子化学器材,原文祯直接懵了,「本来想多写写代码,结果却先来搞化学了。」

在专注硬件开发之外,原文祯开展了 GelSight 力学建模研究,试图从根本上理解测量信号的本质。

原文祯以传统机械工程思维开启研究,聚焦机器人触觉的核心问题——接触力测量。面对复杂力学建模的挑战,她通过大量实测建立基础理论框架时,开创性地在物体表面配置黑色标记点,意外发现这些标记点的信号变化与抓取滑动(Slip)高度关联。

在与副导师、触觉先驱 Mandayam Srinivasan 的深度探讨中,她敏锐捕捉到解决「物体滑落」这一抓取难题的关键:将 GelSight 传感器的高维信号优势(精度较传统触觉设备提升两个数量级)与几何学结合,耗时两年最终构建出基于标记点的滑动检测模型,并发表于 ICRA 2015,师兄李瑞也参与其中。

检测抓取失败、物体滑落是机器人触觉领域的第一重要课题。此工作加上 2017 年同董思远的合作,系统性地研究、论证了全新的基于触觉检测机器人抓取后物体滑落的方法——比起传统方法更普适、更稳定,能真正地应用于机器人上。

论文链接:https://ieeexplore.ieee.org/abstract/document/7139016

此时正值机器人触觉领域低谷,受限于传感器硬件、机器人算法及传统传感器价格稳定性问题,行业认为触觉应用天花板已至且实用价值有限,原文祯所发的文章也曾只有个位数的引用量、在会议上无人问津,甚至一度成为实验室唯一的学生。

对未来感到迷茫的她通过跨领域的交流与反思,认识到关键在于「感知(Perception)」本身,要向整个机器人领域证明,高精度触觉传感器本身如何将物理本质和认知结构结合起来,实现从未有过的认知能力——这种新式传感器能否催生新的感知范式?

她将目光投向硬度检测这一传统难题:传统传感器和纯视觉方案均无法有效解决,是因为物体软硬度必须通过接触才能感知。

而基于对 GelSight 信号的物理直觉,她设计系列实验验证猜想,成功实现复杂工况下的硬度检测(接触受力未知、物体形状随机且存在干扰力),并衍生出对布料/衣服等复杂可形变物体的感知工作。

这项探索分两阶段推进:她先尝试描述物理现象并进行小规模测试,在化学实验室手工制作不同硬度硅胶球后,通过分析 GelSight 接触信号,采用手动提取特征方法,构建出能很好描述信号的低维物理模型,这篇发表于 IROS 2016 的研究虽仅适用标准球体,但验证了理论可行性。

彼时 Ted 的办公点仍在视觉图形组,同 William Freeman 和 Antonio Torralba 为邻,正赶上深度学习在计算机视觉领域跨越式发展的时刻,原文祯便常和周博磊(UCLA AP)、吴佳俊(斯坦福 AP)、薛天帆(港中文 AP)等做视觉、图像的同学交流,学习最新的视觉领域进展,从中获得灵感。

为了实现广泛应用、测试任意物体的硬度,她与 William 组的 Andrew Owens 合作,将物理洞察与卷积神经网络结合——前者确保模型具备可解释性,后者利用 CNN 和 RNN 处理高维信号的优势,最终实现对任意形状物体的通用硬度检测,并发表于 ICRA 2017。这项研究也让原文祯成为了最早融合触觉与深度学习的学者之一。

论文链接:https://arxiv.org/pdf/1704.03955

之后,原文祯积极探索其他将深度学习和高精度触觉结合起来以增强触觉感知的方式,比如以不同形式将触觉和视觉结合在一起,使用深度学习,来获取对布料、衣服的深入感知。

在 ICRA 2018 的工作中,她展示了机器人通过视觉定位主动抓取衣物,结合动态触觉与深度学习,不仅能识别纹理,还能推断厚度、蓬松度、光滑度等物理属性,以及适用季节、洗涤方式等智能理解信息,初步实现了 Ted「做一个机器人在家里给衣服分类洗涤」的愿景。

「最早我认为做好机器人,要靠精妙的机械结构和用于感知和控制的优秀算法,但事实证明机器人前沿发展的推动力,也依赖材料科学以及先进的制造技术。」原文祯感叹,「机器人是一门综合性很强的学科。」

对 GelSight 作出重要贡献的二人至今仍在用不同方式探索着视触觉领域,李瑞选择了创业,原文祯则留在了学术界。

李瑞一直有着通用机器人的梦想,博士毕业论文里开篇提到的场景就是未来的机器人可以在家里和工厂里帮人类做各种各样的事,而视触觉传感器和手眼协同便是其中重要的一环。

2015 年李瑞博士毕业时,Ted 问他要不要拿 GelSight 去创业,但他觉得时机未成熟,选择在硅谷创立了无人配送小车公司 Robby Technologies,进军更成熟的自驾领域,研发了纯视觉和无需依赖高精地图的技术,与特斯拉的技术路径不谋而合,项目也入选了硅谷创业加速器Y Combinator(YC),并得到了 OpenAI 董事等的投资。

直到去年 1 月,一直密切关注视触觉领域发展的李瑞认为机器人创业时机已到,便在国内成立了纬钛科技,以通用机器人为目标,计划根据核心视触觉传感器、视触觉灵巧手、整机的渐进式路径研发,近 20 年跨领域的积累得以充分发挥,离其在博士论文中对通用机器人的愿景更近了一步,「做真正心灵手巧的机器人。」

原文祯则在斯坦福做了一年博士后之后,在 2019 年入职了 CMU RI,先是带学生做出了难度极大的触觉传感器仿真器。她们同步推进基于学习的方法和物理建模的方法 ,都取得了很好的效果,后续还把它与机器人仿真结合,实现了仿真到现实的迁移。

来到 UIUC 任教后,原文祯还针对触觉传感器硬件差异导致数据异构的难题,提出基于深度学习的跨硬件统一表征网络,通过仿真器生成万级异构传感器数据集训练编码器,实现跨硬件触觉信息的标准化表达,为触觉大模型奠定数据基础。

上月,她也因在机器人触觉领域的突出成就和宋舒然、朱玉可与刘畅流等学者一同获得了 IEEE RAS 2025 的早期学术生涯奖。从毕业时只有少数头部院校发教职 offer 到 GelSight 成为当下最广泛流行的触觉传感技术,原文祯感叹,「这也算是当年的坚持受到了时代的肯定了。」

Learning「登堂入室」

MIT 的机器人研究曾长期由传统方法主导——基于刚体动力学与精密控制,波士顿动力创始人 Marc Raibert 的早期工作(如动态平衡单足机器人)便是典范,加上 Russ Tedrake、Alberto Rodriguez 等大牛坐镇,在学习方法展示出其能力前,自是没必要颠覆过去的深厚积累。

但随着环境复杂度提升,学习范式崛起之风也逐渐吹向了 MIT,这从 Alberto 和 Russ 二位的学生的研究便可窥得一二。

Alberto 曾师从操作泰斗 Mathew Mason,属于传统机器人学一派,在 MIT 机械系带领着操作与机械实验室(MCube),研究自主灵巧操作和机器人自动化,在 2023 年到波士顿动力领导机器人操作后,依旧同 MCube 合作紧密。

2015 至 2017 年,亚马逊连续举办了三届机器人挑战赛(APC),旨在推动仓储自动化中机器人无序分拣技术的突破,赛事瞄准机器人操作领域的「圣杯问题」——Bin Picking(从杂乱箱体中抓取物体)。

Alberto 所带领的 MIT 队连续参与了三届且均稳居前三,其中组里的学生俞冠廷(Peter Yu) 作为「三朝元老」与技术架构总负责人自然功不可没。

赴美前,俞冠廷先后在台湾交通大学和台湾国立大学读完了计算机本科和硕士,并于 2013 年到 MIT 机械工程系读博,师从精通灵巧操作的 Alberto Rodriguez 和擅长视觉导航的 John Leonard。

加入 MIT 的俞冠廷显然是个比赛型人才。

2013 年,资助过十年无人车比赛的美国国防部高级研究计划局(DARPA)转而举办人形机器人挑战赛,博一的俞冠廷加入 MIT 队,也积极参与其中。

比赛赛程十分紧张:8 个月内准备虚拟机器人挑战赛,暑假过后收到 Atlas 机器人,又要在短短 4 个月内凭借真机再度参赛。MIT 队从零开发了大量系统组件,比如兼容优化的运动学和动力学引擎、完整用户界面,还集成了现有复杂软件,其中俞冠廷主要负责研究感知问题。

2015 年再次参与 DARPA 机器人挑战赛的同时,俞冠廷也开始参与亚马逊机器人挑战赛,担任感知和软件负责人。

比赛场景设定在一个类似自动化仓储的仓库中,机器人有 20 分钟的时间从货架上拣选物品,并将其放入塑料托盘中。货架上的 12 个货箱里存放着 25 种产品,每个货箱都有一个目标物品。机器人若成功拣选到目标物品,可获得 10 分的基础分,若货箱杂乱或物品难以处理,还能获得额外加分;若拣选了错误的物品、损坏或掉落物品,则会被扣分。

在 26 支队伍中,MIT 最终以拣选 7 件物品、获得 88 分的成绩位居第二。不过在首届赛事中,他们仍采用传统感知-规划-执行架构,重点解决物体识别、抓取规划和轨迹计算问题,通过集成有限的传感器反馈(视觉、压力)实现部分任务级验证,但尚未达到完全的实时闭环控制。

因此在第二年他们决定和 Ted 组合作加上触觉反馈以直接确认抓取状态,同时还和普林斯顿组成联队一起参赛。

最终 MIT-普林斯顿队获得 Stowing Task(装载任务)第三名、挑拣任务的第四名,并提出一种基于多视角 RGB-D 数据的自监督深度学习方法,通过全卷积神经网络分割场景并匹配 3D 模型,无需手动标注即可生成训练数据,实现复杂场景下 6D 物体姿态的可靠估计。

论文链接:https://arxiv.org/pdf/1609.09475

第三年,MIT-普林斯顿队再得装载任务冠军与 ICRA 2018 最佳系统论文奖。

值得一提的是,团队所设计的机器人抓取-识别系统核心突破在于实现了对未知物体的零样本操作能力。

该系统包含多可供性抓取框架与跨域图像匹配框架,前者基于全卷积网络,无需物体分割和分类就能规划抓取动作;后者利用双流卷积网络,无需额外训练即可识别新物体——在比赛中以 100% 成功率完成仓储任务,成为赛事史上首个在限定时间内精确处理所有已知与未知物体的解决方案。

论文链接:https://arxiv.org/pdf/1710.01330

2018 年 6 月,俞冠廷在博士毕业后,和同年毕业于 CMU 的好友周佳骥一起,在波士顿创立星猿哲(XYZ Robotics),为物流及工业自动化提供更好更快的机器人解决方案,成为最早一批机器人创业者。(周佳骥与CMU的故事详情请看:CMU 具身智能风云榜:从传统到全面)

深度学习对机器人领域的影响更剧烈地发生在了 Russ Tedrake 的小组里。

2017 年,李昀烛从北大计算机系毕业来到 MIT 读博,科研方向正从 CV 向深度强化学习拓展。想做智能体与环境交互研究的他自然想到了机器人技术同 CV 的结合,而 Russ 和 Antonio Torralba(也是赵行导师)正好也想共同指导学生,三人就匹配成功了。

Russ 侧重基于物理的模型及模型优化,Antonio 关注计算机视觉、深度学习和生成模型,双方的应用领域和方法大相径庭,让李昀烛在博士阶段初期协调起来颇为吃力,需在不同思路间周旋。但另一方面,这也是难得的成长契机,他得以同时接触机器人和计算机视觉两个领域的前沿成果和视角。

一开始,李昀烛启动了视触觉研究,探索视觉与触觉之间的相互预测,侧重多模态交互。朱俊彦(现 CMU AP)在加入 Antonio 组担任博士后后也参与其中,协助李昀烛在模型训练、调试与设计等方面,推动项目顺利开展并完成。随后,两人又与 Wojciech Matusik 的团队合作,开展触觉手套项目,李昀烛主要负责模型与学习相关部分。

为投稿《自然》杂志,他们解答了为何选择研发触觉手套而非其他形式的触觉传感器:手是人体与环境交互的核心部位,触觉手套不仅能实现技术突破、捕捉多模态交互信息,还能推动人类手部行为的科学研究,进一步启发机器人领域的发展。

投稿后不久,评审就给出了非常详尽的反馈。「这是我收到过最高质量的审稿意见,没有之一,」李昀烛感叹道。意见中提出了许多他们在投稿前已考虑到和尚未想到的问题。看到论文有望被接受,几位作者多次召开长达四小时的会议,深入头脑风暴如何恰当回应评审意见。最终,该工作成功发表在 2019 年的《自然》杂志上。

被展示在 MIT 博物馆中的触觉手套

论文链接:https://www.nature.com/articles/s41586-019-1234-z

此后,李昀烛持续深入触觉研究领域,与 Wojciech 团队的罗亦悦(现华盛顿大学 AP)合作,研发用于多模态大数据采集的触觉织物与触觉地毯,并推进柔性、可扩展的触觉传感器设计。与 GelSight 的实现方法不同,他们希望通过超薄且可扩展的结构,使传感器能够适应人手、机械手的抓握部位及机器人皮肤等多种复杂表面。

触觉以外,李昀烛更重要的研究主线是如今的热点——彼时被称为「Intuitive Physics(直觉物理)」的世界模型(World Models)。

这一研究起源于李昀烛与 Russ 关于建模方法的深入讨论:我们究竟应采用基于物理的建模与优化,还是应从数据中学习动力学模型?在具身智能交互中,每个系统都涉及机器人状态与环境状态的协同演化。相较而言,获取机器人的状态较为容易,因为其传感器系统可由设计者主动配置;而环境状态及其动态变化则更难观测与建模。人类对环境的物理理解正是通过与环境长期交互中逐步学习获得的。因此,李昀烛希望能够学习环境的动态模型,即所谓的“世界模型”——这一方向也正是他与两位导师共同关注的研究重点。

彼时 MIT 内吴佳俊和其导师 Joshua Tenenbaum 在该领域成果显著,李昀烛便向他们请教,恰好吴佳俊也对直觉物理在机器人领域的运用很感兴趣,双方便开始了长期合作,共同研究环境的动态模型与世界模型。

博一下学期,李昀烛与吴佳俊合作提出了动态粒子交互网络(DPI-Nets),以粒子作为环境表征,统一建模刚体、流体与可变形物体,并通过图神经网络学习粒子间的动力学关系。该研究发表于 ICLR 2019,为解决物理模拟与现实之间的偏差问题提供了新思路。DPI-Nets 能够将传感器数据转换为粒子表示,从而实现多种物体动力学的高效模拟与控制,支撑机器人在复杂环境中操控不同材质物体,完成多样化的操作任务。

论文链接:https://arxiv.org/pdf/1810.01566

作为一个复杂的系统工程项目,DPI-Nets 涵盖仿真和现实世界两部分,而那时的仿真技术的实现远不如现在成熟,很多须用 C++ 和 CUDA 编写。

为了将仿真与深度学习算法接起来,李昀烛还给英伟达的仿真器编写 C++ 包装层,使其内部 API 能与 Python 对接;并搭建仿真环境,在其中进行数据收集、模型学习、模型配置、控制规划;仿真环节后又再将整套流程迁移到现实机器人上。

对他而言,这是一次绝佳的锻炼:全程涉及图形学、基于物理的模拟、模型学习、基于机器人模型的优化与规划,以及模拟到现实的迁移,让他对机器人系统有了更深刻的理解。

当时,吴佳俊在模型设计和项目规划等方面提供了诸多建议,而 Russ 刚从人形机器人转向操作研究,实验室也刚开始搭建现实世界中的机器人操作系统,整体架构尚不成熟。通过这个项目,李昀烛不仅积累了大量实践经验,还系统性地认识到感知、学习、建模与 Sim2Real 等关键问题,研究视野由此显著拓展,选题也变得更加顺畅,其中不少思路至今仍在延续。

李昀烛的一系列工作让 Russ 看到学习算法在环境建模中的潜力;组里 Peter Florence 和 Lucas Manuelli 的论文《视觉运动策略学习中的自监督对应关系》又让 Russ 相信学习还能进一步用于策略制定;最后在丰田研究院,Russ 同宋舒然(现斯坦福 AP)团队合作的基于扩散模型的机器人动作生成策略「Diffusion Policy」则让这位坚定的「Model-Based 信徒」真正转向了学习一派。

如今,李昀烛与 Russ 会在会议中偶然碰面,二人的讨论发生了有趣的变化:李昀烛向 Russ 提出应在学习系统中添加恰当结构以提升泛化性与样本效率;Russ 却主张构建机器人基础模型,像 VLA 模型和大型行为模型等,已然 all in 端到端的机器人基础模型研究。Russ 还感慨,自己都未曾料到会有如此转变 。

2021 年,李昀烛和许华哲、吴佳俊等人合作了 RoboCraft 项目:许华哲在吴佳俊组里做博士后,二人经讨论认为动力学模型学习(Dynamics Model Learning)是个不错的方向,想起李昀烛之前做的 DPI-Nets 也是相关工作,便提出了合作。

次年李昀烛毕业,来到斯坦福,在李飞飞和吴佳俊组里做博士后,顺着 RoboCraft 继续推进 RoboCook 工作,和史浩辰(斯坦福 PhD)合作,通过图神经网络和预测控制算法让机械臂学会操控各种软体材料,比如借助工具完成包饺子任务,最终获得了 CoRL 2023 的最佳系统论文奖。

论文链接:https://arxiv.org/abs/2306.14447

接着,李昀烛还和黄文龙、吴佳俊、李飞飞等人一起合作了 VoxPoser 项目。

一作黄文龙(斯坦福 PhD)曾在谷歌大脑参与 PaLM-E 项目,研究语言与机器人操作的融合问题。博士入学后,他在斯坦福与李昀烛等人展开深入讨论,认为尽管基础模型在高层次任务上表现出色,但在生成机器人动作等低层次控制上,仍需结合结构化框架以提升可靠性与可控性。

鉴于李昀烛之前在模型学习、基于模型的优化和规划方面有诸多经验,便建议将基础模型的高层次能力与低层次优化相结合,从而充分发挥两者优势,由此产生了 VoxPoser 的想法。

项目链接:https://voxposer.github.io/

VoxPoser 将大模型接入机器人,把复杂指令转化为具体行动规划,无需额外数据与训练;还结合大语言模型同视觉语言模型,在 3D 空间中分析目标及需绕过的障碍,以零样本的方式合成轨迹为机器人规划行动。

尽管仍处于实验室演示阶段,与实际商业应用尚有不小差距,该工作首次展示了机器人在更通用场景中,基于语言指令与视觉观测完成多种复杂操作任务的能力。论文发表在 CoRL 2023 后,迅速引发学术界、工业界及风投圈的广泛关注。此后几乎每周都有多位投资人主动联系作者团队,寻求进一步交流与合作。

离开斯坦福后,李昀烛先后在 UIUC 和哥伦比亚大学任职,带领学生持续推进世界模型(World Models)、多模态感知(Multi-Modal Perception)与基础模型应用(Foundation Models for Robotics)三大方向的研究,「核心目标是让机器人能像人一样,更加灵活通用地感知环境并与之交互。」

具身智能进行时

2019 年初,MIT 开始筹备成立一个虚拟组织——具身人工智能研究小组(Embodied AI Group,简称 EI 小组)。

「在 EI 小组成立前,具身智能并不是一个热词。」在李昀烛的回忆里,此前大家更关心基于模型的方法,小组成立后合作交流更紧密。

EI 小组把研究计算机视觉、图形学、机器人控制、机器人任务规划等方面的老师聚集到一起,既方便申请资金,又组织讲座等多种活动。

整个 EI 基本都在 Stata Center 的三楼,各个实验室的距离都在百米内,老师们有单独办公室,而不同实验室的学生则三两交叉、混杂分布在不同办公室里,以便更好地日常交流。

这年的录取结果公布后,收到 offer 的陈涛到 MIT 实地交流时,就已经了解到 EI 小组的不少安排:每学期会办约八场讲座,外部嘉宾和内部交流五五开,还设一对一交流和共进午餐等不同的机会;各大顶会前办研讨会,各组学生齐聚一堂互相分享讨论投稿论文。

陈涛本科在上海交通大学的机械工程与自动化系,大四开始自学编程、机器学习、慢慢接触 AI,毕业后先在人形机器人创企岭先机器人工作了一年,探索室内导航的 SLAM 系统搭建、强化学习上真机、物体检测等方向,把机器人系统所用的 AI 技术摸了个遍。

确定想研究用 AI 方法尤其是强化学习去控制机器人系统后,陈涛便决定出国深造,在 2017 年到 CMU 读研,师从 FAIR 机器人部门研究负责人、现 Skild AI 创始人 Abhinav Gupta,做了关于智能体无任务奖励下自主探索现实复杂 3D 环境的工作。

两年后,想拓展新圈子、跟随年轻老师的陈涛来到 MIT 读博,师从刚从伯克利毕业后到 MIT 任教的 Pulkit Agrawal,成为其首位博士生,二人共同感兴趣的方向。此前 MIT 的机器人探索更偏「硬核」,在传统控制和硬件研发上成果斐然,Pulkit 加入后,则新添了深度强化学习的色彩。

进组后,作为组里少数了解真机的成员,陈涛先是负责搭建真机平台及 Infra,用 Python 写 AI的控制软件及脱离 ROS、以少量代码实现机器人交互的库。

接着陈涛又做强化学习打视频游戏的研究,但因实验室计算资源有限,没能扩大规模;同时因 Pulkit 和 Sangbae Kim 的合作并行开启了对四足机器人的探索,研究用强化学习算法让四足机器人跳过沟壑,带着本科生写代码;还会协助 Pulkit 备课,他首次在 MIT 熬夜便是帮 Pulkit 准备编程作业。

博一接近尾声时,陈涛终于找到了自己最感兴趣的领域:机器人操作与灵巧手控制。

2019 年 10 月,OpenAI 发布的机器人转魔方工作引起轰动,陈涛因此也有了做灵巧手的想法,于是在完成手头的项目后,决定解决灵巧手中最难的控制问题,聚焦到把灵巧手做得更泛化(朝向任意方向),突破 OpenAI 灵巧手只能朝上的局限。

起初实验室没有灵巧手,陈涛便在仿真器上开始探索,用强化学习和模仿学习训练灵巧手控制器,并且展示了灵巧手在手面朝下此最极端的情况下也能转动任意形状的物体,而且还通过无模型框架重新定位了超 2000 个形状各异的物体,具有非常高的通用性。

他们还发现,当灵巧手控制器足够鲁棒时,即使不知道物体形状信息,也可以以高成功率转动任意物体到指定朝向。

论文链接:https://proceedings.mlr.press/v164/chen22a/chen22a.pdf

彼时灵巧手控制领域十分冷门,传统模型方法和遥操作方法各有难以逐一建模和数据不足的问题,用强化学习实现突破的 OpenAI 也裁撤了其机器人团队,直到陈涛用强化学习完成远超以往难度、众人未曾设想的灵巧手控制任务——此工作获得了 CoRL 2021 的最佳论文奖。

除了用强化学习训练模型使机器人学习有用信息外,团队还将原本需数月的训练时长缩短至两天内以提升效率,并将模型从依赖大量设备、成本高达几十万美金的 OpenAI 早期模式转变为仅用一个几百美金相机、一张 3090 显卡及一周左右即可完成训练,通过网络架构优化提出新框架,极大简化整机部署系统,提升数据采集效率 。

推进此工作时陈涛也意识到,仿真器中充足的质量、材质、摩擦系数等信息其实属于「作弊信息」,尽管做了大规模的理论验证说明它可以被迁移到真机上,但依旧难以在真机上部署,因此下一步得训练出在真实世界里能够部署的解决方案,便紧接着发表第二篇论文解决在真机上实现时遇到的问题,投在了期刊杂志《Science Robotics》上。

有了这个鲁棒的机器人控制器框架后,陈涛开展了大量应用工作,解决如灵巧手抓物重定向、削水果蔬菜等问题,还制作触觉传感器用于机器人在桌面或封闭空间精准定位目标物体。

2024 年博士毕业,一直对创业很热衷的陈涛拉上了上交大小两级的师弟秦誉哲,一起在加州成立了 Dexmate,主攻机器人的灵巧操作。

秦誉哲在 UCSD 读博,博导正是陈涛在 CMU 的学长王小龙,两人通过王小龙认识后发现经历十分相似,同样从机械系转到 AI,并专攻相对小众的灵巧手,因此思路非常契合。

目前,Dexmate 的产品已迭代至接近稳定的状态,即将进行小规模量产。区别于一般的人形机器人,他们选择「轮式底盘+双臂双手」的操作形态,但没有设计胸腔,而是让机器人既可以蜷缩、折叠,也能展开到两米多高。

「我们奉行实用主义,机器人要具备像人一样的操作能力,而不需形态上像人,灵巧手也不一定是五指结构。」

而在陈涛读博的最后一年,算得上是我国本土培养的首位具身智能博士方浩树也来到 Pulkit 组做博士后。

方浩树在 2013 年入读上海交大,是个在本科期间就崭露头角并敢于尝试的年轻人。他在大三参加本科生研究计划时跟随阎威武学习机器学习知识后终于找到感兴趣的研究方向,即神经网络和 CV;之后看到卢策吾的实习生招聘广告,因兴趣契合投递简历并通过面试,就在大三结束后休学,在不同的科技公司实习,也去了UCLA访问,同时一边跟着卢策吾做实验。

休学两年间,方浩树聚焦 CV 陆续以一作发表四篇顶会论文,又在 2019 年本科毕业时,拿到多个北美知名实验室的 PhD offer,不过,他最终选择直博到吴文俊人工智能博士班,继续留在卢策吾团队。(卢策吾的具身智能故事请看:3D 视觉派:斯坦福具身智能人物关系图)

过往的研究让方浩树对机器人越来越感兴趣,便决定从视觉切入,先做抓取,开启了基于二指夹爪的通用物体抓取工作 AnyGrasp,期间也提出了 GraspNet-1Billion 标准数据集。

耗时三年,方浩树和团队终于在 TRO 2022上发表了 AnyGrasp:它能高效生成准确、全自由度、密集且时间平滑的抓取姿态,面对较大深度传感噪声时运行稳健;清理装有 300 多个未知物体的箱子,成功率达 93.3%,与受控条件下的人类表现相当;单臂系统上处理速度超每小时 900 个物体;在动态抓取方面,还成功展示了水中捕获游动机器鱼的过程。

项目链接:https://graspnet.net/anygrasp.html

这是机器人首次在任意场景抓取任意物体时,表现出堪比人类的能力,既无需物体 CAD 模型和检测,对硬件构型、相机也无限制。 因此,AnyGrasp 被很多研究者当作抓取的通用模型使用。

除了抓取外,方浩树也在思考如何用新范式做机器人操作。

2021 年 GPT-3 问世后,他发现采用序列建模,若数据充足,可借鉴 GPT 思路进行机器人学习。研究 GPT 及此前模仿学习方向文章,他们注意到从 GPT-1 到 GPT-2 有重大思想转变:GPT-1 时语言模型各任务需分开训练,GPT-2 则将不同任务作为输入网络,使一个网络能同时处理不同任务,还引用了在机器人学习领域率先提出的单模型多任务的元学习(Meta Learning)论文,证明在大规模数据下多任务学习的可行性。

这让方浩树想用同样方法研究机器人学习。他还参考脑科学文章,发现人类处理语言和日常操作的脑区高度重合,主要负责序列建模,且考古学文章表明语言因操作需求而产生,用于传递操作经验,因此认为语言建模方式适用于机器人操作。

但当时更关键的是缺少合适的数据集,为此方浩树和团队花数年采集 RH20T 数据集,包含了超过 11 万机器人操作序列,提供了视觉、力、音频、运动轨迹、演示视频和自然语言指令等多种数据模态,发布后不久便收到了谷歌的邀请,成为大中华区最早参与 Open X-Embodiment 数据集的一支队伍。

项目链接:https://rh20t.github.io/

推进 RH20T 时,方浩树发现基于遥操的数据采集方式并非最适合扩大规模的方式,从 2021 年起便开始用外骨骼代替遥操作,开发了双臂外骨骼设备 AirExo,让人能穿着直接采集数据。

对硬件和灵巧操作的深入探索让方浩树意识到了触觉的重要性,便打算再读个博士后。恰好妹妹方晓霖在 MIT 读博,同样研究 AI 和机器人,她描述的MIT的研究风格深深吸引了方浩树。在跟董思远聊了之后,他认为视触觉大牛 Ted Adelson 组的研究与他之前的研究十分互补。

方浩树给 Ted 发邮件表达了自己对用于操作的触觉很感兴趣,Ted 十分高兴,但是称自己只做触觉不做操作,之后又联系上了在MIT主攻机器人操作方向的教授 Pulkit。就这样,方浩树在 2023 年末前往 MIT,在两位导师的指导下做博士后。

他先是作为共同一作负责学习算法的部分,在 IROS 2024 上发表了 EyeSight Hand,用模仿学习做灵巧操作,让配备了视触觉传感器的三指灵巧手能完成切橡皮泥、单手开盖等操作,这篇文章也获得IROS 2024 RoboCup最佳论文提名。随后,方浩树也开始探索硬件设计。

项目链接:https://eyesighthand.github.io/

目前,方浩树在 MIT 主要围绕着灵巧操作研究,既设计灵巧手、外骨骼硬件和传感器,也钻研新的数据采集方式和学习方法。 MIT的研究经历让他逐渐从一个 Learning 背景的研究者转变为对软件硬件都有深刻见解的学者。

「不少灵巧手的功能与二指夹爪类似,主要用于抓取,电机数量的增加却不能带来能力上的提升。」方浩树认为灵巧操作中仍存在许多待解决的科学问题,「市面上灵巧手虽多,但关于哪种手的结构、手指数量、自由度配置、触觉传感器的密度、灵敏度及排布方式更适合日常操作等问题均未得到妥善解答。」

结语

在 2019 年 EI 小组诞生前,MIT 就已经孕育了好几拨具身智能的探索者。

他们或从传感器出发,或先探索更成熟的自驾领域,或在传统控制方法上深深扎根。十年光阴,AI 和 Robotics 终于开始双向奔赴。

赵行和董思远最早从视觉出发,如今前者在清华叉院和星海图推进机器人研究,后者在华为车 BU 钻研自驾,以不同的路径探索着具身智能;

李瑞和原文祯让 GelSight 成为真正意义上的机器人视触觉传感器,现在一位创立纬钛科技从传感器开始做机器人,一位则在 UIUC 任教、探索触觉大模型;

俞冠廷和李昀烛亲历 Learning 深刻改变机器人领域,目前前者仍在用心经营星猿哲机器人,后者则在哥伦比亚大学任职推进世界模型与多模态感知。

而在 EI 小组成立后来到 MIT 的陈涛和方浩树则搭乘上最新的浪潮,无论是成立 Dexmate 研发机器人,还是作为博士后继续科研,都在攻克着灵巧操作这一核心难题。

「分层系统与端到端 VLA 并不矛盾,当前因端到端控制存在速度慢、闭环能力差等致命缺陷,可行方案是采用大模型规划 + 端到端执行的分层设计。」赵行认为,未来具身智能的研究方向是将端到端与大模型融合为一个系统,「强调结合动作模型与视觉语言模型以提升执行能力,这在自驾和机器人领域的思路都是一致的。」

MIT 的校训是拉丁语「Mens et Manus(Minds and Hands)」,译为「手脑并用」。巧合的是,具身智能同样追求「心灵手巧」。

这些 「传动轴」们的故事或许会成为新的启示:在 AI 与机器人的交叉地带,真正的「心灵手巧」从来不是某个天才的灵光一现,而是一群攻坚者们在齿轮咬合处的持续深耕——他们拧合的不仅是技术链条,更是让智能从「云端」落地「指尖」的时代齿轮。

地基夯实,大厦将起。