本文经AIGC Studio公众号授权转载,转载请联系出处。

单目视觉4D重建再突破!谷歌DeepMind等团队,推出了多视角视频扩散模型CAT4D,它支持输入单个视角的视频,转换后可以自行拖动。

该模型可以分别固定视角和时间,然后分别输出了视角不动(机位固定)时间变、时间不变视角动,以及视角时间均变动的效果。 如下图所示:

相关链接

• 论文:https://arxiv.org/pdf/2411.18613

• 主页:https://cat-4d.github.io/

论文介绍

CAT4D:使用多视图视频扩散模型以 4D 形式创建任何内容

工作原理

它是如何运作的

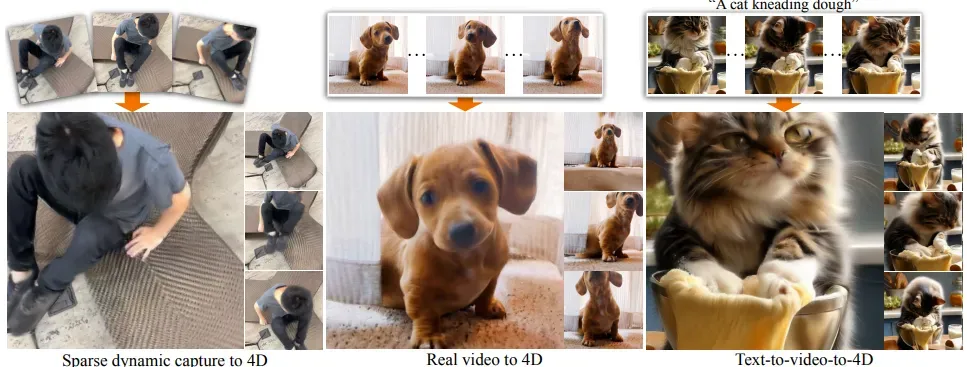

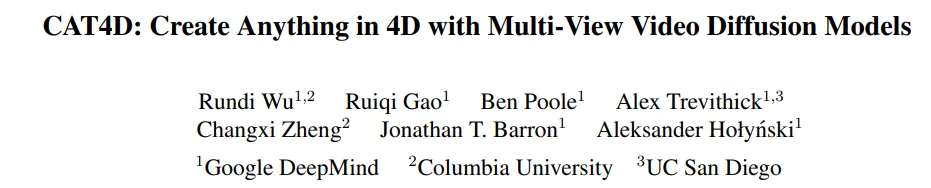

给定输入单目视频,我们使用多视图视频扩散模型生成新视点的多视图视频。然后,使用这些生成的视频将动态 3D 场景重建为变形 3D 高斯。

独立的摄像头和时间控制

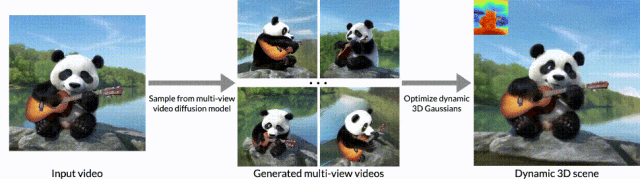

CAT4D 的核心是多视图视频扩散模型,它可以解开摄像机和场景运动的控制。我们通过给定 3 个输入图像(带有相机姿势)生成三种类型的输出序列来演示这一点:1)固定视点和变化时间,2)变化视点和固定时间,3)变化视点和变化时间。

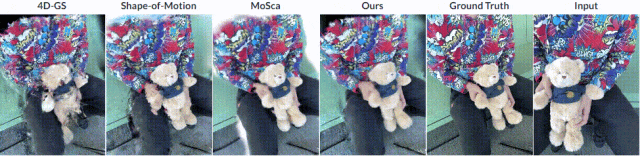

比较

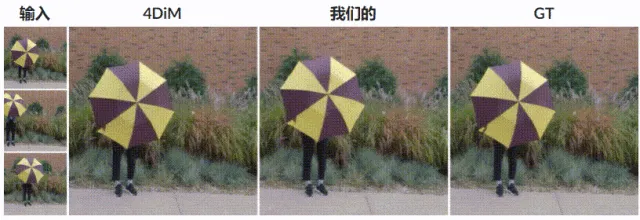

将我们的方法与不同任务的基线进行比较。尝试选择不同的任务和场景!

给定 3 个输入图像,我们生成三种类型的输出序列:

1. 固定视点和变化时间

2. 变化视点和固定时间

3. 变化视点和变化时间。

仅给定动态场景的一些姿势图像,我们就可以通过重建与一个输入视图的时间相对应的静态 3D 场景来创建“子弹时间”效果。三个输入图像显示在左侧,其中第一个是目标子弹时间帧。

DyCheck 数据集上单目视频动态场景重建的比较。