在今年 1 月,微软亚洲研究院(MSRA)视觉计算组的主任研究员胡瀚在做客机器之心「2021-2022 年度 AI 技术趋势洞察」的「模型专场」直播间时,为我们带来了主题为「面向统一的 AI 模型架构和学习方法」的学习分享。

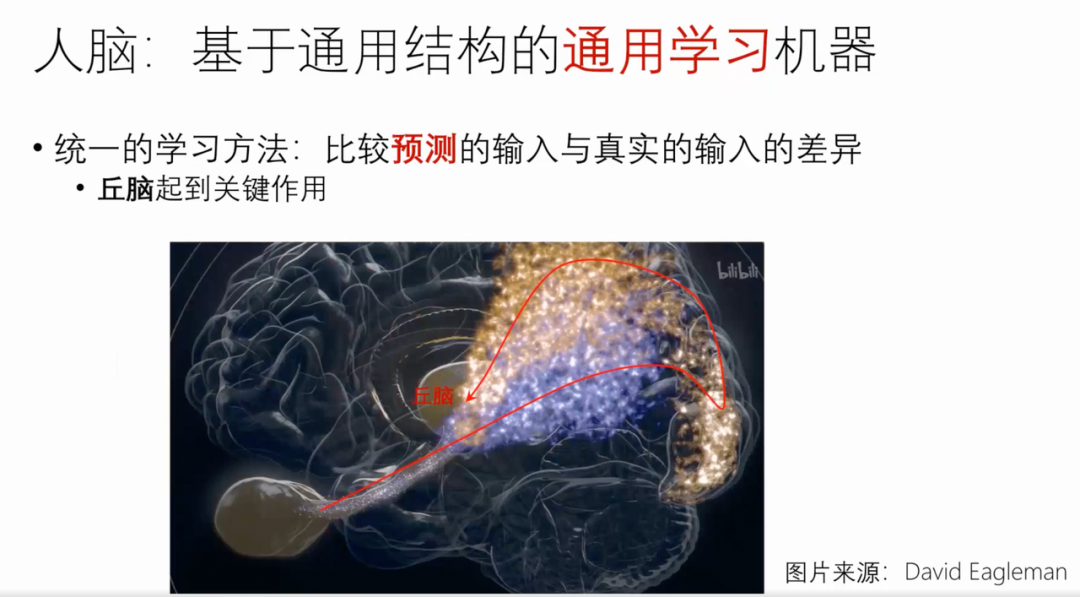

胡瀚博士首先为大家介绍了基于通用架构的通用学习机器---人脑。

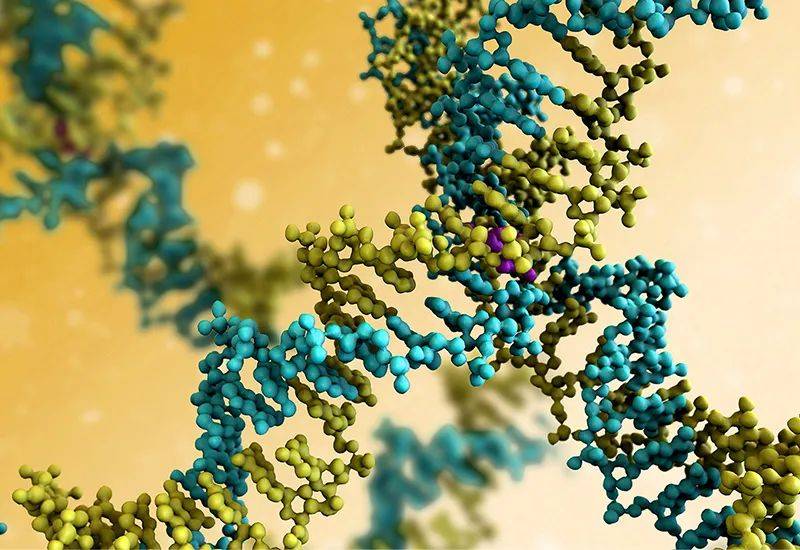

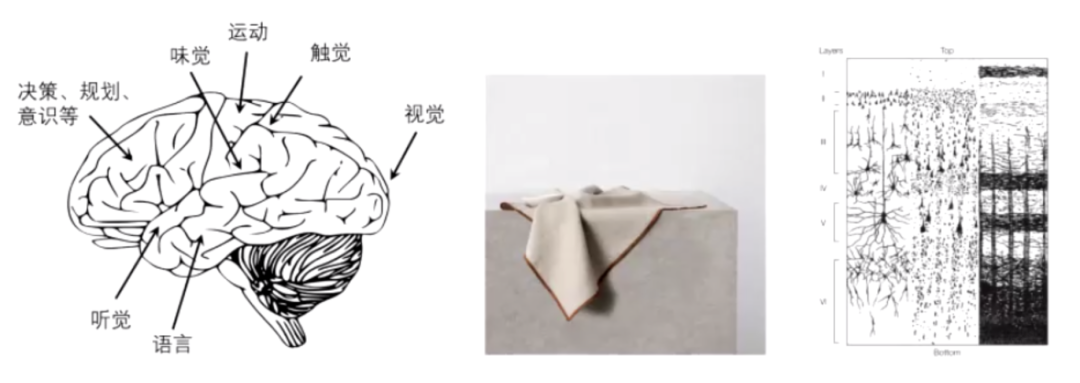

左图中比较褶皱的地方叫新皮质,这个部分占了整个人脑的 70% 左右,负责了大部分的人类的智能,包括视觉、触觉、听觉等等。尽管有很多不同的功能区,但是它的结构非常统一。如果我们将这些褶皱展开的话,它的形状就像一个餐巾布,长宽大概 40 到 50 厘米,厚2到3毫米。

最右边的图是通过三种染色方法得到的一个剖面图,它是一个很明显的六层结构。这样一个结构表明先前看起来很不一样的这些能力,它所用的结构几乎是一模一样的。反过来说,我们几乎所有的智能,都可以用这样的一种通用的结构来实现,即新皮质,而这其实也是人之所以能够成为万物之灵长的一个关键所在。

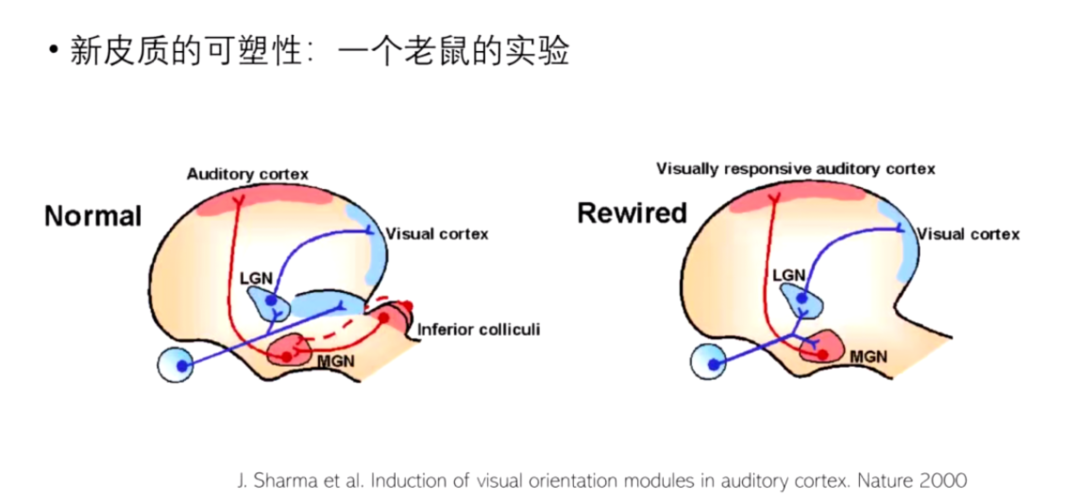

随后胡瀚博士分享了一个关于大脑新皮质的可塑性的一个实验。

该实验发表在 2000 年的《Nature》上,科学家在在老鼠出生的时候,把听觉的皮层的输入掐断,然后把视觉的输入粘到听觉皮层里面,然后发现一段时间以后,这个听觉皮层也能够对视觉产生响应。这个例子就表明我们的神经的皮质其实是很通用的。

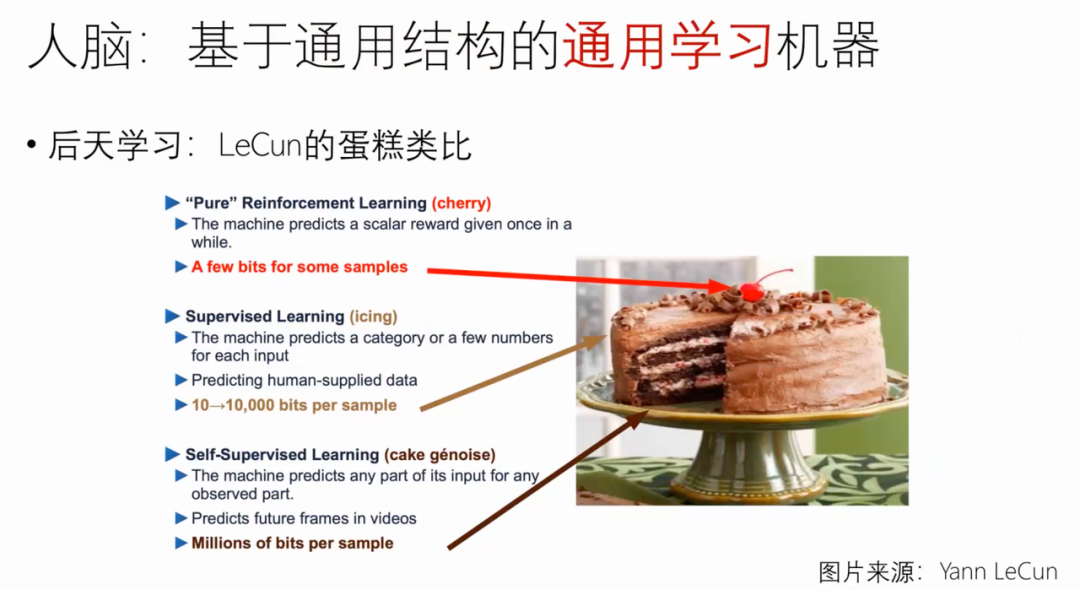

前面提到的是大脑的结构,是先天的,那么人脑又是如何进行后天学习的呢?胡瀚博士介绍了 LeCun 的蛋糕类比、婴儿在观察中的学习(自监督)、统一学习方法等等。

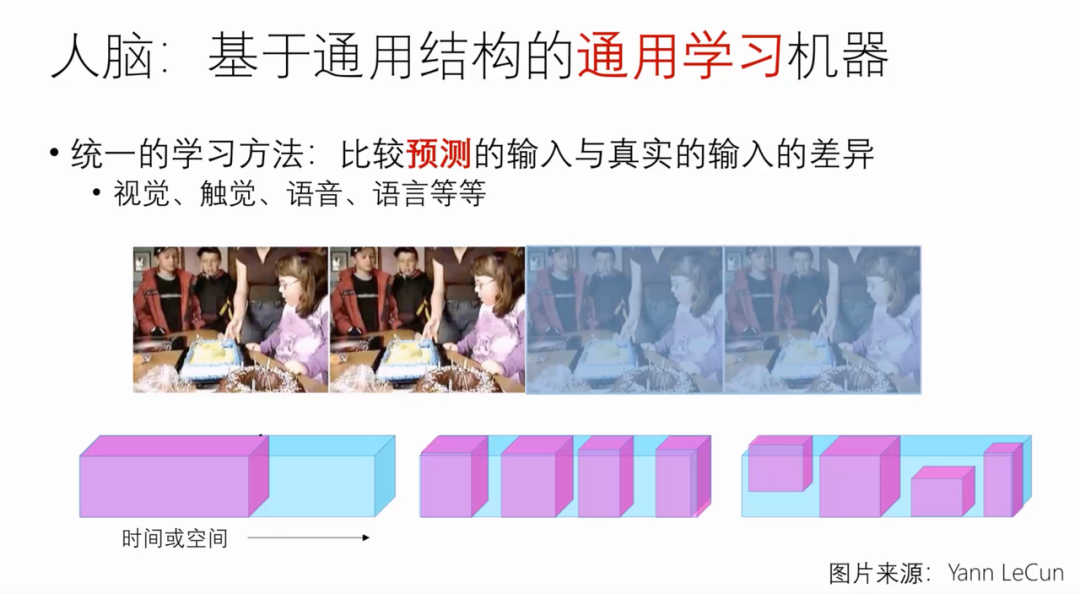

人脑的学习目前普遍认为其实是通过一种预测的方式。

具体人脑是如何实现的呢?目前还尚不清楚,但脑科学家们有一些推论,认为丘脑可能起到了关键作用。

人脑它是一个基于通用模型,通用学习方法的机器。我们相信未来的 AI 它也必然是一个统一的模型以及统一的学习方法。这里,胡瀚博士分别对 「迈向统一的 AI 模型架构」和 「迈向统一的 AI 学习方法」做了分享。

迈向统一的 AI 模型架构

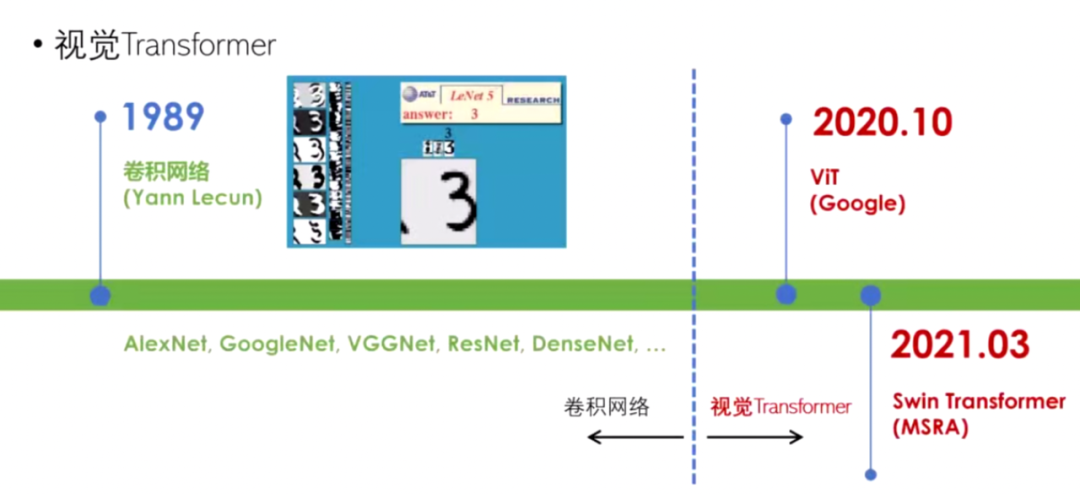

胡瀚博士首先介绍了卷积用于序列自然语言处理的方法 和 视觉方法。

其中 Transformer 是目前处于一个统治的地位,原因是其有强大的通用性。

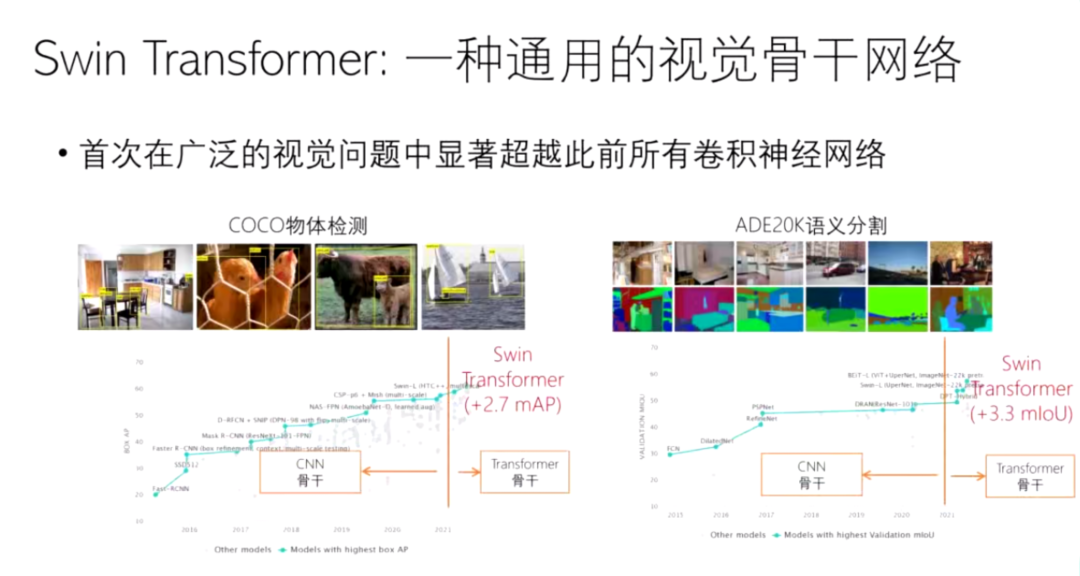

胡瀚博士着重介绍了由他们团队研发的 Swin Transformer,介绍了 Swin Transformer 的核心想法还有 Swin 的关键技术及创新:移位窗口方法等等。

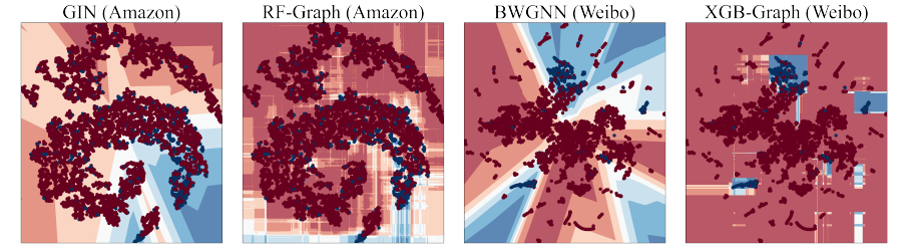

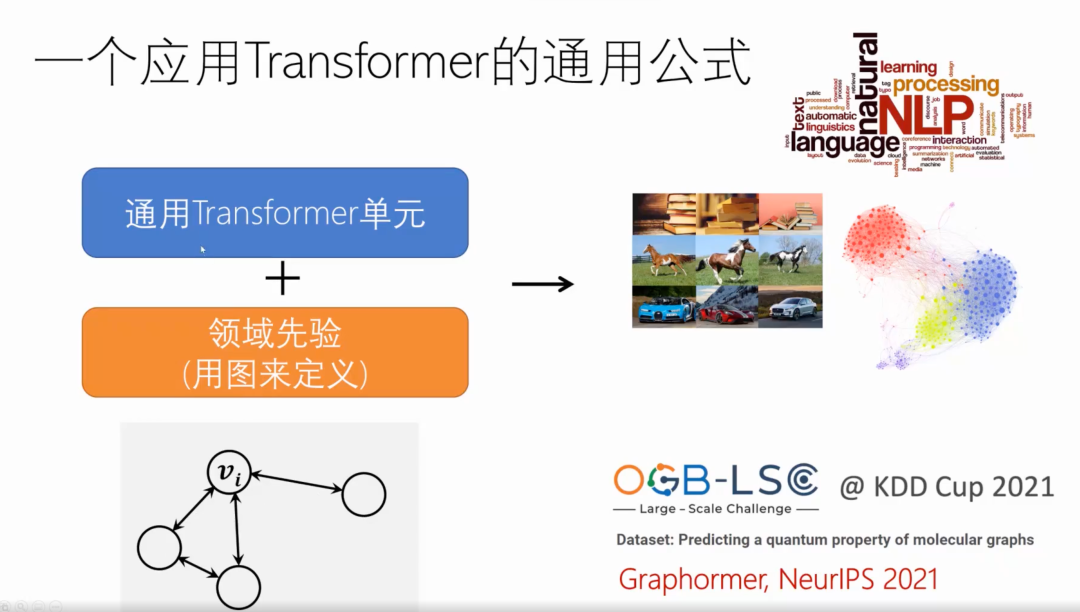

基于下图中这样的一个设计范式,可以用来处理 NLP 和 CV 以及广泛的一些问题。

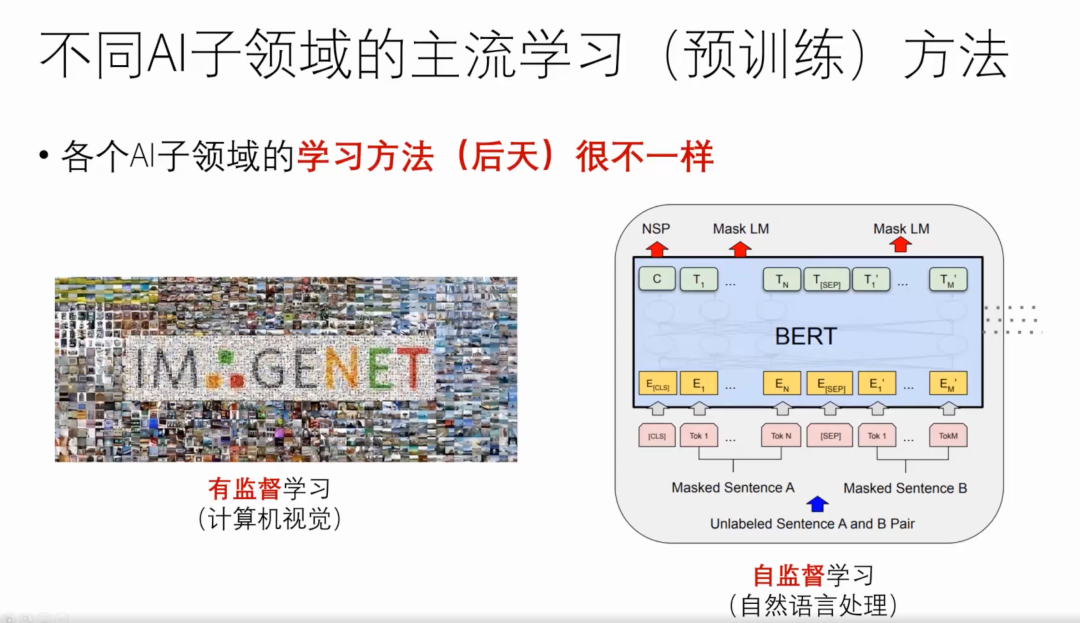

迈向统一的 AI 学习方法

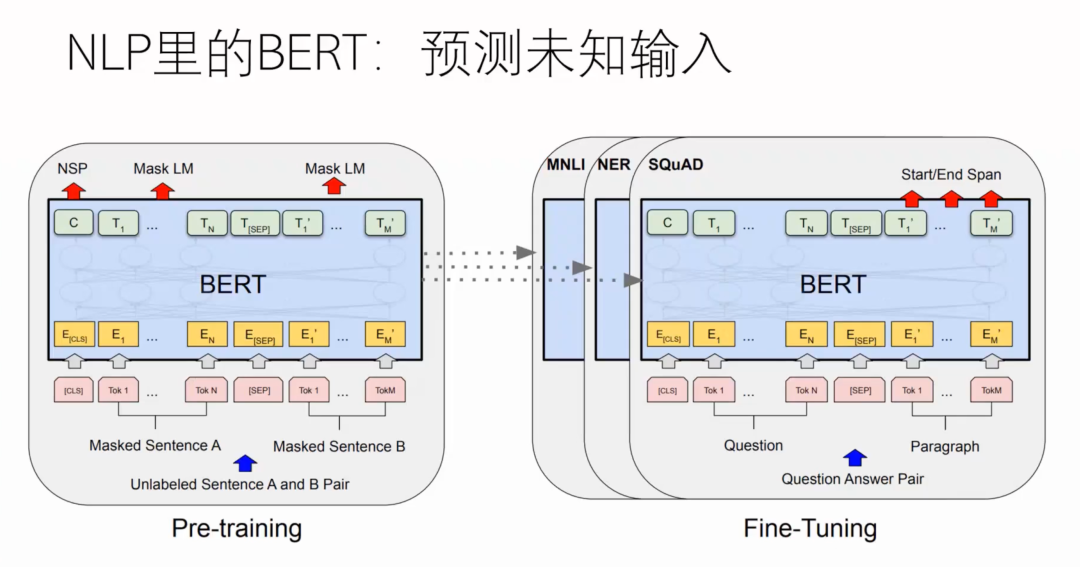

NLP 领域中的学习方法,如 BERT -- 掩码信号预测。

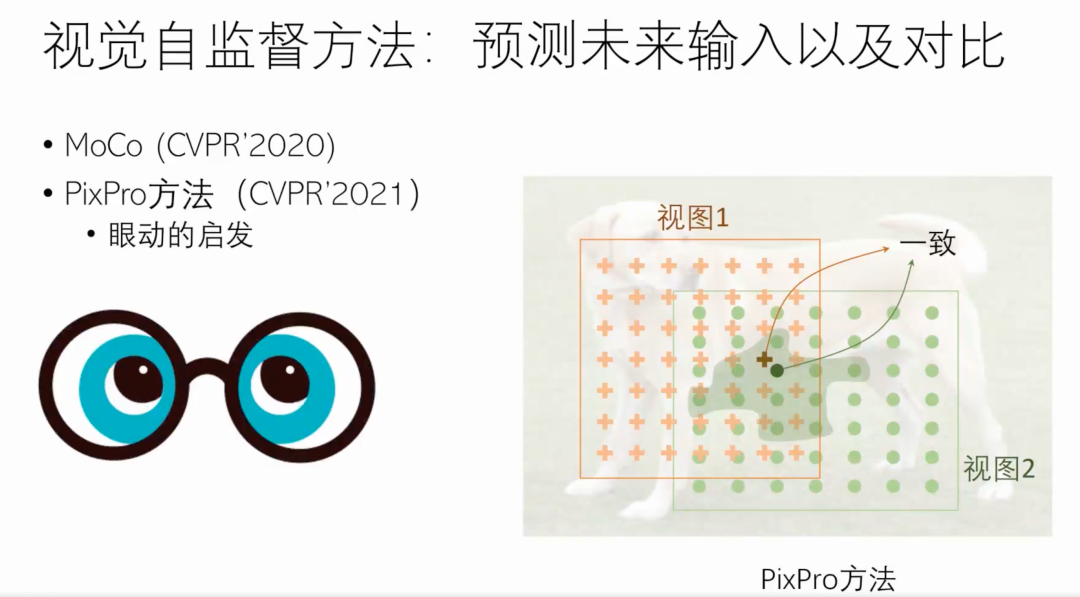

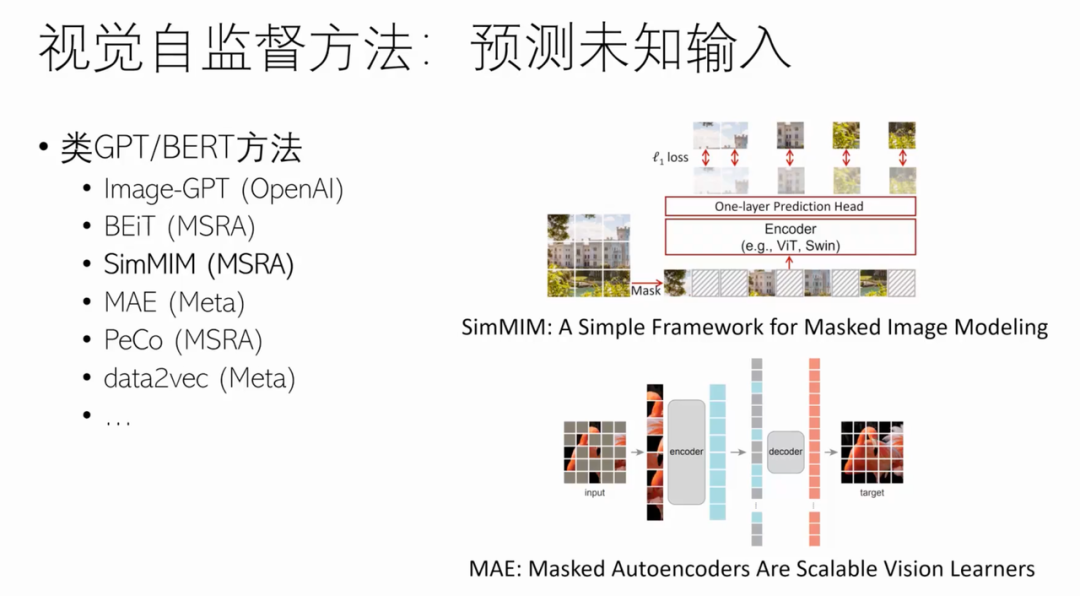

CV 领域以往是基于有监督来做预训练,但从 MoCo 首次以自监督的方式超越有监督的方式开始,视觉自监督方法引起了广泛的关注。

NLP 领域中的学习方法在 CV 领域被验证有效。

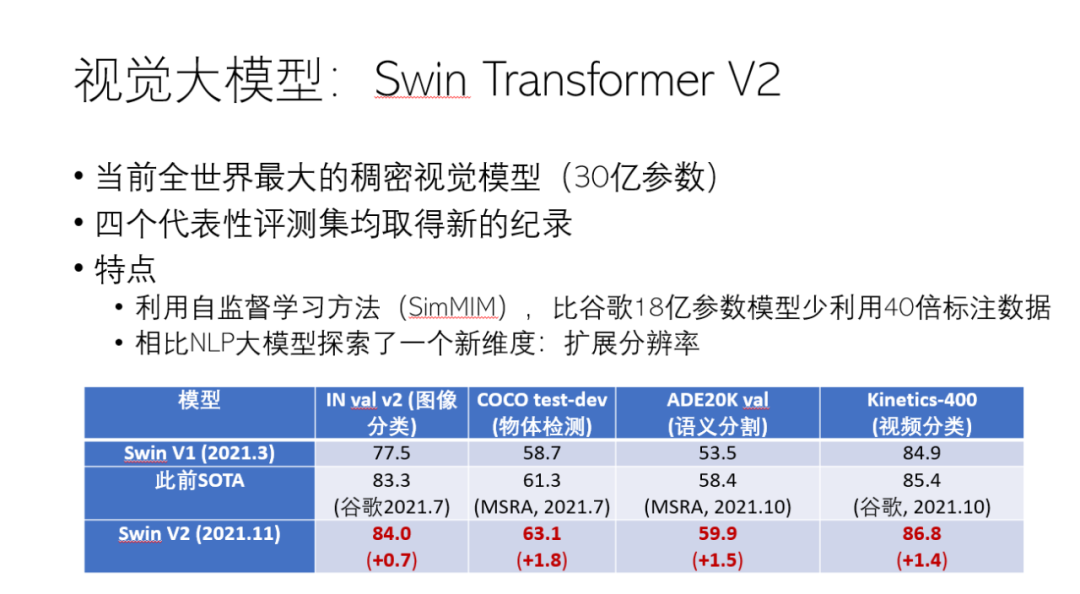

统一网络架构和统一学习方法铸造视觉大模型Swin Transformer v2。

分享的最后,胡博士讲道:我们应该期待去拥抱 AI 的统一网络架构以及学习方法。