「猫和老鼠」,这部创作于1940年的动画,现在已经85岁了。

如今,只需一个提示,不用任何剪辑,AI便可「无限续杯」童年经典,继续延续它的魅力。

你没有看过的《猫和老鼠》情节画面,由AI制作

你没有看过的《猫和老鼠》情节画面,由AI制作

来自英伟达、斯坦福、UCSD、UC伯克利以及UT Austin研究团队,通过Test-Time Training构建了一个「一分钟视频」生成器。

只需在预训练Transformer中嵌入TTT层 ,仅5B参数模型可理解复杂提示,生成长达1分钟视频。

图片

图片

论文地址:https://test-time-training.github.io/video-dit/

基于《猫和老鼠》的动画进行测试后,相较于Mamba2等基线,TTT生成视频Elo要领先34分。

借用老黄那句话,未来每一个像素都将是生成的。

图片

图片

首批1分钟无剪辑AI版「猫和老鼠」

用下面的故事概要,生成「全新的一集」猫和老鼠。

杰瑞高兴地在整洁的厨房里吃奶酪,直到汤姆顽皮地把奶酪拿走,逗他。生气的杰瑞收拾好行李离开了家,拖着一个小行李箱。后来,汤姆注意到杰瑞不在了,感到难过,并沿着杰瑞的小脚印一路追踪到旧金山。杰瑞无精打采地坐在一条小巷里,汤姆找到了他,温柔地用奶酪作为道歉。杰瑞原谅了汤姆,接受了奶酪,两人一起回家,友谊得到了恢复。

在一个阳光明媚的纽约早晨,汤姆,一只携带公文包的蓝灰色猫,来到了他在世界贸易中心的办公室。当他安顿下来时,他的电脑突然关机了——杰瑞,一只淘气的棕色老鼠,咬断了电缆。一场追逐开始了,最终汤姆撞到了墙上,而杰瑞逃进了自己的鼠洞。汤姆决心满满地冲进了一个办公室的门,不小心打断了由愤怒的斗牛犬斯派克主持的会议,斯派克生气地把他赶走了。在舒适的鼠洞里,杰瑞对这场混乱大笑起来。

汤姆正在厨房的桌子旁高兴地吃着苹果派。杰瑞眼巴巴地看着,希望自己也能吃一些。杰瑞走到房子的前门外面按了门铃。当汤姆来开门时,杰瑞绕到房子后面跑进了厨房。杰瑞偷走了汤姆的苹果派。杰瑞拿着派跑向他的鼠洞,而汤姆在后面追赶他。就在汤姆快要抓到杰瑞的时候,杰瑞成功钻进了鼠洞,汤姆撞到了墙上。

在一次水下冒险中,杰瑞找到了一张藏宝图,并在躲避汤姆的追逐中穿过珊瑚礁和海带森林寻找宝藏。杰瑞最终在一处沉船内发现了宝藏,欣喜若狂地庆祝,而汤姆的追逐却让他遇到了一条饥饿的鲨鱼,陷入了麻烦。

已关注 关注 重播 分享 赞 关闭观看更多更多

退出全屏切换到竖屏全屏退出全屏新智元已关注分享视频,时长01:03

0/0

00:00/01:03 切换到横屏模式 继续播放进度条,百分之0播放00:00/01:0301:03全屏 倍速播放中 0.5倍 0.75倍 1.0倍 1.5倍 2.0倍 超清 流畅 您的浏览器不支持 video 标签

继续观看

英伟达华人AI版《猫和老鼠》爆火全网,60秒经典泪目!仅靠Transformer新增一层

观看更多转载,英伟达华人AI版《猫和老鼠》爆火全网,60秒经典泪目!仅靠Transformer新增一层新智元已关注分享点赞在看已同步到看一看写下你的评论 视频详情

汤姆和杰瑞参观了一个热闹的嘉年华,汤姆急切地尝试了一个投球游戏,但反复失手,这让杰瑞嘲笑他。感到沮丧的汤姆变得非常坚定,但尽管他尽了最大努力,还是没能击倒罐子。杰瑞自信地走上前去,轻松成功,击倒了罐子并赢得了一座闪亮的金质奖杯。杰瑞高兴地庆祝他的胜利,而汤姆则惊讶、嫉妒且生气,当他们一起离开嘉年华时——杰瑞自豪地拿着他的奖品,而汤姆则闷闷不乐地跟在后面。

已关注 关注 重播 分享 赞 关闭观看更多更多

退出全屏切换到竖屏全屏退出全屏新智元已关注分享视频,时长01:03

0/0

00:00/01:03 切换到横屏模式 继续播放进度条,百分之0播放00:00/01:0301:03全屏 倍速播放中 0.5倍 0.75倍 1.0倍 1.5倍 2.0倍 超清 流畅 您的浏览器不支持 video 标签

继续观看

英伟达华人AI版《猫和老鼠》爆火全网,60秒经典泪目!仅靠Transformer新增一层

观看更多转载,英伟达华人AI版《猫和老鼠》爆火全网,60秒经典泪目!仅靠Transformer新增一层新智元已关注分享点赞在看已同步到看一看写下你的评论 视频详情

TTT层:视频生成的新希望

TTT层的核心思想,是对RNN层隐藏状态更新方式进行了创新。

TTT层的隐藏状态不再是简单的矩阵,而是神经网络,具体来说是两层MLP。

它比线性注意力变体里的线性隐藏状态多了2倍的隐藏单元,表达能力大大增强。

图片

图片

TTT层通过自监督学习压缩历史上下文,把这些信息变成隐藏状态的权重。

在这个过程中,有个很重要的更新规则,就是对自监督损失

进行梯度下降:

其中 是学习率。

是学习率。

输出标记z_t是模型根据更新后的权重对x_t的预测,也就是

图片

图片

为了让学习过程更具挑战性,研究人员会先把x_t处理成损坏的输入

然后优化损失函数

这和去噪自编码器有点类似,都需要挖掘x_t各个维度之间的相关性,才能从部分信息中重建它。

在实际操作过程中,TTT层还有一些关键设计。学习自监督任务时,不再是手动设计任务,而是采用端到端的学习方式。

TTT层和其他RNN层、自注意力层的接口是一样的,可以很方便地替换到各种网络架构里。

基于TTT层的视频生成方法

接下来看看研究人员是如何用TTT层生成视频的。

他们用预训练的CogVideo-X 5B作为基础模型,在这个模型里加上TTT层,再进行微调。

架构调整

在架构设计上,有几个很巧妙的地方,首先是门控机制。

TTT层是随机初始化的,如果直接加到预训练网络里,会让模型的预测性能大幅下降。

研究人员用一个可学习向量

来控制TTT层的输出,公式为

初始值设置为0.1,这样在微调初期,TTT层既能发挥作用,又不会过度影响原来的模型。

初始值设置为0.1,这样在微调初期,TTT层既能发挥作用,又不会过度影响原来的模型。

其次是双向机制。

由于扩散模型是非因果的,为了让TTT层更好地工作,研究人员通过

让TTT层可以逆序扫描输入序列,输出结果依然是按时间顺序排列的。

他们还对整个架构的序列建模块进行了修改,加上了TTT层和门控

让模型更好地处理长视频。

图片

图片

整体流程优化

研究人员把视频分成多个场景,每个场景又包含一个或多个3秒的片段。

这么做是因为原来的CogVideo-X的最大生成长度是3秒,而且《猫和老鼠》里大多数场景都至少有3秒,用3秒片段构建数据集也更方便。

文本提示有三种格式:格式1是用5-8句话简单概括剧情;格式2是用大约20句话详细描述,每句话对应一个3秒片段;格式3是分镜脚本,每个3秒片段都用3-5句话描述,包含了各种细节。

在实际处理的时候,输入到文本分词器的都是格式3,格式之间的转换由Claude 3.7 Sonnet完成。

从文本到序列的转换过程也很有意思。

CogVideo-X会把文本标记和带噪声的视频标记连接起来,形成输入序列。生成长视频的时候,就对每个3秒片段分别处理,然后把这些片段连接起来。

在处理过程中,自注意力层只在每个3秒片段内局部处理,而TTT层则对整个输入序列进行全局处理。

既控制了计算成本,又能充分发挥TTT层处理长上下文的优势。

数据集构建

研究人员基于1940年到1948年的81集《猫和老鼠》建了数据集。

他们先对原始视频进行超分辨率处理,提升画质,将分辨率统一为720×480。

然后让注释者把剧集分解成场景,提取3秒片段,并为每个片段编写详细的脚本。

为了训练不同时长的视频,他们还把3秒片段连接起来,形成9秒、18秒、30秒和63秒的视频。

并行化与效率提升

为了提高训练效率,研究人员对非因果序列进行了并行化处理。

他们每次更新b个标记的W(这里b=64),公式是

然后用W_ib生成小批量i中所有时间步的输出标记。

这样不仅实现了并行计算,还通过平均梯度减少了方差,让训练过程更加稳定。

由于TTT-MLP的隐藏状态太大,无法在单个SM的SMEM中存储,研究人员使用了片上张量并行技术。

把W^(1)和W^(2)在多个SM之间分片存储,就好像把一个大任务拆分成小份,让多个助手一起帮忙。

研究人员用NVIDIA Hopper GPU架构的DSMEM特性实现SM之间的全规约操作,还采用了多阶段流水线、异步预取等技术,减少数据传输时间,进一步提高效率。

一分钟视频效果评估

以如下故事概要作为视频生成词。

汤姆正高高兴兴地在厨房桌旁吃着苹果派。杰瑞则满怀渴望,羡慕地看着,希望自己也能尝一口。杰瑞走到屋前,按响了门铃。当汤姆去开门时,杰瑞绕到了后门进入厨房。杰瑞偷走了汤姆的苹果派,拿着苹果派快步跑向他的鼠洞,而汤姆紧追不舍。就在汤姆即将抓住杰瑞的时候,杰瑞顺利钻进了鼠洞,汤姆则撞到了墙上。

视频帧对比了TTT-MLP与Gated DeltaNet以及滑动窗口注意力——这些都是人工评估中表现领先的基线方法。

TTT-MLP通过在场景转换过程中保留细节展现了更好的场景一致性,并且通过准确描绘复杂动作实现了更自然的运动效果。

图片

图片

作为对比:

- TTT-MLP:在场景变化和不同角度之间保持时间一致性,生成流畅、高质量的动作。

- 滑动窗口注意力:改变了厨房环境,改变了房屋颜色,并复制了杰里偷派的情节。

- 门控 DeltaNet:在不同角度的Tom中缺乏时间一致性,但在后续帧中保持了厨房环境。

- Mamba2:扭曲了汤姆的外观,当他咆哮并追逐杰瑞时,但整个视频中保持了相似的厨房环境。

图片

图片

一分钟视频的人工评估结果显示,TTT-MLP平均比表现第二好的方法高出34 Elo分(1033 VS 999)。

在提升最多的评估维度上,场景一致性提高了38分,动作平滑性提高了39分。

作为对比,在Chatbot Arena中,GPT-4比GPT-3.5 Turbo高出46 Elo分,而GPT-4o比GPT-4Turbo 高出29 Elo分。

图片

图片

对于63秒的视频,全注意力(处理超30万个token)的推理时间比局部注意力长11倍,而训练时间长12倍。

TTT-MLP分别需要2.5倍和3.8倍——虽然比全注意力高效得多,但仍不及,例如Gated DeltaNet,其在推理和训练上均只比局部注意力长1.8倍。

评估维度与评估方法

从MovieGen提出的六个评估维度中,选取了其中四个与研究领域相关的,用于TTT效果的评估。

- 文本一致性(Text following):与所提供提示的对齐度 ,指生成内容与输入提示或要求的匹配程度。

- 动作自然度(Motion naturalness): 自然的肢体动作、面部表情,以及对物理定律的遵守。看起来不自然或怪异的动作将被扣分。

- 美学质量(Aesthetics):有趣且引人入胜的内容、灯光、色彩以及镜头效果。

- 时间一致性(Temporal consistency): 场景内部以及跨场景的一致性。

评估基于盲测比较(blind comparisons)中的两两比较偏好(pairwise preferences)。

因为直接对长视频进行评分或一次性对许多视频进行排序是很有挑战性的。

具体来说,评估者会随机获得前述四个评估维度中的一个,以及一对共享相同故事情节的视频,然后被要求指出在该评估维度 上哪个视频更好。

为了收集用于评估的视频池,研究人员首先使用Claude 3.7 Sonnet采样了100个故事情节,然后每种方法为每个故事情节生成一个视频。

生成视频的方法对评估者始终是未知的。

使用Chatbot Arena中的Elo评分系统(Elo system) 来汇总两两比较的偏好。

TTT-MLP方法比第二好的方法平均高出34 Elo分(可回顾上述表格)。

图片

图片

当然,TTT-MLP生成视频中也会有「瑕疵」。

- 时间一致性 (Temporal consistency): 物体有时会在3秒片段的边界处变形,这可能是因为扩散模型 在不同片段间从不同的模式 (modes) 中采样。

- 动作自然度 (Motion naturalness): 物体有时会不自然地漂浮,因为重力效果未能被正确建模。

- 美学质量 (Aesthetics): 除非在提示中明确要求,否则光线变化与动作并不总能保持一致。复杂的摄像机运镜(例如视差效果 parallax)有时会被不准确地描绘。

图片

图片

图片

图片

图片

图片

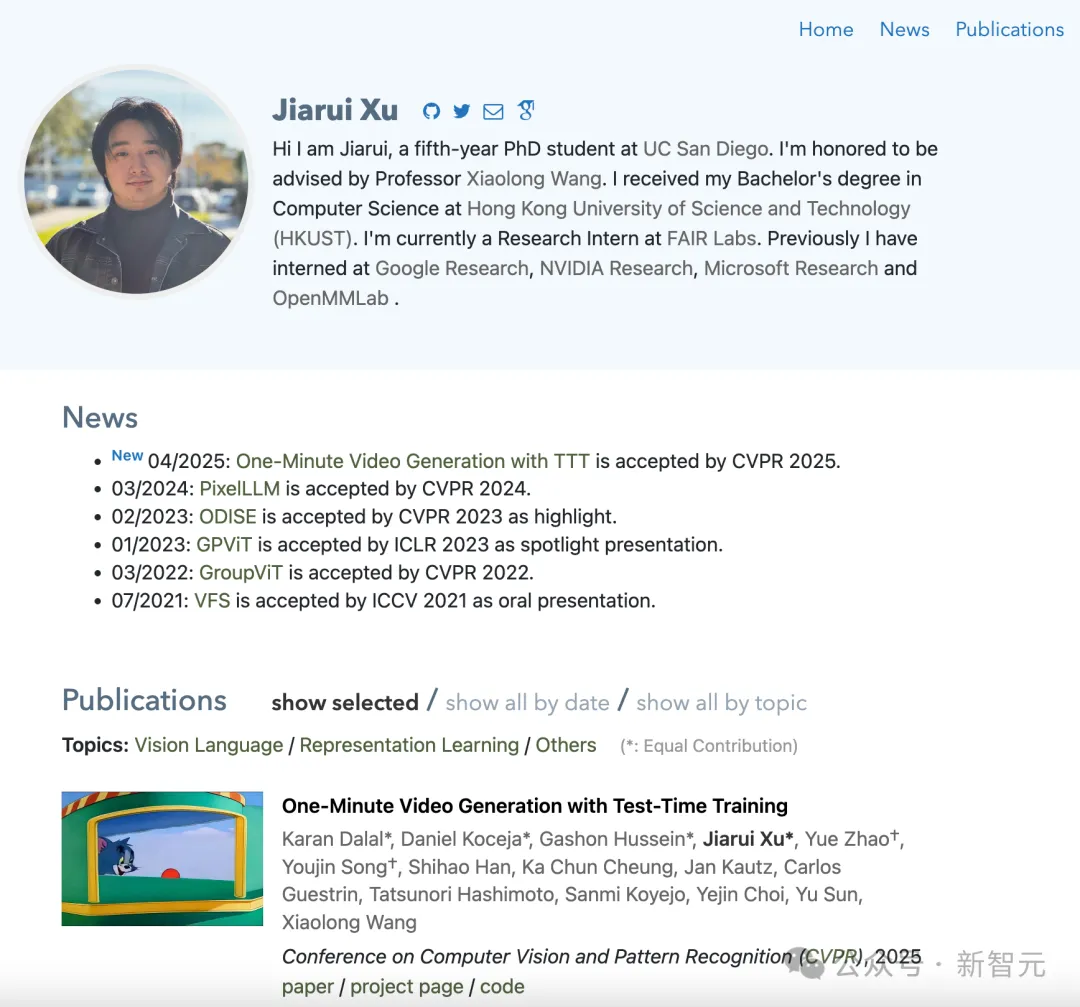

华人共同一作

本文有4名共同一作,其中一位为华人Jiarui Xu,UCSD的五年级博士生。

在香港科技大学获得了计算机科学学士学位。现在是FAIR实验室的研究实习生。

之前曾在Google Research、NVIDIA Research、Microsoft Research和OpenMMLab实习。

图片

图片

参考资料:

https://x.com/karansdalal/status/1909312851795411093

https://test-time-training.github.io/video-dit/