近日,何恺明团队提出了去噪哈密顿网络(Denoising Hamiltonian Network,DHN),就像给物理知识开了挂。

传统的机器学习方法虽然能处理一些简单的物理关系,但面对复杂的物理系统时,却显得力不从心。

来自MIT、斯坦福、西北大学等的研究者将哈密顿力学算子推广到神经网络中,不仅能捕捉非局部时间关系,还能通过去噪机制减轻数值积分误差。

论文链接:https://arxiv.org/abs/2503.07596

现有的方法对相邻时间步之间的局部关系进行建模,这就像是只看到了树木,却忽略了整个森林。

这种局限性使模型在处理复杂物理系统时,难以把握系统的全局特征和高级别的相互作用。

另一方面,它们专注于正向模拟,而忽视了更广泛的物理推理任务。

实际应用中,往往还需要解决许多其他问题,比如从稀疏的观测数据中推断物理参数,对不完整的轨迹进行修复,或者提高轨迹数据的分辨率等。

DHN:物理推理的创新引擎

DHN的出现突破了传统机器学习在物理推理中的局限,它将哈密顿力学巧妙地推广到神经网络。

哈密顿力学是经典力学的一种重要表述形式,它通过哈密顿量来描述系统的能量和状态变化。

DHN引入了块式离散哈密顿的概念。它把系统状态按照时间维度划分为一个个状态块,每个状态块包含多个时间步的状态信息。

通过这种方式,DHN可以捕捉到更长时间范围内的状态关系,突破了传统方法只能关注局部时间步的限制。

就像看一段舞蹈表演,不再是只关注每一个瞬间的动作,而是能够连贯地看到舞者在一段时间内的整体动作变化和节奏韵律。

块式离散哈密顿

将状态块定义为沿时间维度连接的(p,q)状态堆叠,即

其中b为块大小。引入步长s作为一个可定义的超参数,取代固定的时间间隔Δt。

这种方法使网络能够捕捉更广泛的时间相关性,同时保持哈密顿结构的不变性。

通过关联两个重叠的状态块(每个块大小为b,偏移步长为s)来定义分块离散哈密顿量:

下图展示了一个块大小b=4且步长s=2的分块离散哈密顿量。经典HNN可被视为块大小b=1且步长s=1的特例。

类似于HNN,分块离散哈密顿网络 可通过以下损失函数训练:

可通过以下损失函数训练:

去噪机制

DHN的去噪机制是其一大亮点。

受到去噪扩散模型的启发,DHN在训练过程中会对输入状态添加不同程度的噪声,然后通过网络自身的学习能力,逐步去除这些噪声,恢复出真实的物理状态。

通过这种方式,DHN能有效减轻数值积分误差,提高模型在长期预测中的稳定性。不同的噪声模式能让DHN在各种噪声条件下保持良好的适应性。

不同掩码模式

通过在训练过程中设计不同的掩码模式,研究团队实现了灵活的推理策略,以适应不同的任务。

图中展示了三种不同的掩码模式:

- 自回归(autoregression):对块的最后几个状态进行掩码,这类似于物理模拟中的前向建模,用于下一状态预测。

- 超分辨率(super-resolution):对块中间的状态进行掩码,可用于数据插值。

- 任意阶(arbitrary-order):包括随机掩码,掩码模式可根据任务需求自适应设计。

DHN网络架构

仅解码Transformer架构

对于每个哈密顿块,网络的输入由不同时刻的 堆叠以及

堆叠以及 堆叠组成,同时引入一个全局潜在编码z,用于对整个轨迹进行条件控制。

堆叠组成,同时引入一个全局潜在编码z,用于对整个轨迹进行条件控制。

仅解码Transformer采用类似于GPT的仅解码架构,但不包含因果注意力掩码。

对所有输入token 应用自注意力机制,将其作为长度为2b+1的序列处理。

应用自注意力机制,将其作为长度为2b+1的序列处理。

其中,全局潜在编码z作为查询token,用于输出哈密顿值。

DHN还将每个状态的噪声尺度编码到位置嵌入中,让网络更好地感知噪声对状态的影响。

研究者实现了一个简单的两层Transformer,在单个GPU上就能高效运行。

自动解码

为了高效地存储和优化系统特定的嵌入,DHN采用了自动解码架构。

与传统的依赖编码器网络来推断潜在编码的方法不同,DHN为每个轨迹维护一个可学习的潜在编码z。

这就好比为每个轨迹建立了一个专属的「记忆库」,在训练过程中,网络权重和潜在编码会联合优化,不断地调整和完善这个「记忆库」。

训练完成后,当遇到新的轨迹时,只需冻结网络权重,对新轨迹的潜在编码进行优化,就能快速适应新的情况。

实验中的卓越表现

为验证DHN的有效性,研究人员进行了一系列实验,涵盖了多个不同的物理推理任务。

正向模拟

在正向模拟任务中,DHN需根据初始条件,逐步预测物理系统的未来状态。

在单摆和双摆系统中,通过在DHN块内应用掩码策略,让模型学习预测未来状态。

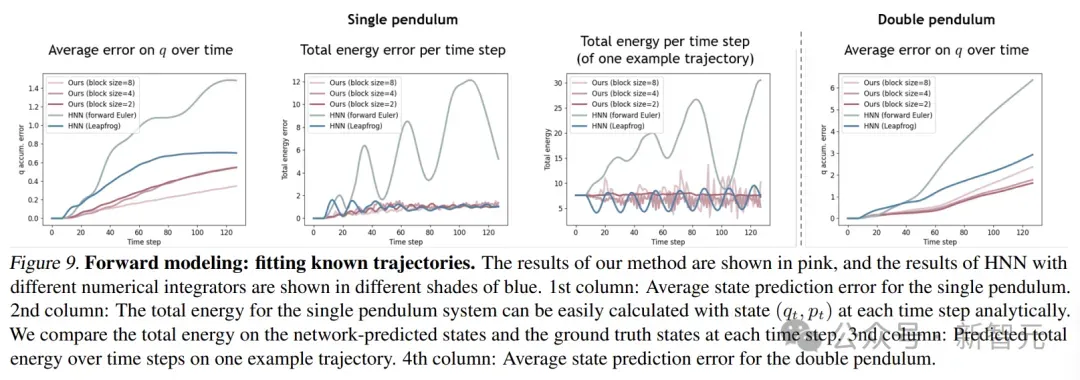

在拟合已知轨迹的实验中,与传统的HNN相比,DHN在预测单摆和双摆的状态时,误差更小。

当块大小为2时,DHN能稳定地守恒总能量,而HNN虽然是一个保证能量守恒的网络,但由于数值积分器的影响,仍然会出现不可控的能量漂移。

在对新轨迹进行补全的实验中,DHN同样表现优异。它能从稀疏的初始观测中准确地推断系统动力学,并预测未来状态。

相比之下,HNN和其他没有物理约束的基线模型在处理新轨迹时,误差较大,难以准确预测未来状态。

表示学习

表示学习是评估模型对物理系统参数编码和区分能力的重要任务。

DHN用随机掩码模式,利用去噪和随机掩码这两种自监督学习技术,来增强在动态物理系统中的表示学习能力。

研究人员在双摆系统上进行实验,预测摆长比 。

。

通过对自动解码器和代码进行预训练,然后用线性回归层对潜在代码进行线性探测,结果显示,DHN在学习表示物理属性方面很出色。

与HNN和普通网络相比,DHN的均方误差更低,能够更准确地捕捉到物理系统的潜在特征。

研究还发现,在双摆系统中,块大小为4是推断其参数的最佳时间尺度。

下图展示了不同块大小和步长的DHN的结果。对于简单的双层Transformer,最佳的块大小和步长约为 ,具有适度的重叠。

,具有适度的重叠。

轨迹插值

轨迹插值是DHN展示灵活性的另一个重要任务。DHN用渐进式超分辨率技术,通过重复应用2倍超分辨率来实现4倍超分辨率。

研究人员构建了块大小b=2、步长s=1的DHN块,对不同稀疏度的轨迹进行插值。

实验结果表明,在处理与训练集初始状态相同的轨迹时,DHN和基于CNN的方法都能取得较好的插值效果。

但在处理具有未见过初始状态的轨迹时,CNN由于严重依赖训练分布,难以泛化,而DHN凭借其受物理约束的表示,能够推断出合理的中间状态,展现出了强大的泛化能力。

尽管DHN在物理推理领域取得了显著的成果,但它也面临着一些挑战。

其中一个主要挑战是计算成本较高,相比传统Transformer,DHN需要更密集的梯度计算,这也限制了它的应用范围。

参考资料: