基于规则的强化学习(RL/RFT)已成为替代 SFT 的高效方案,仅需少量样本即可提升模型在特定任务中的表现。

该方法通过预定义奖励函数规避人工标注成本,如 DeepSeek-R1 在数学求解中的成功应用,以及多模态领域在图像定位等任务上的性能突破(通常使用 IOU 作为规则 reward)。

vivo 与香港中文大学的研究团队受到 DeepSeek-R1 的启发,首次将基于规则的强化学习(RL)应用到了 GUI 智能体领域。

论文标题:UI-R1: Enhancing Action Prediction of GUI Agents by Reinforcement Learning

论文地址:https://arxiv.org/abs/2503.21620

项目主页:https://yxchai.com/UI-R1/

项目代码:https://github.com/lll6gg/UI-R1

简介

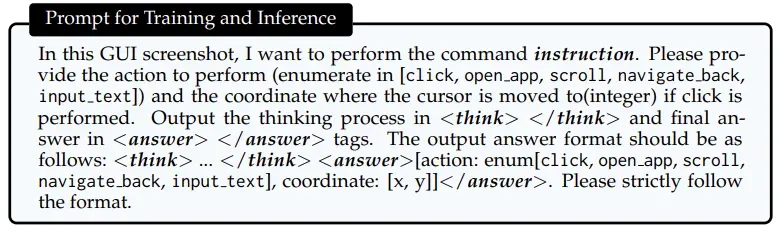

本研究创新性地将规则 RL 范式拓展至基于低级指令的 GUI 动作预测任务。具体实现中,多模态大语言模型为每个输入生成包含推理标记和最终答案的多条响应轨迹,在训练和测试时的 prompt 设计如下:

随后通过我们设计的奖励函数评估每条响应,并采用 GRPO 等策略优化算法更新模型参数。该奖励函数包含三个维度:

动作类型奖励:根据预测动作与真实动作的匹配度计算;

动作参数奖励(聚焦点击操作):通过预测坐标是否落入真实边界框评估;

格式规范奖励:评估模型是否同时提供推理过程和最终答案。

数据制备方面,仅依据难度、多样性和质量三原则筛选 130 余个移动端训练样本,展现出卓越的数据效率。实验表明,UI-R1 在桌面端和网页平台等跨领域(OOD)数据上均取得显著性能提升,印证了规则 RL 处理跨领域复杂 GUI 任务的潜力。

方法:强化学习驱动的 GUI 智能体

我们提出的 UI-R1 模型采用了三个关键创新:

1. 独特的奖励函数设计

研究团队设计了专门针对 GUI 任务的奖励函数:R = R_T + R_C + R_F

R_T:行为类型奖励(点击、滑动、返回等)

R_C:坐标准确度奖励(点击位置是否准确)

R_F:格式奖励(输出的格式是否正确)

2. 精心筛选的高质量数据

与其使用大量普通数据,我们提出采用了「质量优先」的策略,从三个维度精选训练数据:

质量:选择标注准确、对齐良好的样本

难度:专注于基础模型难以解决的「困难」样本

多样性:确保涵盖各种行为类型和元素类型

最终只使用了 136 个高质量样本,比传统方法少了几百甚至上千倍,就能够训练得到比 SFT 方式更优的效果。

3. 群体相对策略优化算法

UI-R1 采用了一种名为 GRPO(Group Relative Policy Optimization)的算法。这种算法不需要额外的评论家模型,而是通过比较同一问题的多个不同回答来学习什么是「好」的回答。

实验结果

1. 域内效果提升明显

在 AndroidControl 基准测试上,UI-R1-3B 与基础模型 Qwen2.5-VL-3B 相比:

行为类型准确率提高了 15%

定位准确率提高了 10.3%

2. 域外泛化能力惊人

UI-R1 在从未见过的桌面 PC 端和网页界面上表现同样出色:

在 ScreenSpot 测试中,UI-R1-3B 的平均准确率达到 78.6%,超越 CogAgent-18B 等大模型。

在专业高分辨率环境 ScreenSpot-Pro 测试中,UI-R1-3B 达到 17.8% 的平均准确率,提升了与使用 76K 数据训练的 OS-Atlas-7B(18.9%)性能相当。

分析

我们关于 UI-R1 做了一系列分析,研究发现:在 GRPO 的强化学习微调的方式下,数据质量比数据数量重要:

困难样本更有价值:按难度选择的方法比随机选择的性能显著更好。

数据增长收益递减:随着训练数据量增加,性能提升趋于平缓。

精选小数据集比大数据集更有效:三阶段数据选择方法优于使用整个数据集或者随机筛选相同数量的子集。

此外,我们还发现动作预测的难度与思考的长度之间存在关联:思考长度越长,准确率越低(说明问题越难),但通过 UI-R1 形式的强化学习微调之后,对于难样本的成功率提升也更加明显。

这一现象证明了强化微调的价值,通过让模型自主思考来提升难样本的准确率,这个特性是之前的监督微调所难以获得的。

未来探索方向

UI-R1 初步探索了大模型强化学习和推理技术在 GUI Agent 领域的应用。下一步,我们将尝试将 UI-R1 从 RFT 拓展到 SFT + RFT 的组合,实现大规模 UI 数据下统一的思考、决策、规划的 GUI Agent 大模型。