如今,OpenAI o1 和 DeepSeek R1 等推理模型的发展,显著提升了思维链 (CoT) 之类的技术在大语言模型 (LLM) 推理任务上的表现。这种范式鼓励模型将问题分解为逐步探索,模仿人类的结构化推理过程。虽然这种方法有效,但它在推理时需要更多的计算资源,导致输出冗长且延迟更高。

这种冗长与人类通常解决问题的方式形成了鲜明的对比:我们依靠简洁的草稿或速记笔记来捕捉基本见解,而无需不必要的繁琐。

受这种差异的启发,来自美国 Zoom 视频通讯公司的研究团队提出了 Chain of Draft(CoD),这是一种新颖的提示策略,通过优先考虑效率和极简主义,更接近人类推理。

具体来讲,CoD 鼓励 LLM 在每个步骤生成简洁、信息密集的输出,而不是过度强调中间步骤。这种方法在不牺牲准确性的情况下减少了延迟和计算成本,使 LLM 更适合效率至上的实际应用。

论文标题:Chain of Draft: Thinking Faster by Writing Less

论文地址:https://arxiv.org/pdf/2502.18600

针对大语言模型传统推理范式中的效率瓶颈,该研究捕捉到了人类思维中「关键信息快照」的本质特征,提出了 CoD。为了评估 CoD 的有效性,研究团队在数学推理、常识推理和符号推理等需要多步推理的基准上进行了实验。

结果显示,在符号推理任务中,CoD 的信息密度达到标准 CoT 输出的 14.7 倍,同时显著减少了 token 的使用和延迟。

本文的研究贡献包括:

设计稀疏的推理草稿,仅需 7.6% 的 token 量即可完成等效推理深度,开创了认知启发的模型压缩新路径;

端到端推理延迟压缩与部署成本的降低,推理延迟从 0.9 秒压缩至 0.7 秒,实现「降本增效」的双重突破;

提出了新的大模型重构推理架构,为金融高频交易、自动驾驶决策等时延敏感型应用提供了可行性验证,标志着 LLM 从实验室模型向工业引擎的实质性跨越。

方法概述

该研究创新性地提出了 CoD。CoD 提示将推理过程浓缩为最小的抽象表示。推理过程被提炼为一个简洁的方程式,仅关注得出解决方案所需的基本数学运算。通过抽象出不相关的上下文细节,CoD 显著减少了 token 数量,同时保持了透明度和正确性。

CoD 基于认知科学中人类思维模式,其信息密度是传统 CoT 的 13.2 倍,在开发过程中,研究团队通过跨学科迭代:

首先基于思路链的结构化提示,构建端到端、简化认知等特征的思维稿;

继而设计思维稿对大模型驱动推理赋能,在 Claude 3.5 Sonnet 上实现算术推理 token 消耗从 189.4 骤降至 14.3(节省 92.4%);

最终通过并行稀疏注意力框架(吞吐量 + 3.8 倍)和动态批处理技术(批次弹性扩展 1-128)完成工业级优化,实测端到端延迟从 3.1 秒压缩至 1.6 秒(降幅 48.4%),为高频金融交易等场景提供亚秒级(<0.5s)高效推理支持。

下图展示了 CoT 与 CoD 提示的区别:

实验结果

研究中较为全面、科学地评估其有效性和性能,设置了一系列严谨且针对性强的实验:基准测试实验、效率验证实验和成本效益实验。

基准测试实验选取了多个要求多步推理的基准测试,涵盖了数学推理、常识推理和符号推理等领域。

效率验证实验包括 token 消耗评估和推理延迟测试,其中 token 消耗评估包括精确测量 CoD 在各个基准测试任务中所使用的 token 数量,并与 CoT 进行对比;推理延迟测试通过 CoD 在不同任务中的端到端推理延迟,并与 CoT 进行比较。

成本效益实验基于 token 消耗和推理延迟等因素,计算 CoD 和 CoT 的单位推理成本。

推理试验数据集考虑以下五个数学应用题基准,(1) 数学应用题的 GSM8K 数据集,(2) 结构各异的数学应用题的 SVAMP 数据集,(3) 各种数学应用题的 ASDiv 数据集,(4) 代数应用题的 AQuA 数据集,以及 (5) MAWPS 基准。

研究中所提出的模型方法在 GSM8K 这一数学推理任务中,在 GPT-4o 下,CoD 的准确率达到了 91.1%,CoT 的准确率为 95.4%,CoT 的准确率略高于 CoD。但 Token 消耗方面,CoD 仅需 14.3 个 Token,相比传统模型的 161.2 个 Token。推理延迟也从传统模型的 4.2 秒大幅压缩至 1.0 秒,降低了 76.2%。

对于 Claude 3.5 Sonnet,CoD 和 CoT 的准确率表现相近。在 Token 消耗方面,CoD 相较于 CoT 下降了 79.1%,推理速度提升至 1.6 秒,延迟降低了 48.4%。这表明 CoD 在保证较高准确率的同时,极大地提升了推理效率,减少了计算资源的消耗。

对于常识推理任务(下表 2 日期理解),在 GPT-4o 下,CoD 的准确率为 88.1%,低于 CoT 的 90.2%。Token 消耗上,CoD 为 30.2 个 Token,CoT 则达到 75.7 个 Token,节省了 60.1% 的 Token,时间也从 1.7 秒降低到 1.3 秒。

对于 Claude 3.5 Sonnet,CoD 的准确率高达 89.7%,高于 CoT 的 87.0%,而 token 消耗相较于 CoT 下降了 82.0%,推理时间从 3.2 秒减少到 1.4 秒。CoD 在常识推理任务中同样展现出高效性和准确性,能够更快速且精准地处理常识性问题。

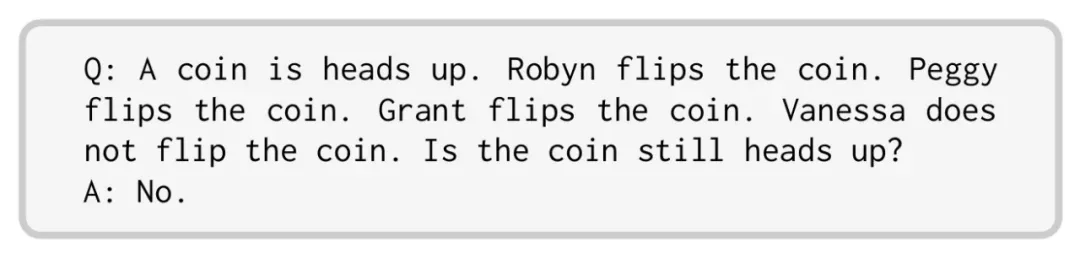

在原始 CoT 研究论文中提出的硬币翻转推理任务框架下,研究者要求大语言模型(LLM)根据一系列抛硬币操作序列预测最终硬币的正反面状态。由于该研究的原始实验数据集尚未开源,本研究严格遵循其方法论复现了包含 250 个测试样本的基准数据集。研究人员按照相同的设计合成了一个包含 250 个示例的测试集,基于 NameDataset 数据集,从美国地区排名前 1000 的名字中随机选择 4 个,并随机决定是否对每个名字抛硬币。评估数据的示例如下所示。

GPT-4o 和 Claude 3.5 Sonnet 的测试结果如表 4 所示。在标准提示方式下,这两个模型的准确率分别为 73.2% 和 85.2%。不过当采用 CoT和 CoD提示策略时,两个模型均达到了 100% 的完美准确率。通过与 CoT 相比, CoD 显著减少了 token 使用量,对于 GPT-4o 减少了 68%,对于 Claude 3.5 Sonnet 则减少了 86%。

更多实验结果请参阅原论文。