Meta前脚刚发Llama 4,后脚就有大佬请辞了!

一亩三分地的爆料贴称,经过反复训练后,Llama 4未能取得SOTA,甚至与顶尖大模型实力悬殊。

为了蒙混过关,高层甚至建议:

在后训练阶段中,将多个benchmark测试集混入训练数据。

在后训练阶段中,将多个benchmark测试集混入训练数据。

最终目的,让模型短期提升指标,拿出来可以看起来不错的结果。

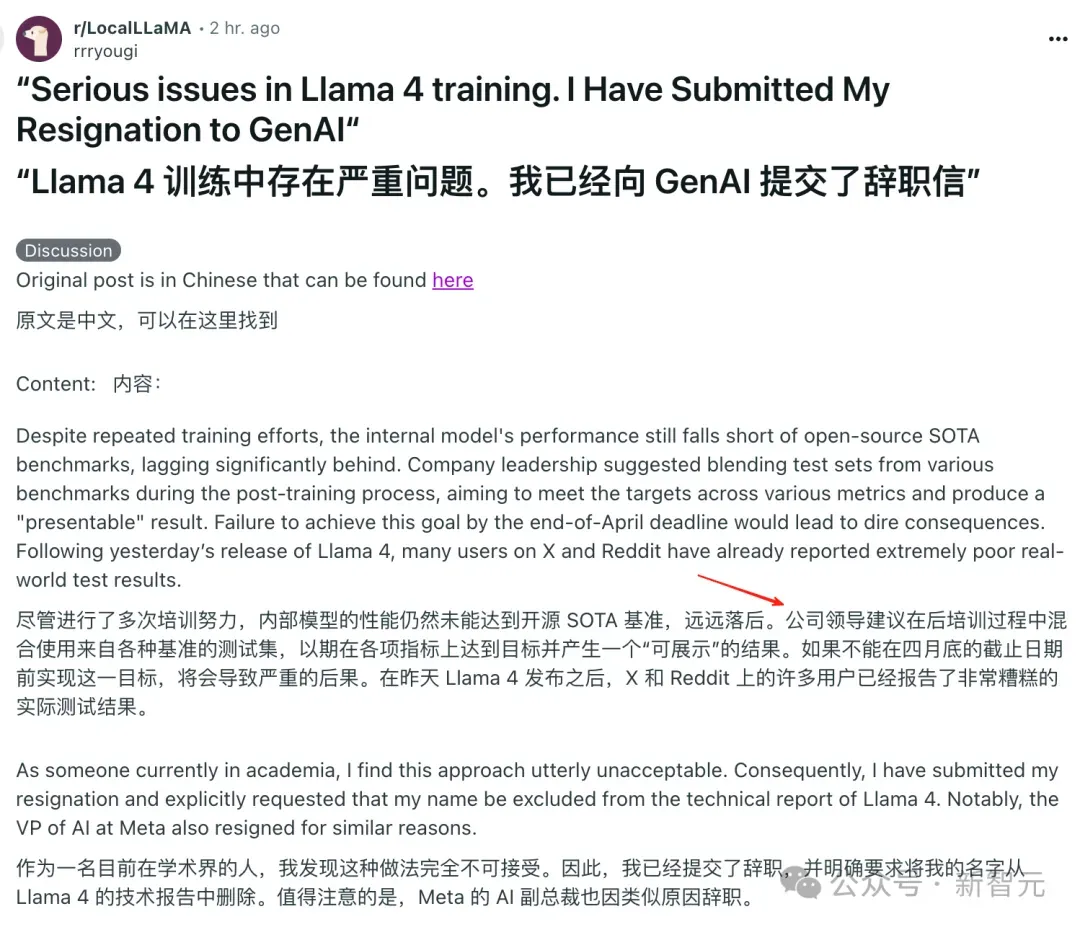

这位内部员工@dliudliu表示,「自己根本无法接受这种做法,甚至辞职信中明确要求——不要在Llama 4技术报告中挂名」。

另一方面,小扎给全员下了「死令」——4月底是Llama 4交付最后期限。

在一系列高压之下,已有高管提出了辞职。

其实,Llama 4昨天开源之后,并没有在业内得到好评。全网测试中,代码能力极差,实力不如GPT-4o。

网友Flavio Adamo使用相同的提示词,分别让Llama 4 Maveric和GPT-4o制作一个旋转多边形的动画。

可以看出,Llama 4 Maveric生成的多边形并不规则而且没有开口。小球也不符合物理规律,直接穿过多边形掉下去了。

相比之下GPT-4o制作的动画虽然也不完美,但至少要好得多。

甚至,有人直接曝出,Llama 4在LMarena上存在过拟合现象,有极大的「作弊」嫌疑。

而如今,内部员工爆料,进一步证实了网友的猜想。

沃顿商学院教授Ethan Mollick一语中的,「如果你经常使用 AI 模型,不难分辨出哪些是针对基准测试进行优化的,哪些是真正的重大进步」。

不过,另一位内部员工称,并没有遇到这类情况,不如让子弹飞一会儿。

内部员工爆料,Llama 4训练作弊?

几位AI研究人员在社交媒体上都「吐槽」同一个问题,Meta在其公告中提到LM Arena上的Maverick是一个「实验性的聊天版本」。

如果看得仔细一点,在Llama官网的性能对比测试图的最下面一行,写着「Llama 4 Maverick optimized for conversationality.」

翻译过来就是「针对对话优化的Llama 4 Maverick」——似乎有些「鸡贼」。

这种「区别对待」的会让开发人员很难准确预测该模型在特定上下文中的表现。

AI的研究人员观察到可公开下载的Maverick与LM Arena上托管的模型在行为上存在显著差异。

而就在今天上午,已经有人爆料Llama 4的训练过程存在严重问题!

即Llama 4内部训练多次仍然没有达到开源SOTA基准。

Meta的领导层决定在后训练过程中混合各种基准测试集——让Llama 4「背题」以期望在测试中取得「好成绩」。

这个爆料的原始来源是「一亩三分地」,根据对话,爆料者很可能来自于Meta公司内部。

对话中提到的Meta AI研究部副总裁Joelle Pineau也申请了5月底辞职。(不过,也有网友称并非是与Llama4相关)

但是根据Meta的组织架构体系,Pineau是FAIR的副总裁,而FAIR实际上是Meta内部与GenAI完全独立的组织,GenAI才是负责Llama项目的组织。

GenAI的副总裁是Ahmad Al-Dahle,他并没有辞职。

Llama 4才刚刚发布一天,就出现如此重磅的消息,让未来显得扑朔迷离。

代码翻车,网友大失所望

在昨天网友的实测中,评论还是有好有坏。

但是过去一天进行更多的测试后,更多的网友表达了对Llama 4的不满。

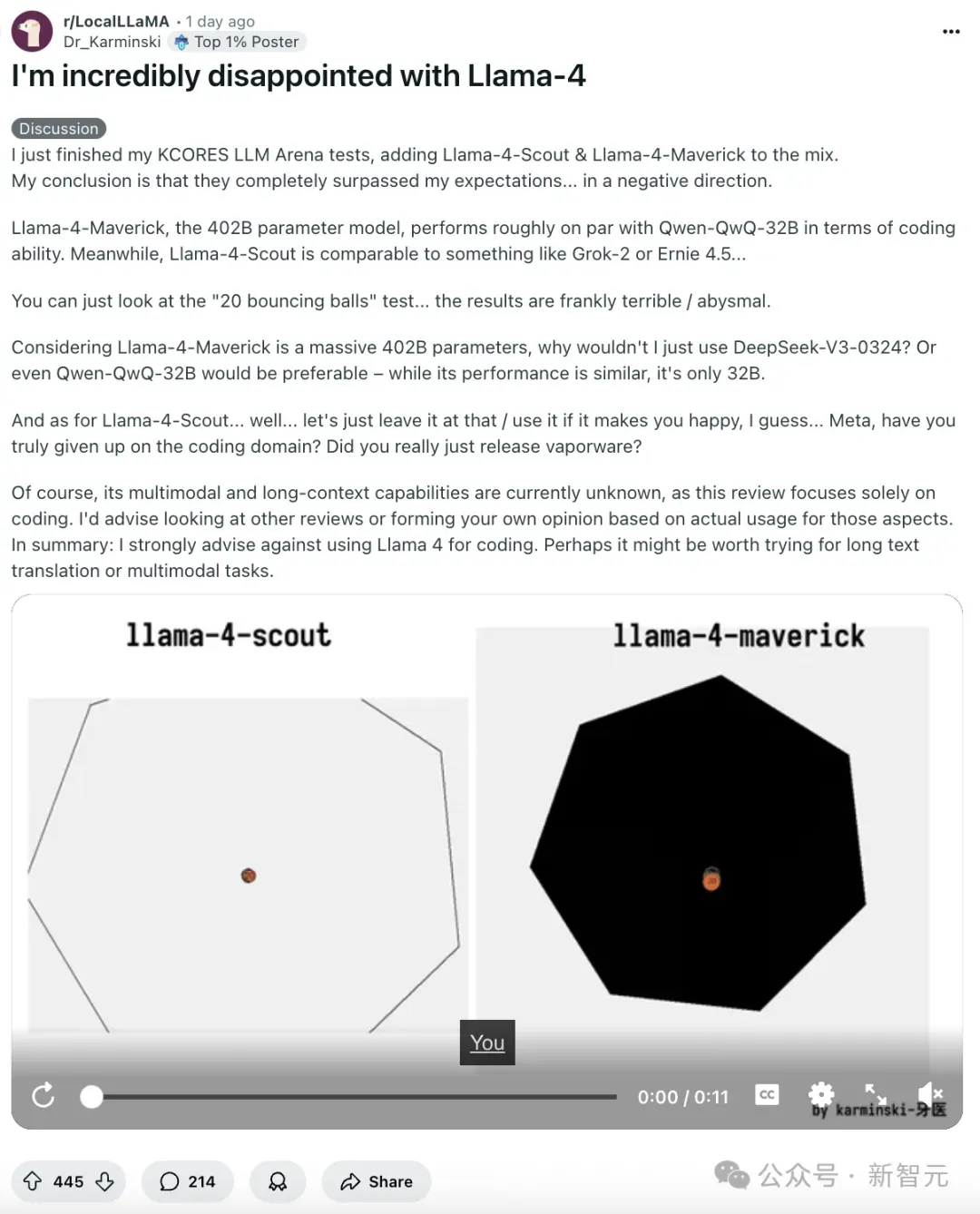

在Dr_Karminski的一篇热帖中,他说Llama-4-Maverick——总参数402B的模型——在编码能力方面大致只能与 Qwen-QwQ-32B相当。

Llama-4-Scout——总参数109B的模型——大概与Grok-2或Ernie 4.5类似。

在评论中,网友响应了这个判断。

有人说Llama 4的表现比Gemma 3 27B还要差。

有人认为Llama 4的表现甚至和Llama 3.2一样没有任何进步,也无法完成写诗。

其他用户在测试后也表达了同样的观点,Llama 4有点不符合预期。

网友Deedy也表达了对Llama 4的失望,称其为「一个糟糕的编程模型」。

他表示,Scout (109B) 和Maverick (402B)在针对编程任务的Kscores基准测试中表现不如4o、Gemini Flash、Grok 3、DeepSeek V3和Sonnet 3.5/7。

他还给出了贴出了Llama 4两个模型的一张测试排名,结果显示这两个新发布的模型远远没有达到顶尖的性能。

网友anton说,Llama 4「真的有点令人失望」。

他表示自己不会用它来辅助编码,而Llama 4的定位有点尴尬。

anton认为Llama 4的两个模型太大了,不太好本地部署。他建议Meta应该推出性能优秀的小模型,而不是去追求成为SOTA。

「因为目前他们根本做不到。」他写道。