刚刚,ICLR 2025 宣布了今年的时间检验奖获奖论文。这个奖项旨在表彰十年前在 ICLR 2015 上发表的对该领域产生持久影响的论文。

经久不衰的「Adam 算法」拿到了冠军,比 Transformer 论文更早引入注意力机制的「Neural Machine Translation by Jointly Learning to Align and Translate」拿到了亚军。这样的结果可谓「实至名归」。

Adam:深度学习领域应用最广泛的优化算法之一

Adam 算法,即 Adaptive Moment Estimation 算法,是一种结合了动量法和 RMSprop 算法思想的自适应学习率优化算法。

Adam 革命性地改变了神经网络训练,在各种架构和任务中实现了显著更快的收敛速度和更稳定的训练过程。如今,它已经成为深度学习中最广泛采用的优化算法之一。

Adam 算法的创新之处在于,它结合了 AdaGrad 和 RMSProp 的优点,通过维护第一矩估计(均值)和第二矩估计(未中心化的方差)来动态调整每个参数的学习率,能够处理稀疏梯度和非平稳目标函数。

它的重要性体现在其广泛的应用场景,无论是计算机视觉、自然语言处理还是强化学习等领域,Adam 算法都为模型的高效训练提供了有力支持,极大地提高了模型的训练效率和性能,成为无数最先进模型的默认优化器。

根据 Google Scholar 的数据,Adam 论文的被引量已经超过 21 万。

论文链接:https://arxiv.org/abs/1412.6980

该论文总共有两位作者 ——Diederik P. Kingma 和 Jimmy Lei Ba。

Diederik P. Kingma 是一位计算机科学家和研究员,专注于机器学习和生成式建模的可扩展方法。他的重要贡献包括变分自编码器(VAE)、Adam 优化器、Glow 和变分扩散模型。其中,VAE 获得了去年的 ICLR 时间检验奖。所以,这次是 Diederik P. Kingma 第二次获得该奖项。而截至目前,该奖项总共就颁了两次。

2017 年,他以优异成绩获得阿姆斯特丹大学博士学位。2015 年,他作为创始团队成员参与创建了 OpenAI。在此之前,他共同创立了 Advanza 公司,该公司于 2016 年被收购。

他的职业生涯包括:

2009 年和 2012 年:在纽约大学 Yann LeCun 实验室担任初级研究科学家;

2010-2012 年:Advanza 联合创始人兼技术负责人,公司于 2016 年成功退出;

2013-2017 年:在阿姆斯特丹大学攻读博士学位,导师为 Max Welling,研究领域为深度学习和生成模型;

2015-2018 年:OpenAI 创始团队成员和研究科学家,领导算法团队,专注于基础研究;

2018-2024 年:在 Google Brain/DeepMind 担任研究科学家,领导多个研究项目,主要是文本、图像和视频的生成模型;

2024 年至今:在 Anthropic 研究大规模机器学习。

另一位作者多伦多大学 Jimmy Lei Ba 现在是多伦多大学的助理教授。他的长期研究目标是解决一个计算问题:如何构建具有人类效率和适应性的通用问题解决机器。他的研究兴趣主要集中在开发高效的深度神经网络学习算法上。他的研究领域与 NeurIPS、ICLR 和 ICML 等研究社区有交叉。此外,他对强化学习、自然语言处理和人工智能也有广泛的兴趣。

Jimmy Lei Ba 在 Geoffrey Hinton 的指导下完成了博士学位。他的硕士(2014 年)和本科学位(2011 年)均在多伦多大学获得,师从 Brendan Frey 和 Ruslan Salakhutdinov。他是 CIFAR AI chair,曾在 2016 年获得 Facebook 机器学习研究生奖学金。

亚军论文 比 Transformer 提前三年引入注意力机制

获得 ICLR 时间检验奖亚军的论文「Neural Machine Translation by Jointly Learning to Align and Translate」同样来头不小,图灵奖得主 Yoshua Bengio 是该论文的作者之一。

论文链接:https://arxiv.org/abs/1409.0473

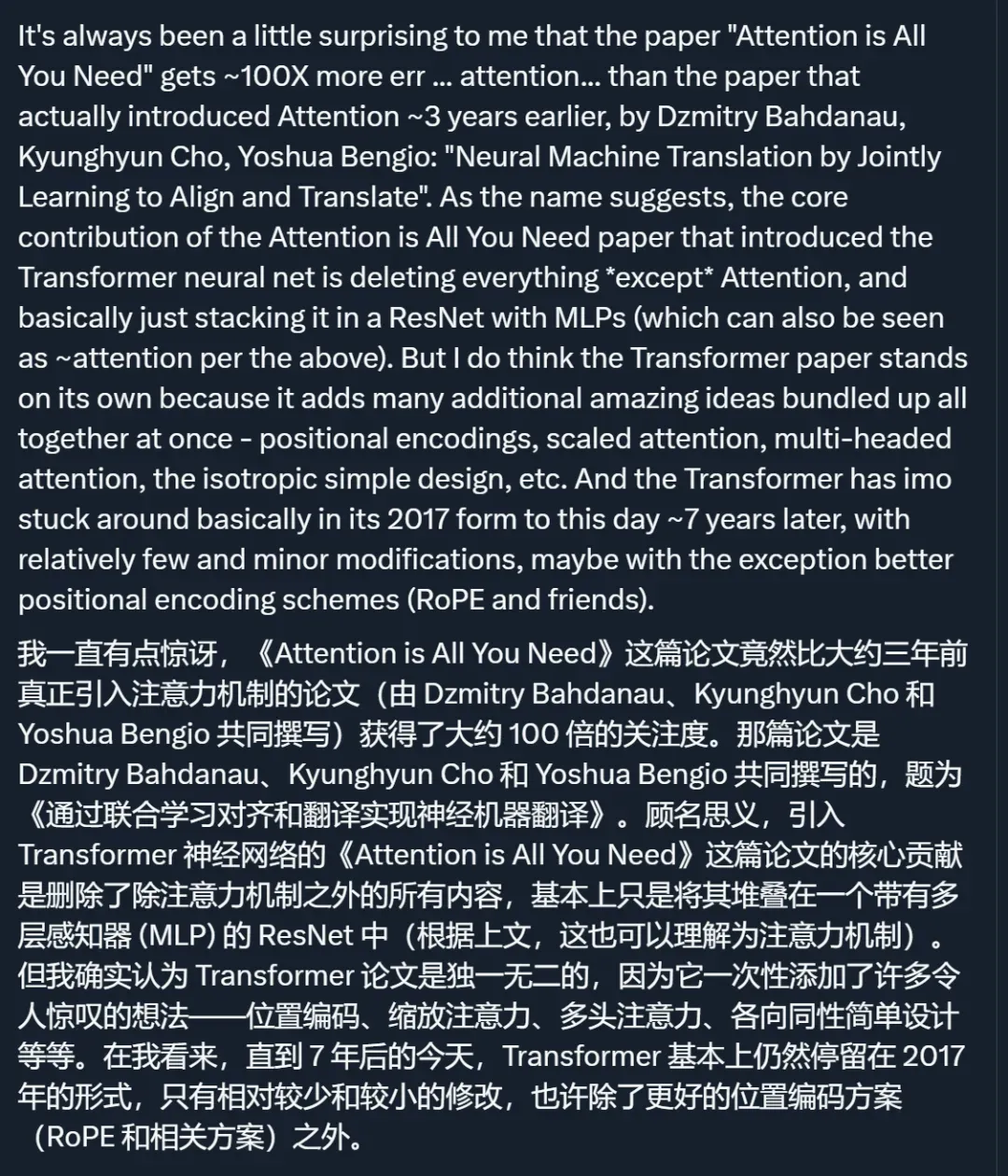

去年 12 月,AI 大牛 Andrej Karpathy 专门发帖为这篇论文鸣不平,称它是「真正引入注意力机制的论文」,但受到的关注远远不及三年后才出现的 Transformer 论文。

具体来说,这篇论文的创新之处在于,它引入了一种注意力形式,从根本上改变了序列到序列模型处理信息的方式。在此之前,编码器 - 解码器架构通常将整个输入序列压缩为固定长度的向量,从而为较长的序列造成内存瓶颈。该方法使模型能够在翻译过程中动态地「关注」源句子的不同部分,从而处理相关的上下文信息。这种注意力机制已经成为现代深度学习的基石,远远超出了机器翻译的范畴,形成了 transformer 和大型语言模型的基础。这篇论文的实际影响是巨大的,使其成为对神经网络架构最有影响力的贡献之一。

这篇论文总共有三位作者:Dzmitry Bahdanau、Kyunghyun Cho 和 Yoshua Bengio

Dzmitry Bahdanau 在加拿大 Mila 研究所完成了博士学位,师从 Yoshua Bengio。他现在是一位在 ServiceNow 旗下(前 Element AI)工作的研究科学家。他同时也是 Mila 的核心产业成员和麦吉尔大学的兼职教授。

Dzmitry Bahdanau 坚信人类语言技术(HLT,他认为这是比 NLP 更好的称呼)将改变人类与软件交互和获取知识的方式。事实上,这种改变已经开始发生(比如网络搜索),但这仅仅是个开始。Bahdanau 对 HLT 技术栈各个层面的研究问题都有浓厚兴趣,包括深度学习基础、基础模型训练、特定任务算法(尤其是语义解析)以及用户与 AI 系统的交互体验。他近期正在进行的工作主要集中在语义解析和面向任务的对话方法、代码生成、神经模型的系统性(组合性)泛化和样本效率上。

在发给 Karpathy 的邮件中,Dzmitry Bahdanau 曾详细谈过他们当年研究「注意力机制」的往事。

他提到,「 我作为实习生来到 Yoshua 的实验室…… 我告诉 Yoshua 我愿意做任何工作。Yoshua 安排我参与机器翻译项目…… 有一天,我突然想到让解码器 RNN 学习在源序列中搜索放置游标的位置会很好。这有点受到翻译练习的启发,在中学学习英语时会用到这种练习。当你翻译时,目光在源序列和目标序列之间来回移动。我提出了对 BiRNN 状态进行软搜索作为 softmax 然后进行加权平均的想法。这个方法从一开始就表现出色,令人振奋 。我称这种架构为 RNNSearch,我们赶紧发布了一篇 arXiv 论文,因为我们知道 Ilya 和谷歌的同事们在他们强大的 8 个 GPU LSTM 模型(RNN Search 仍在 1 个 GPU 上运行)上领先于我们。事后证明,这个名称不太好。更好的名称(attention)是由 Yoshua 在最终定稿中添加的。」

另一位作者 Kyunghyun Cho 是纽约大学计算机科学和数据科学教授,同时担任 Genentech Research & Early Development (gRED) Prescient Design 团队的前沿研究执行总监。2025 年,他被任命为 Glen de Vries 健康统计学教授。在获奖论文写作期间,他曾在蒙特利尔大学担任博士后研究员,师从 Yoshua Bengio 教授。

在 ICLR 时间检验奖颁发之际,或许我们也可以重读这些经典论文,从中找到关于未来方向的新启发。

参考链接:https://blog.iclr.cc/2025/04/14/announcing-the-test-of-time-award-winners-from-iclr-2015/